Twój koszyk jest obecnie pusty!

-

prof. dr hab. Dariusz Jemielniak

prof. dr hab. Dariusz Jemielniak

-

Krzysztof Mirończuk

Krzysztof Mirończuk

Najnowsze

Lenovo i CampusAI Twoim portalem wiedzy na temat sztucznej inteligencji – zyskaj roczny dostęp do platformy edukacyjnej CampusAI

Lenovo, globalny lider w dostarczaniu innowacyjnych technologii, rozszerza współpracę z CampusAI – jednym z czołowych ośrodków zajmujących się sztuczną inteligencją. Marki przygotowały projekt, którego celem jest poszerzanie wiedzy użytkowników na temat AI.…

AI + HR, czyli praktyczny przegląd narzędzi AI, które pomagają w administracji kadrowej

AI zmienia sposób prowadzenia rekrutacji, onboardingu czy pracy z dokumentami kadrowymi. Jakie konkretne narzędzia usprawniają administrację kadrową i w których obszarach mogą najbardziej odciążyć specjalistów HR?

Okiem eksperta: Hype się skończył, zaczyna się prawdziwa robota

Siedemdziesięcioletnia kobieta na spotkaniu ornitologicznym ostrzega koleżankę, że ChatGPT halucynuje. Prawnik pisze sobie własną aplikację AI. A ja po trzech latach pracy z niemal setką firm mogę Wam powiedzieć jedno: wreszcie przestaliśmy…

🔒 Kosmiczna loteria mózgów

czyli dlaczego Obcy mogą być albo nudni jak nosorożce, albo tak mądrzy, że tego nie przeżyjemy

Globalne imperia czy lokalne twierdze? AI a cyfrowa suwerenność

Globalne modele sztucznej inteligencji dominują na rynku, konsolidując potężną „władzę infrastrukturalną”. Decyzja o wyborze między rozwiązaniem z Doliny Krzemowej a lokalnym algorytmem to dziś nie kwestia natychmiastowych zysków, lecz strategiczna inwestycja w…

Newsletter

Otrzymuj najważniejsze informacje na swoją skrzynkę e-mail

Bądź na bieżąco

— z AI Flash

Nowy newsletter AI Flash co tydzień w Twojej skrzynce! Dostęp do najświeższych informacji ze świata sztucznej inteligencji, wywiady z ekspertami, felietony technologiczne, biznes i wiele innych!

Pierwszy w Polsce drukowany magazyn o sztucznej inteligencji

W najnowszym czwartym numerze otrzymasz ponad 160 stron wypełnionych wiedzą i przykładami pozytywnego zastosowania AI:

• Deepfejk i kryzys prawdy – rozmowa z profesorami o zagrożeniach

• Guardrails: Naprawdę przednia straż – o systemach bezpieczeństwa AI

• Uwaga, dane osobowe! – bezpieczne zarządzanie danymi w erze AI

Za jedyne 49,99 zł!

AI w pracy kreatywnej: kaganiec czy overdrive?

W debacie o narzędziach do generowania tekstu, obrazu czy muzyki ścierają się dwie skrajne obawy. Rośnie strach przed fałszywymi materiałami, naruszeniami praw autorskich oraz utratą kontroli artystów nad własną twórczością. Jednocześnie pojawia…

🔒 Seks, który napędza innowacje: o roli branży erotycznej w rozwoju technologii (i AI)

Branża erotyczna od dekad funkcjonuje jako nieoficjalne laboratorium testowe dla rozwiązań, które później trafiają do mainstreamu. A pornografia jest jednym z najskuteczniejszych akceleratorów innowacji technologicznych w historii.

Regulacyjny gorset czy cyfrowa tarcza? Dwie wizje przyszłości AI

Świat stoi przed dylematem: czy trzymać AI w ryzach paragrafów, czy zaufać mechanizmom wolnorynkowym i odpowiedzialności prawnej. Dla przedsiębiorców oznacza to konieczność kalkulacji, czy bardziej opłaca się inwestować w zapobieganie ryzyku, czy…

Zielony rachunek za AI: Czy centra danych czekają specjalne podatki?

Problem wpływu sztucznej inteligencji na klimat przestał być domeną aktywistów, a wszedł na agendę dyrektorów finansowych. Czy AI to kolejna rewolucja przemysłowa wymagająca swobody, czy może ekologiczny pasożyt, którego trzeba opodatkować u…

🔒 AI ogrzeje Twój dom? Nowa ekonomia ciepła

W obliczu nowych regulacji unijnych i rosnących kosztów energii, branża Data Center przechodzi fundamentalną transformację. Odpadowe ciepło, dotychczas utylizowane w atmosferze, staje się płynnym aktywem, które może zrewolucjonizować bilans energetyczny miast.

🔒 Para buch, koła w ruch

Jest rok 2045. W ośrodku fuzyjnym pod Marsylią, gdzie następca projektu ITER właśnie osiągnął stabilną reakcję termojądrową w temperaturze stu milionów stopni, inżynier sprawdza parametry… kotła parowego.

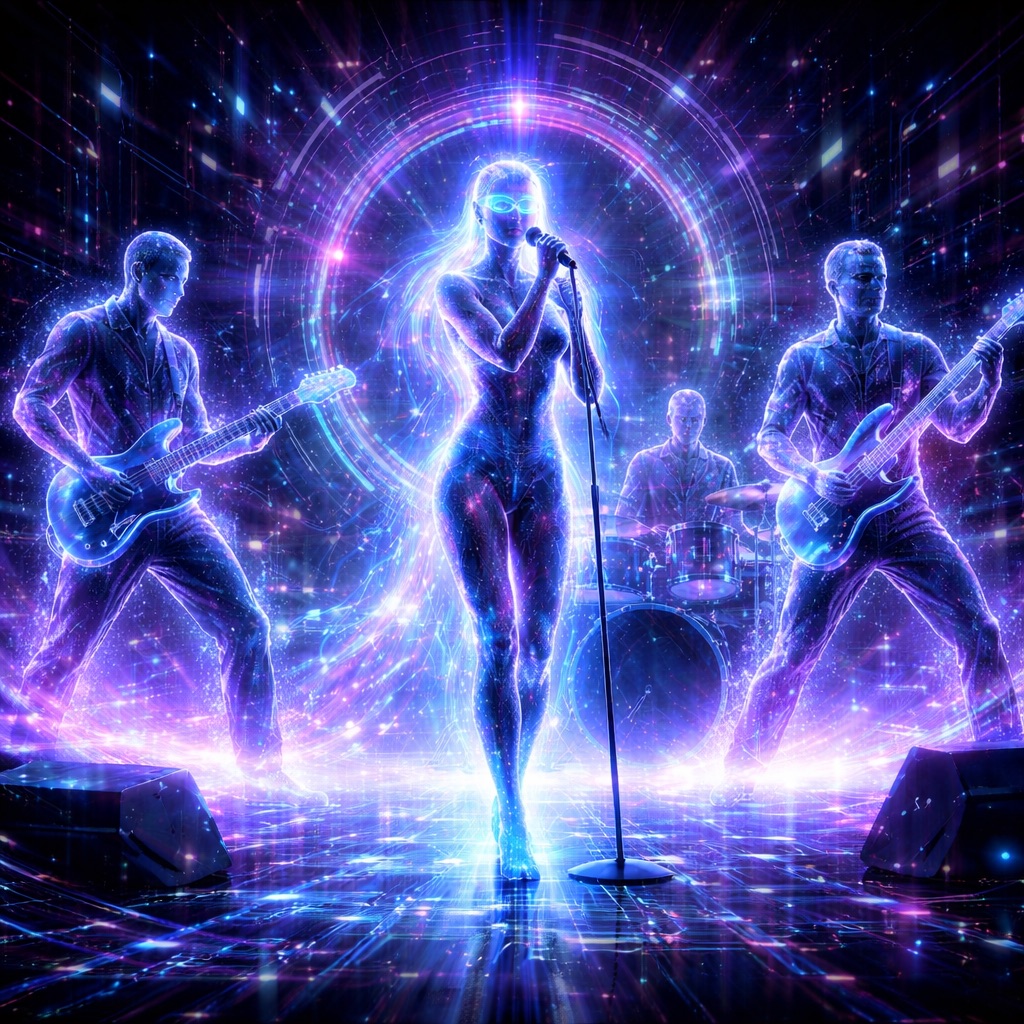

Uczy się czy… kradnie? Czyli spór o tantiemy, przyszłość kultury i granice automatyzacji

Debata o tantiemach za trenowanie modeli AI na cudzej twórczości to coś więcej niż spór o pieniądze. Z jednej strony stoi idea otwartego dostępu do wiedzy i tradycja fair use. Z drugiej…

Inteligencja na własnych warunkach. O definicyjnych wyborach w „Quo vAIdis” Andrzeja Dragana

Niektóre książki przekonują do swojej tezy. Inne – nieświadomie – uczą czytelnika, jakie pytania powinien zadać, zanim tezę przyjmie. „Quo vAIdis” należy do tych drugich i być może to jej największa wartość.

Zaufanie na sprzedaż? Gdy AI musi zarabiać

ChatGPT wprowadza reklamy. To nie tylko zmiana modelu biznesowego – to przesunięcie granicy między pomocą a wpływem w rozmowie, która coraz częściej zastępuje wyszukiwarkę i doradcę.

AI Act i RODO: uproszczenia jako test dojrzałości MŚP

Komisja Europejska przedstawiła pakiet Digital Omnibus czyli propozycje legislacyjne, które mają uprościć AI Act i RODO dla małych i średnich firm. Jest to zmiana sposobu myślenia regulatora o technologii w firmach poza…

Dołącz do CampusAI

WykorzystAI w pełni swój potencjał

Zacznij współpracować ze sztuczną inteligencją jeszcze dziś!

Nasi autorzy

dr Ewa Chamczyk

dr Inez Okulska

Kamil Świdziński

Seweryn Jakubiec

Joanna Kostecka

dr hab. Anita Ciesielska

Paulina Dalka-Kubaczyk

Adam Jędrusyna

Sebastian Kawecki

Zuzanna Czernicka

Katarzyna Jachymek

Joanna Neumann

Jeremiasz Krok

Marcin Pezowicz

Jagoda Miszewska

Ola Piwowarczyk

Adrian Kilar

Agnieszka Dahlke

Aleksandra Tomaszewska

Barbara Klaudel

Bartłomiej Balcerzak

Borys Jastrzębski

Darek Kłeczek

Dariusz Szawurski-Radetz

Dominika Bucholc

dr Adam Gonczarek

dr Daniel Ura

dr Dota Szymborska

dr Gabriela Bar

dr inz. Agnieszka Mikołajczyk-Bareła

dr inż. Marek Kozłowski

dr Marta M. Kania

dr Michał Nowakowski

Ewa Domagalska

Kamil Porembiński

Karol Stryja

Konrad Sowa

Magdalena Michalska-Niewiadomska

Magda Żuk

Martyna Schläpfer

Michal Dulemba

dr hab. inż. Michał Karpowicz

Michał Sadowski

Mikolaj Kowalczyk

Norbert Ryciak

Pamela Krzypkowska

Paulina Tomaszewska

dr Paweł Gora

Piotr Konieczny

Piotr Penar

prof. Przemysław Biecek

Przemysław Jóźwiakowski

Robert Firmhofer

Sabina Sujecka

Sebastian Kondracki

Zofia Dzik

Zuza Kwiatkowska

CampusAI

prof. dr hab. Dariusz Jemielniak

Redakcja

Ewa Siciak

Karolina Ceroń

Katarzyna Łukawska