Twój koszyk jest obecnie pusty!

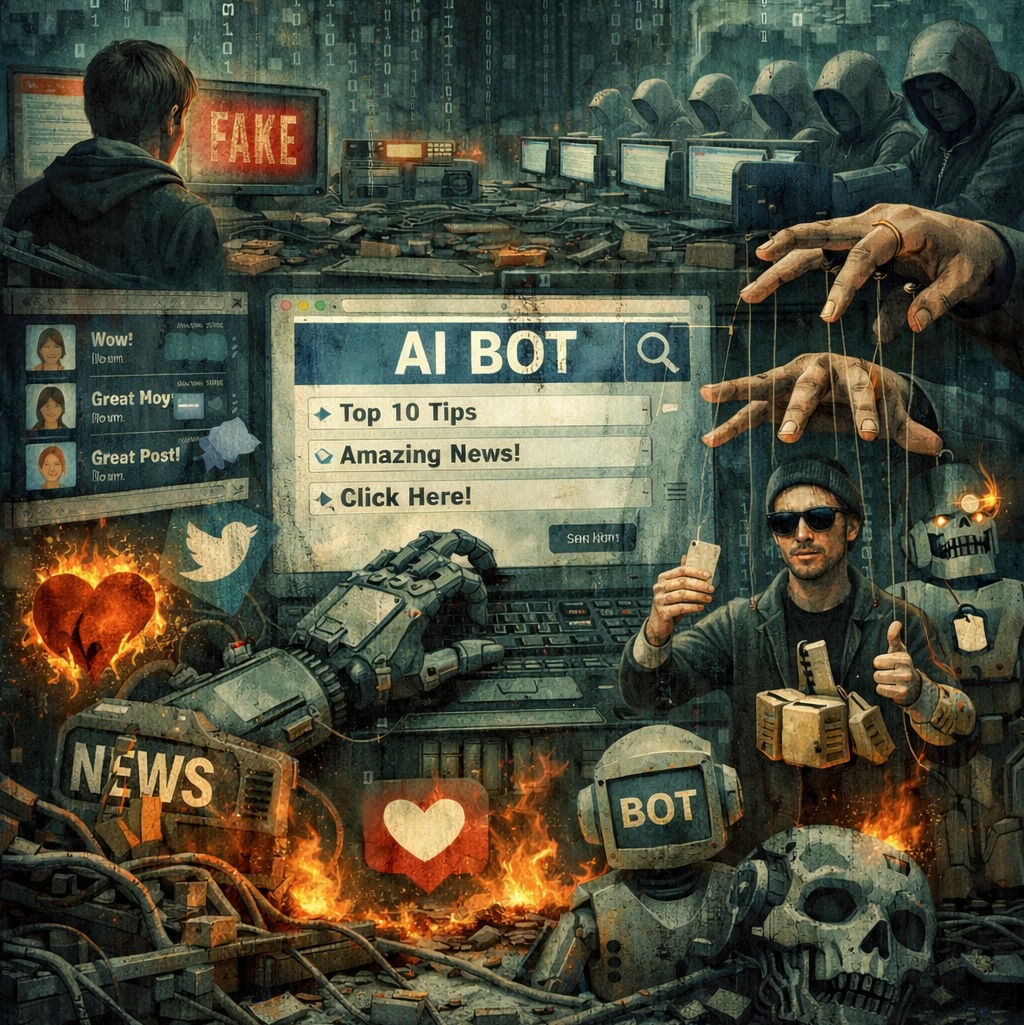

Jeszcze kilka lat temu Teoria martwego internetu brzmiała jak scenariusz dystopijnego filmu. Zrodzona na niszowych forach internetowych, takich jak 4chan, malowała obraz sieci-widma, cyfrowego cmentarzyska, gdzie większość treści jest generowana przez boty, a autentyczne ludzkie interakcje stanowią zaledwie nikły procent całości. Była to hipoteza łatwa do zignorowania, traktowana jako przejaw technologicznej paranoi lub futurologiczna fantazja. Jednak to, co wczoraj było fantazją, dziś znajduje potwierdzenie w danych, które układały się w niepokojący wzór na długo przed obecną rewolucją AI.

Boty jako cichy zwiastun zmiany

Fundament pod tę teorię położyły liczby. Raport „2024 Imperva Bad Bot Report”, analizujący ruch sieciowy w 2023 roku, przyniósł zatrważający wniosek: niemal połowa (48,9%) całego internetu była już wtedy zdominowana przez boty. Choć w tej liczbie mieszczą się zarówno programy szkodliwe, jak i te pożyteczne, trend był jednoznaczny. Internet stawał się coraz mniej ludzki. Był to sygnał ostrzegawczy, cichy zwiastun zmiany, która miała dopiero nadejść z pełną siłą.

Ale to nie wszystko. Analiza firmy Graphite obejmująca 65 tysięcy artykułów opublikowanych od 2020 do 2025 roku wykazała, że ponad połowa z nich została napisana przez modele językowe AI. To nie pojedyncze przypadki. To strukturalna zmiana, która redefiniuje obraz sieci jako medium kreowanego głównie przez ludzi.

Niektóre głosy ostrzegały przed tym wcześniej. Jak zauważyła Kaitlyn Tiffany w „The Atlantic”:

“In some sense, the people who believe the dead internet theory are right.”

Jej słowa, wypowiedziane w kontekście rosnącej automatyzacji treści dziś brzmią o wiele mniej jak publicystyczna prowokacja, a bardziej jak trafna diagnoza. Bo choć pierwotna teoria mówiła o rządowych spiskach i ukrywaniu prawdy, to jej fundamentalna intuicja – internet coraz mniej tworzony przez ludzi – zaczyna mieć twarde podstawy.

Mniej ludzi, więcej algorytmów

Katalizatorem, który zamienił powolny trend w gwałtowną lawinę okazała się eksplozja generatywnej sztucznej inteligencji. Upowszechnienie potężnych modeli językowych i graficznych sprawiło, że kluczowe założenia Teorii martwego internetu przestały być hipotezą, a stały się realnym, mierzalnym zjawiskiem. Skala i tempo automatycznego tworzenia treści przerosły wszelkie dotychczasowe wyobrażenia, zaburzając fundamentalną proporcję między tym, co autentyczne, a tym, co syntetyczne.

Problem ten nie jest już abstrakcyjny. Mamy coraz więcej danych ukazujących jego materializację. Organizacja NewsGuard monitorująca wiarygodność źródeł w sieci w swoim regularnie aktualizowanym raporcie „AI-Generated News Tracking Center” zidentyfikowała już ponad 1200 niewiarygodnych portali informacyjnych, które działają w 17 językach i są w całości lub w dużej mierze generowane przez AI. Te farmy treści zalewają wyniki wyszukiwania niskiej jakości artykułami SEO, poradnikami pozbawionymi wartości i fałszywymi newsami, których jedynym celem jest przyciągnięcie ruchu.

Badanie opublikowane przez Originality.ai wykazało, że 41,18% dłuższych postów na Facebooku (powyżej 100 słów) zostało wygenerowanych przez modele językowe AI.

Oznacza to, że niemal co drugi dłuższy wpis, który widzi przeciętny użytkownik nie powstał w wyniku ludzkiej refleksji, doświadczenia ani opinii, lecz jako wynik działania algorytmu.

Podobne procesy zachodzą na platformie X. Badania Harvard Misinformation Review pokazały, że syntetyczne obrazy i wideo wygenerowane przez narzędzia takie jak Midjourney V5 osiągnęły ponad 1,5 miliarda wyświetleń. To ogromna liczba świadcząca o tym, że odbiorcy konsumują treści syntetyczne nieświadomie i na masową skalę.

Treść jako toksyczne paliwo dla AI

Problem jednak nie kończy się na tym, że internet staje się mniej ludzki. Zaczyna się coś znacznie poważniejszego. Internet staje się także mniej użyteczny jako zbiór danych do trenowania modeli AI. Wyjaśnia to koncepcja model collapse – degradacji modeli, które uczą się na treściach generowanych przez inne modele, zamiast na treściach tworzonych przez ludzi.

Jak napisali badacze w publikacji w Nature (Shumailov, I., Shumaylov, Z., Zhao, Y. et al. AI models collapse when trained on recursively generated data. Nature 631, 755–759):

“Recursive training on synthetic data leads to irreversible defects in the tails of the original content distribution.”

Innymi słowy: im więcej modele uczą się same od siebie, tym szybciej tracą zdolność do odwzorowywania rzeczywistości.

Z kolei badacze z University of Texas w Austin, Texas A&M i Purdue obserwują zjawisko, które określają jako LLM brain rot. Twierdzą oni:

“Models exposed to viral, engagement-optimized content exhibit measurable cognitive decay.”

Gdy systemy trenują się na treściach zoptymalizowanych pod zasięg – uproszczonych, skondensowanych i pozbawionych głębi, to same zaczynają myśleć w sposób uproszczony. To mechanizm, który może wprowadzić sztuczną inteligencję w spiralę autodegradacji.

Skutki wykraczające znacznie poza internet

Jeśli internet faktycznie przechyla się w stronę syntetyczności, konsekwencje dotyczą nie tylko jakości publikowanych treści. Dotykają również gospodarki, technologii oraz przyszłości modeli AI, które potrzebują wysokiej jakości danych jak paliwa.

Po pierwsze, rośnie znaczenie tzw. „czystych danych”. Treści sprzed ogromnego wybuchu generatywnej AI. Organizacje, które mają do nich dostęp zyskują przewagę strategiczną, ponieważ mogą trenować modele na materiałach nieskażonych syntetycznością. W praktyce oznacza to, że różnice jakości między firmami mogą wynikać nie z algorytmów, lecz właśnie z dostępności odpowiednich zbiorów danych.

Po drugie, rośnie skala błędów generowanych przez modele. Przywoływane w analizach technologicznych testy modeli OpenAI O3 i O4-mini pokazały, że halucynacje, czyli przekonująco brzmiące, ale fałszywe odpowiedzi pojawiały się odpowiednio w 33% i 48% przypadków. To nie są drobne pomyłki. To niedokładności, które mogą podważać zaufanie użytkowników do narzędzi AI i ograniczać ich zastosowania w obszarach wysokiego ryzyka. Po trzecie wytwarza się środowisko, w którym coraz trudniej jest odróżnić treści pisane przez ludzi od treści generowanych przez modele. Granica między nimi zaciera się, a wraz z nią zanika czytelność internetu jako medium społecznego. Jeśli użytkownik nie wie, z kim rozmawia, a często nie może się tego dowiedzieć, to komunikacja cyfrowa zaczyna tracić swoją podstawową funkcję.

Tak zarysowana zmiana przypomina nie tyle śmierć internetu, co jego przebudowę. Ale jest to przebudowa, w której rola człowieka staje się coraz bardziej marginalna.

Świat, w którym musimy nauczyć się żyć od nowa

W ten sposób teoria, która kiedyś funkcjonowała na obrzeżach cyfrowego świata, dziś stała się centralnym wyzwaniem naszej epoki. Pytanie nie brzmi już, czy internet umiera, ale jak mamy nauczyć się funkcjonować w jego nowej, coraz bardziej syntetycznej rzeczywistości. Przestajemy debatować nad fantastyczną hipotezą, a zaczynamy budować praktyczne narzędzia do przetrwania.

W obliczu tego wyzwania rodzą się konkretne odpowiedzi. Jedną z najważniejszych jest projekt C2PA (Coalition for Content Provenance and Authenticity), sojusz technologicznych gigantów, takich jak Adobe, Microsoft, Intel czy BBC. Inicjatywa ta tworzy otwarty standard techniczny pozwalający dołączać do plików cyfrowych zaszyfrowane metadane o ich pochodzeniu. To swego rodzaju cyfrowy certyfikat autentyczności. To jedna z pierwszych, systemowych prób zbudowania mechanizmów obronnych, które pozwolą weryfikować treści na masową skalę.

Nawigacja w martwiejącym internecie staje się nową, kluczową umiejętnością. Być może czeka nas renesans zamkniętych, zweryfikowanych społeczności i powrót do źródeł, którym można ufać. Jedno jest pewne – scenariusz, który kiedyś wydawał się odległą fantastyką, dziś staje się instrukcją obsługi świata, w którym musimy nauczyć się żyć na nowo.