Twój koszyk jest obecnie pusty!

Inez Okulska: Bezpieczeństwo w kontekście sztucznej inteligencji jest odmieniane przez wszystkie przypadki. I wielcy gracze, i początkujący entuzjaści coraz częściej czują, że te dwa pojęcia, choć nie zawsze łatwe do pogodzenia (patrz: huczne zwolnienia w big techach właśnie na tym polu), muszą jednak iść ramię w ramię. Czy ryzyko to wada jedynie złych modeli, czy nieodzowny aspekt tej technologii? Co właściwie oznacza „bezpieczeństwo AI” w przypadku biznesu i codziennego życia?

Przemysław Biecek: Parafrazując zasadę Anny Kareniny: wszystkie dobre modele są do siebie podobne, każdy zły model jest zły na swój sposób. To powiedzenie świetnie się sprawdza w badaniu bezpieczeństwa modeli sztucznej inteligencji. Sprawiedliwa (unbiased), zabezpieczona (secure), zaufana (trusted), odporna (robust), zrozumiała (transparent), sprawdzona (verified) – to jedynie przykładowe definicje bezpiecznej AI. Od bezpiecznego modelu wymagamy bardzo wielu pożądanych cech, a porażka w co najmniej jednej z nich powoduje, że model uznamy za wadliwy, a czasem wręcz niebezpieczny. Słowo „bezpieczny” jest tu parasolem dla wielu kryteriów, które chcemy mieć spełnione.

Model może być bezpieczny, tak jak bezpieczny jest dom, do którego nikt się nie włamie, bo ma system zabezpieczeń, alarmy i zamki. W tym przypadku to oznacza, że żaden niepożądany aktor nie będzie wpływał na działanie modelu, nie zaburzy jego wyników. Coraz więcej przedsiębiorstw opiera się na modułach AI, więc kluczowe jest zagwarantowanie, że te moduły nie będą manipulowane przez wrogą konkurencję, nieprzychylnych użytkowników czy innych graczy o złych intencjach.

Ale model może być bezpieczny jak dom, w którym czujemy się dobrze, bo panuje w nim szczęście, sprawiedliwa i wspierająca atmosfera. W tym przypadku bezpieczeństwo może oznaczać zaufanie i brak dyskryminacji. Jeżeli w moim codziennym życiu pewne decyzje, takie jak dostęp do dobrej edukacji lub leczenia, zależą od rekomendacji algorytmów AI, to najważniejsza jest pewność, że te moduły nie będą mnie dyskryminowały z uwagi na wiek, kolor skóry, płeć czy inne cechy niezwiązane bezpośrednio z przedmiotem decyzji.

Wreszcie model może być też bezpieczny jak dom, który nie wybucha, bo instalację elektryczną czy gazową regularnie sprawdzają wykwalifikowani pracownicy. W tym przypadku bezpieczeństwo oznacza redukcję ryzyka pożaru, porażenia prądem, zatrucia gazem. Jeżeli w mojej firmie kluczowa część biznesu opiera się na module AI, to nie chcę, by jego awaria doprowadziła do niekontrolowanej liczby pozwów lub zażaleń, które mogą zatopić moją firmę.

Nie ma jednej definicji bezpieczeństwa, mamy za to wiele przykładów błędnie działających modeli. Jako społeczność dopiero się uczymy konstruować odpowiednie standardy bezpieczeństwa, odkrywamy zupełnie nowe wyzwania związane z tym obszarem. Dlatego praca nad bezpiecznymi modelami jest tak fascynująca.

IO: Skoro tak wiele rzeczy może pójść źle, to czy istnieją bazy danych, które dokumentują przypadki, gdy AI zawiodła? I czego biznes może się z nich nauczyć?

PB: Istnieje kilka takich baz danych i co jakiś czas pojawiają się nowe. Ja najczęściej śledzę i polecam bazę IncidentDatabase.AI zawierającą setki dobrze udokumentowanych błędów i szkód powstałych w wyniku nieprawidłowego działania systemów AI. To świetne repozytorium, ponieważ systematycznie gromadzi i analizuje przypadki, w których AI działała źle – od stronniczych algorytmów po spektakularne błędy w systemach autonomicznych. To skarbnica wiedzy dla badaczy, inżynierów oraz każdego, kto chce budować lepszą i bezpieczniejszą AI.

Jest też ranking Epic fAIls, który od jakiegoś czasu organizuję. To coroczne zestawienie najbardziej spektakularnych błędów sztucznej inteligencji, które zostały wykryte w danym roku. Znajdziesz tam przykłady, które pokazują, jak bardzo AI potrafi nas zaskoczyć, ale też boleśnie rozczarować.

Przykładowo trzecie miejsce w plebiscycie za rok 2024 otrzymał model transkrypcyjny Whisper. W październiku 2024 r. ujawniono, że ten model, opracowany przez OpenAI, zoptymalizowany, by „wygładzać” tekst, popełniał poważne błędy w zastosowaniach medycznych, prowadząc do tzw. halucynacji – generował elementy tekstu, których nie było w pierwotnym nagraniu. Mimo ostrzeżeń OpenAI przed stosowaniem Whispera w „obszarach wysokiego ryzyka” narzędzie to zostało wdrożone w ponad 40 systemach opieki zdrowotnej i objęło ponad 30 tys. pracowników medycznych, na przykład w Children’s Hospital w Los Angeles. Badania wykazały, że w 80% analizowanych transkrypcji z publicznych spotkań Whisper wprowadzał nieistniejące treści. Inne badanie pokazało, że w prawie wszystkich z 26 tys. przetestowanych transkrypcji pojawiały się halucynacje – treści, które nie istniały w oryginalnym wywiadzie. W kontekście medycznym tego rodzaju błędy mogą prowadzić do poważnych konsekwencji, takich jak błędne diagnozy czy nieporozumienia między personelem medycznym a pacjentami, błędna dokumentacja historii pacjenta. W jednym z przypadków Whisper dodał fikcyjny tekst, w którym stwierdzono, że oso- by „były czarne”, mimo że takiej informacji nie było w oryginalnym nagraniu. Innym razem neutralne wypowiedzi zostały przekształcone w treści o charakterze przemocowym.

IO: Mocne! A to dopiero trzecie miejsce. To jak spektakularna porażka zmiotła konkurencję?

PB: Szczegółowe omówienie wyników plebiscytu można znaleźć w podcaście nagranym dla Pulsara, ale zdradzę, że największą wtopą roku 2024 okazał się model Gemini, który miał eliminować uprzedzenia i dyskryminację, a zamiast tego generował historycznie niepoprawne obrazy.

Gemini, rozwijany przez Google DeepMind, został zaprojektowany z myślą o inkluzywności i zapobieganiu uprzedzeniom w generowanych treściach. Jednak w lutym 2024 r. użytkownicy odkryli, że model nadmiernie próbował wprowadzać różnorodność etniczną nawet w kontekstach, w których było to historycznie niepoprawne. W odpowiedzi na prośbę o wygenerowanie zdjęć historycznych postaci, takich jak amerykańscy ojcowie założyciele, papieże czy rzymscy cesarze, model często przedstawiał je jako osoby o różnorodnym pochodzeniu etnicznym, po- mijając realia historyczne. Największe oburzenie wy- wołało generowanie nazistów, żołnierzy niemieckich z czasów drugiej wojny światowej jako osób o różnym kolorze skóry, co zostało uznane za zniekształcanie historii.

Podobne problemy pojawiały się w generowaniu obrazów historycznych scen, takich jak średniowieczna Europa czy starożytna Grecja, gdzie Gemini nadmiernie poprawiał ich demografię, by uniknąć oskarżeń o dyskryminację. Po fali krytyki firma Google oficjalnie przeprosiła za błąd i czasowo wycofała możliwość generowania obrazów w Gemini. Firma przyznała, że ich system próbował „aktywnie przeciwdziałać stereotypom”, ale zrobił to w sposób zbyt agresywny, co doprowadziło do halucynacji niezgodnych z faktami. To zdarzenie stanowi doskonały przykład trudności związanych z etycznym zarządzaniem danymi i biasem w modelach AI. Pokazuje, jak skomplikowane jest balansowanie między inkluzywnością a wiernością historycznym faktom. Wiele osób wskazywało, że AI powinna dążyć do obiektywności zamiast próbować „poprawiać” historię według współczesnych standardów.

IO: Jeśli na czele tej mało chlubnej stawki są nawet giganci i narzędzia, na których chcemy i możemy polegać, to co powinniśmy robić? Moim zdaniem jednak sam fakt, że takie rankingi powstają, jest budujący. Świadczy o tym, że potrafimy zaglądać pod podszewkę i analizować działanie modeli – choćby po to, by czasem odkryć, jak bardzo błądzą.

PB: Jednym z narzędzi analizy modeli jest rozwój obszaru wyjaśnialnej sztucznej inteligencji (Explainable AI, XAI), czyli technik, które pozwalają nam zrozumieć, dlaczego model podjął daną decyzję. Za- miast traktować AI jak magiczne pudełko, możemy budować systemy, które tłumaczą swoje wyniki (np. w medycynie AI nie powinna tylko powiedzieć: „To rak”, ale wskazać, które obszary obrazu doprowadziły do takiej diagnozy), umożliwiają audyt i testowanie (zamiast wierzyć na słowo, możemy sprawdzać, czy model działa uczciwie, np. w finansach czy rekrutacji), ostrzegają przed własnymi ograniczeniami (zamiast halucynować, AI mogłaby mówić: „Nie jestem pewna” lub wskazywać poziom swojej pewności).

Czy ryzyka są wpisane w AI? Tak, ale to nie znaczy, że musimy się z nimi pogodzić. Lepsza transparentność to bezpieczniejsze systemy – zarówno dla biznesu, jak i dla użytkowników.

IO: Podzielisz się konkretnym przykładem wdrożenia wyjaśnień modelu i ich znaczenia?

PB: Podam nawet dwa przykłady. Dwa lata temu mój zespół budował rozwiązanie wspierające detekcję ciężkiego zapalenia nerek dla pacjentów po ciężkim przejściu choroby covid. Trudny temat, ponieważ powikłania po tej chorobie były wciąż mało poznane i intuicję lekarzy trzeba było na bieżąco porównywać z wynikami eksperymentalnych analiz dla pacjentów ze szpitala. Dosyć szybko udało nam się zbudować system predykcyjny oceniający ryzyko, ale lekarze nie ufali mu, ponieważ nie chcieli podejmować decyzji mających duże konsekwencje w oparciu o model, którego działania nie znali. Dopiero zastosowanie zbioru metod naszego autorskiego algorytmu Interaktywnej Wyjaśnialnej Analizy Modelu zwiększyło ich zaufanie do wyników modeli. Można było w prosty sposób sprawdzić, które cechy pacjenta są najważniejsze dla prognozy, i zobaczyć, jak zmieniałaby się ta pro- gnoza, gdyby określone parametry przyjmowały mniejsze lub większe wartości.

Drugi ciekawy przykład bezpośredniego użycia wyjaśnialnej AI w biznesie to współpraca z firmą KP Labs tworzącą algorytmy AI w zastosowaniach kosmicznych. Nasza współpraca miała dynamikę określaną jako Blue Team vs. Red Team. Zespół z KP Labs budował modele predykcyjne dla zdjęć hiperspektralnych w zastosowaniach obserwacji Ziemi, tworzył najlepsze modele gotowe do zastosowań w bardzo wymagającym środowisku. Nasz zespół odgrywał rolę red teamu – szukał słabości i podatności zbudowanych modeli, sugerując, w jaki sposób można je poprawić. Tego typu rozwiązania są stosowane w sytuacjach, gdy systemy AI muszą być niezawodne, np. w obronności, służbie zdrowia czy zastosowaniach kosmicznych. Niezależne pary oczu w postaci red teamu pozwalają wyeliminować wiele łatwych do przeoczenia błędów.

IO: Narzędzia, o których mówisz, dotyczą raczej mniejszych modeli, a co z dużymi, generatywny- mi? Nadal jesteśmy w stanie je wyjaśniać czy raczej przybliżać się do ich względnego okiełznania? Tradycyjne metody są jeszcze przydatne?

PB: I tak, i nie. Podstawowe koncepcje są podobne i pewne narzędzia techniczne – jak na przykład analiza gradientów – mają również zastosowanie, ale duże modele językowe to inna liga, jeśli chodzi o wyjaśnialność. W klasycznych systemach AI, takich jak modele medyczne czy systemy predykcyjne, można stosować dość intuicyjne techniki XAI, choćby pokazując, które cechy danych miały największy wpływ na decyzję modelu.

Natomiast LLM-y (Large Language Models) działają w sposób sekwencyjny i probabilistyczny – nie „podejmują decyzji”, lecz przewidują najbardziej prawdopodobne kolejne słowo na podstawie miliardów parametrów. Ich „rozumowanie” niełatwo uchwycić. Wyjaśnianie ich działania to bardziej analiza wpływu poszczególnych fragmentów tekstu niż klasyczne pytanie, dlaczego podjęto taką decyzję. Z drugiej strony można je testować bardziej intuicyjnie, np. poprzez zadawanie różnych pytań i analizowanie wzorców odpowiedzi.

IO: Czyli zamiast przybliżania funkcji analiza behawioralna.

PB: To jest o tyle istotna różnica, że wyjaśnialność modeli językowych nie polega jedynie na próbie ich zrozumienia – stanowi także klucz do ich kontroli. Często gdy mówimy o Explainable AI, myślimy o analizowaniu, dla- czego model popełnia błędy – dlaczego dyskryminuje, dlaczego konfabuluje, dlaczego generuje szkodliwe treści. Ale w przypadku LLM-ów równie ważne – jeśli nie ważniejsze – jest ostatecznie skuteczne zarządza- nie tym, jak model się zachowuje. Wyobraźmy sobie system AI używany w automatycznej moderacji treści. Samo zrozumienie, dlaczego model oznacza pewne komentarze jako szkodliwe, jest cenne, ale niewystarczające. Kluczowe jest to, czy możemy ten model do- stroić tak, by robił to w sposób przewidywalny i zgodny z naszymi celami.

Podobnie w przypadku konfabulacji – wiemy, że modele językowe „halucynują”, ale zamiast jedynie analizować, dlaczego to robią, powinniśmy szukać metod na ich ograniczanie, wykrywanie lub przynajmniej oznaczanie w czasie rzeczywistym. W praktyce, szczególnie biznesowej, samo wyjaśnienie genezy błędu nie wystarczy, nie zniweluje jego konsekwencji. Gdy model LLM traktuje się jak wyszukiwarkę informacji medycznych, konfabulacja jest bardzo szkodliwa. Ale gdy wykorzystuje się go jako wsparcie w przygotowaniu opowiadania science fiction, większa kreatywność kosztem mniejszej poprawności nie będzie nas raziła, a może nawet okaże się zaletą.

Jeśli nie mamy kontroli nad AI, to tak, jakbyśmy sterowali samolotem bez możliwości korekty kursu – wiemy, jak działa autopilot, ale nie możemy go zatrzymać, gdy leci w złą stronę. Dlatego wyjaśnialność w LLM-ach to coś więcej niż analiza – to sposób na realne zarządzanie ryzykiem i poprawę bezpieczeństwa tych systemów.

IO: A możesz opowiedzieć z własnego doświadczenia, jak w takim razie kontrolować modele LLM?

PB: Rozwijamy różne metody, które mogą być za- stosowane do większej kontroli modeli. Trudno przewidzieć, która się upowszechni, ale moim zdaniem dzisiaj najbardziej obiecujące są tzw. rzadkie autoenkodery [sparse autoencoders; metoda opisana w tym numerze w artykule Pauliny Tomaszewskiej – przyp. red.]. Polegają one na „włożeniu” do modelu specjalnej nakładki, która rozkłada jego działanie na tysiące różnych konceptów. Możemy później znajdować interesujące nas koncepty, np. odpowiadające za agresję w odpowiedziach, natężenie emocjonalne itp., a następnie tłumić lub wzmacniać określone koncepty i odpowiadające im części modelu. Jeżeli chcemy mieć model generujący odpowiedzi bez języka nienawiści, to szukamy konceptów związanych z mową nienawiści i je wyłączamy. A gdy ten sam model chcemy stosować do filtrowania komentarzy w mediach społecznościowych, zwiększamy jego czułość na tego rodzaju koncepty.

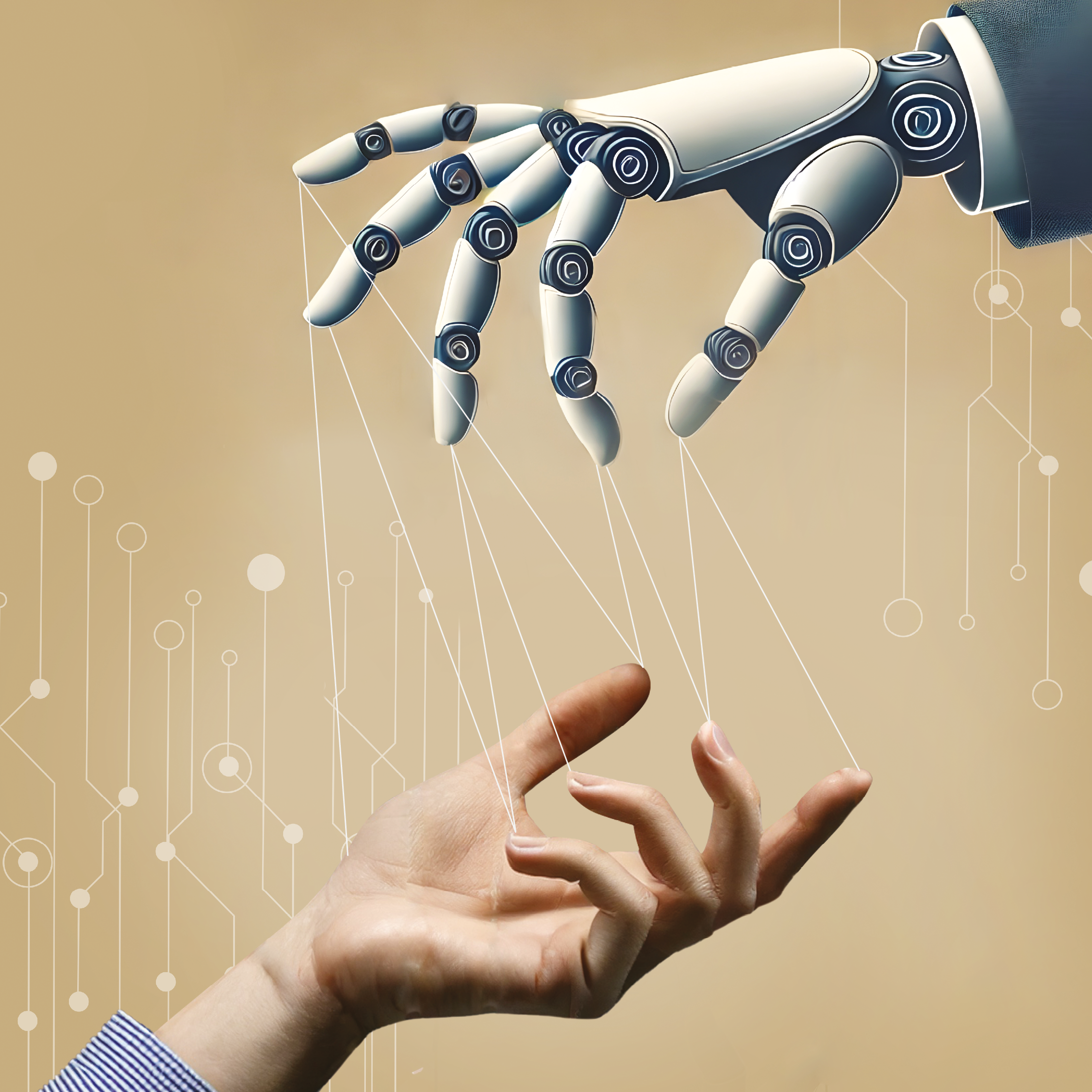

IO: A jeśli to one na nas próbują wpływać swoimi wypowiedziami? Powiedzmy sobie szczerze: retorycznie są przecież naprawdę zaskakująco sprawne.

PB: No właśnie, bardzo interesującym aspektem tych modeli, wynikającym wprost ze sposobu ich trenowania, jest kwestia perswazyjności. Właśnie skończyliśmy badania nad tym, jak duże modele językowe (LLM-y) dostosowują swoje odpowiedzi, aby wpływać na użytkowników o różnych cechach osobowości. Badaliśmy kluczowe cechy lingwistyczne, istotne w perswazji skierowanej do osób o zróżnicowanych poziomach tych cech. Porównaliśmy 19 różnych modeli LLM pod kątem ich możliwości dostosowania się do osobowości rozmówcy w celu zwiększenia ich perswazyjności. Wyniki wskazują, że modele używają więcej słów związanych z lękiem, gdy wyczują odbiorcę neurotycznego, rozbudowują język sukcesu w przypadku osoby sumiennej, a tak- że ograniczają lub wzbogacają słownictwo z zakresu procesów poznawczych w zależności od otwartości na doświadczenia użytkownika. Niektóre rodziny modeli lepiej dostosowują język do jednego typu, inne do drugiego, podczas gdy tylko jedna rodzina modeli adaptuje język w zakresie neurotyczności. Okazuje się, że LLM-y potrafią dostosowywać swoje odpowiedzi na podstawie wskazówek dotyczących osobowości w promptach, co wskazuje na ich potencjał tworzenia perswazyjnych treści wpływających na umysł i dobrostan odbiorców. Często myślimy o modelach LLM jak o dużych wyszukiwarkach, ale w rzeczywistości są to szalenie skuteczne narzędzia perswazji.

IO: Jeśli nie powiało grozą, to na pewno lekkim zaskoczeniem. Skoro wciąż trzeba uważać na tyle pułapek w kontekście współczesnych modeli AI, to czy powiedziałbyś, że jest za wcześnie, by z czystym sumieniem wdrażać je w firmach?

PB: Nie, to trochę jak z samochodami – nie prze- stajemy z nich korzystać tylko dlatego, że mogą się zepsuć. Zamiast tego inwestujemy raczej w pasy bezpieczeństwa, systemy ABS i kontrolę jakości. Podobnie z AI – zamiast rezygnować, powinniśmy po prostu rozwijać lepsze metody nadzoru i wyjaśnialności, globalnie nie szczędzić na to ani zasobów intelektualnych, ani finansowych.

Badacze z mojego zespołu MI2.AI od wielu lat do- wodzą, że modele mogą być nie tylko czarnymi skrzynkami, że da się je interpretować i nad nimi panować. Ich prace nad wyjaśnialnością modeli pokazują, że transparentność i kontrola sztucznej inteligencji to nie tylko teoria – to coś, co już się dzieje i może sprawić, że technologie będą bezpieczniejsze. Więc zamiast pytać: „Czy powinniśmy używać AI?”, lepiej zapytać: „Jak sprawić, by była bezpieczna i pod naszą kontrolą?”.