Twój koszyk jest obecnie pusty!

Co więcej – wszyscy wokół twierdzili, że już z niej korzystają (chociaż badania Polskiego Instytutu Ekonomicznego wskazują, że z AI korzysta zaledwie 6,6% polskich firm).

Nasza firma wprawdzie działała sprawnie, realizowała założone cele, przechodziliśmy głęboką transformację cyfrową, wdrażaliśmy nowe procesy, również te związane z budowaniem własnych narzędzi IT, usprawniające codzienną pracę, ale… wciąż nie mieliśmy AI. To wystarczyło, żeby dotknął nas klasyczny syndrom FOMO (ang. Fear of missing out). A ten może nie być najlepszym doradcą, bo AI to przecież nie jest coś, co warto wdrażać bez szerszego planu i przemyślanej strategii. Ważne też, żeby sztuczna inteligencja rozwiązywała rzeczywiste problemy, a nie była jedynie fajerwerkiem, którego wymagają aktualne trendy w marketingu.

Pojawiła się presja, żeby wskoczyć do tego – jak się wydawało – całkiem już rozpędzonego pociągu jeszcze nowszych technologii. Tym bardziej, że czuliśmy, że jesteśmy świadkami przełomu, że ta technologia, której raczkowanie obserwujemy, ma ogromny potencjał biznesowy. Wreszcie na jednym ze spotkań zarządu podjęta została decyzja – tak, wchodzimy w to. Najpierw zapadła cisza, a potem się zaczęło. Lawina pomysłów, narzędzi, możliwych zastosowań, inspiracji, „a gdyby tak” i „a można by jeszcze”.

Na szczęście w Connectis mamy zespół naprawdę doświadczonych managerów, którzy ostatecznie zdołali zebrać, ułożyć i połączyć w spójną całość zbiór potrzeb i możliwości. I chaos się skończył.

Rozpoczął się natomiast przemyślany proces wdrażania nowego, dynamicznego – ale jednak narzędzia, jakim jest sztuczna inteligencja. Bo mimo że niezwykle efektowna, w wielu przypadkach nawet bardzo efektywna, to ostatecznie środek do osiągnięcia celu, a nie cel sam w sobie.

Zajrzeliśmy więc w głąb organizacji. Najpierw zmapowane zostały wszystkie procesy wewnętrznie realizowane w firmie, na poziomie makro i mikro, po to, by zidentyfikować prawdziwe „punkty bólu” (ang. painpoints), czyli miejsca, które wymagają ulepszenia. Ostatecznie wyłoniliśmy proces, który ma duży potencjał optymalizacji, łatwe do określenia mierniki sukcesu i który po wstępnym zbadaniu uznaliśmy za możliwy do usprawnienia dzięki AI.

Otóż jednym z kluczowych wyzwań, z jakim się mierzymy, jest znalezienie odpowiedniego kandydata do realizacji projektu, który będzie spełniał konkretne wymagania klienta. Zgodnie z naszą strategią dotyczącą standardów jakości, interesują nas wyłącznie kandydaci najlepiej dopasowani, wyróżniający się i umiejętnościami, i doświadczeniem. Jak się łatwo domyślić, to cel, do którego prowadzą setki godzin spędzone na weryfikacji potencjalnych kandydatów i ich CV, które albo już znajdowały się w naszej bazie, albo zostały świeżo nadesłane. Stworzyliśmy wprawdzie już wcześniej narzędzia do automatycznego dopasowywania kandydata, ale wymagają one ustrukturyzowanych danych – zarówno po stronie klienta, wypełniającego ankietę potrzeb, jak i po stronie kandydata. A jak wiadomo, tyle szablonów życiorysów, ile oferujących je stron w internecie, więc o spójności można tylko pomarzyć. Natomiast manualna analiza i przepisanie danych z CV do bazy danych w potrzebnym formacie zajmuje od 15 do 30 minut na jeden tylko dokument, a i tak jest narażona na błędy. Co więcej, taka dodatkowa monotonna praca zniechęcała rekruterów. Przy skali, w jakiej operujemy (ok. 1000 życiorysów tygodniowo) traciliśmy ok. 80% dokumentów, które do nas spływały, bo nie byliśmy ich w stanie w pełni przetworzyć. I tu właśnie objawiła się paląca potrzeba optymalizacji – nasz punkt bólu – potrzebowaliśmy narzędzia do automatycznej ekstrakcji danych z różnego formatu dokumentów aplikacyjnych do formatu wymaganego przez istniejący już system do dopasowania kandydatów do klientów. Ta różnorodność formatów na wejściu sprawiała właśnie, że zadanie było wbrew pozorom nietrywialne i wymagało zaawansowanych modeli sztucznej inteligencji.

Jeżeli chodzi o przetworzenie CV, podstawowym wyzwaniem są różne formy układu tekstowego i graficznego. Część danych jest opisowa, część w formie grafik (np. umiejętności oznaczone liczbą gwiazdek, doświadczenie przedstawione jako lata lub poziom eksperckości) – graficzne szablony oferowane przez popularne narzędzia cieszą oko, ale rzucają wyzwanie algorytmom. Część informacji napisana jest wprost, inne trzeba wywnioskować z kontekstu. Łatwo jest napisać model, który przetworzy standardowe profile na LinkedIn (gdzie wszystkie mają tę samą, z góry zadaną, strukturę), a gorzej, gdy wariantów formy dokumentu może być bardzo wiele.

No dobrze, czyli już dokładnie wiedzieliśmy, co chcemy usprawnić z pomocą AI, teraz pozostawało pytanie, jak to zrobić.

Czy w modelu inhouse, czy sięgając po outsourcing? Z użyciem jakich narzędzi? Na tym etapie utknęliśmy na dość długo, gdyż rozmowy z kolejnymi ekspertami i dostawcami, każde spotkanie i kolejna dawka wiedzy sprawiały, że mieliśmy coraz więcej pytań. Dowiedzieliśmy się, że proces uczenia maszynowego będzie bardzo długi i będzie wymagał ogromnej ilości danych – a mowa przecież o danych potencjalnie wrażliwych. Że nie da się załadować do dużego modelu językowego (LLM) dowolnej ilości informacji (bo ma ograniczony tzw. kontekst), a poza tym przy generacji odpowiedzi i tak najczęściej korzysta tylko z niewielkiego ich wycinka. Dowiedzieliśmy się, jak skonstruowane są LLM-y bazujące na tokenach i jakie są ograniczenia z tym związane, zbadaliśmy różnice pomiędzy różnymi modelami generatywnej AI.

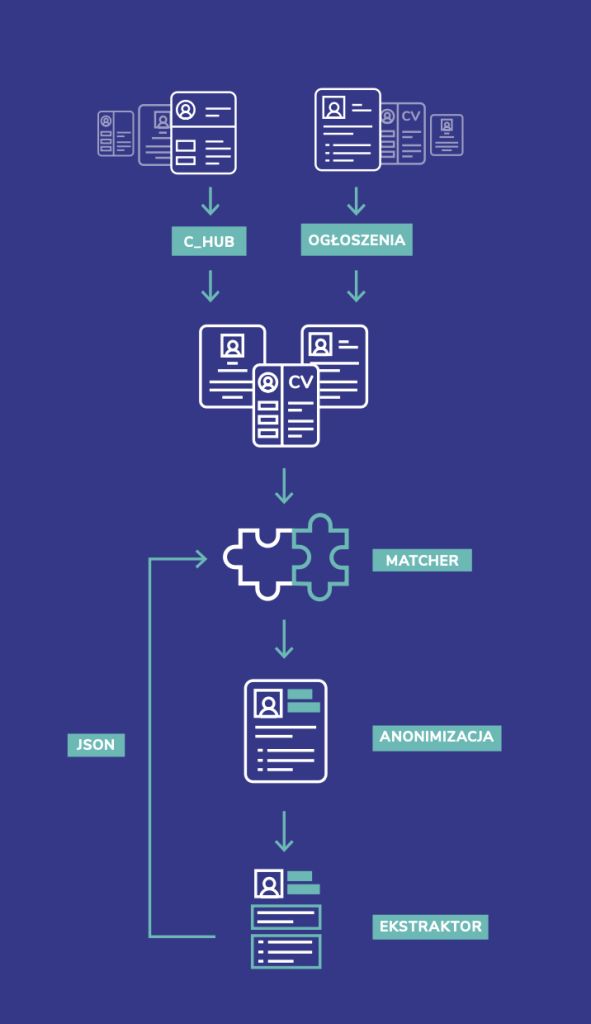

Obecne rozwiązanie składa się z kilku modułów w pełni zintegrowanych z naszymi narzędziami i znajduje się na ścieżce krytycznej procesu. W związku z tym, że działamy na danych osobowych i obowiązuje nas RODO, szczególną wagę przykładamy do tego, by stosowane przez nas rozwiązania zabezpieczały właśnie te dane. Dlatego przesłane do nas CV kierujemy najpierw do modułu anonimizującego (model transformerowy typu BERT, działający lokalnie na naszych wewnętrznych serwerach). Celem działania tego modułu jest usunięcie (zamazanie) z CV wszelkich danych osobowych kandydata. Wynik działania modelu podlega dodatkowo ręcznej weryfikacji przez rekrutera.

Zanonimizowany dokument jest przesyłany do modułu odpowiedzialnego za ekstrakcję, opartego o model GPT-4o. Tam z dokumentu pobierane są i umieszczane w pliku JSON informacje opisujące poszczególne umiejętności i znane technologie, doświadczenie określone latami pracy, ale także poziomem zaawansowania (seniority), znajomość języków, historię zatrudnienia, oczekiwaną stawkę, preferencje dotyczące trybu pracy, lokalizację i wiele innych parametrów.

Mając tak wyekstrahowane dane z życiorysu kandydata oraz w analogicznej formie przygotowany zbiór danych oczekiwanych przez klienta, moduł dokonuje porównania i przedstawia najlepiej dopasowanych kandydatów. A ci, oczywiście po dodatkowej weryfikacji przez rekruterów, są przedstawiani klientom.

I po co nam było to wszystko?

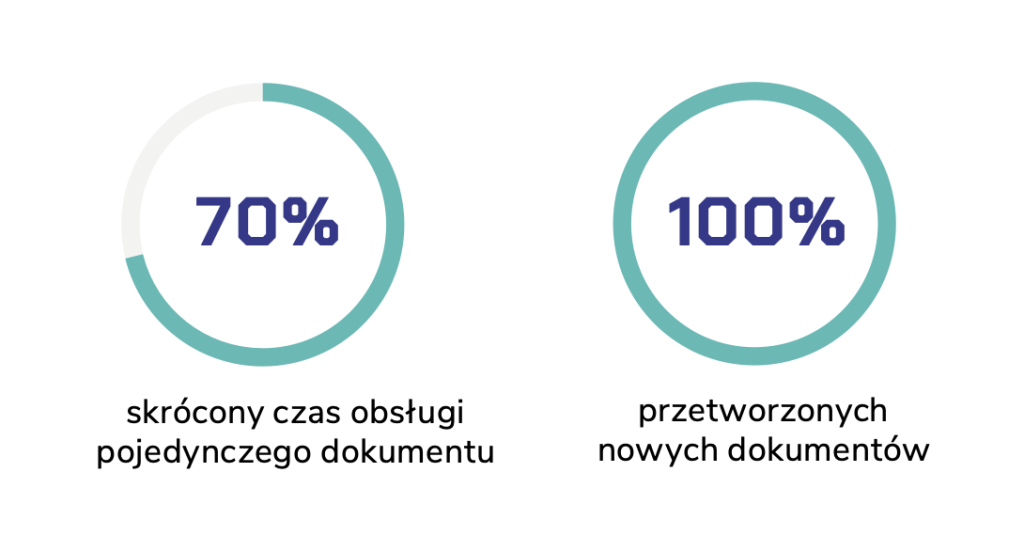

By aż o 70% skrócić czas obsługi pojedynczego dokumentu! Co więcej, dzięki inteligentnej automatyzacji procesu jesteśmy teraz w stanie przetworzyć WSZYSTKIE spływające do nas dokumenty, a nie tylko ich mały fragment, jak dotychczas. To przekłada się na bezpośredni, ogromny wzrost efektywności modułu dopasowującego, bo znaczny przyrost bazy kandydatów oznacza większy wybór i wyższe prawdopodobieństwo znalezienia kandydata idealnego. Jak widać, decyzja o wdrożeniu AI była słuszna, a jej efekty są nie tylko widoczne, ale też dają się zmierzyć.

I to też ważny aspekt wdrażania sztucznej inteligencji – zrealizować cel, to jedno, a powiedzieć „sprawdzam”, to drugie. Jak bowiem pokazuje zeszłoroczne badanie KPMG „Monitor Transformacji Cyfrowej Biznesu”, tylko niecałe 40% firm liczy mierniki efektywności AI.

Warto stawiać na innowację!

W bonusie okazuje się, że zastosowanie tego rozwiązania nie tylko pozwala wybrać właściwych kandydatów, ale też ułatwia ich on-boarding na platformie self-service (hub.connectis.pl). Dzięki modelowi GPT-4o koszty przetworzenia dokumentów rekrutacyjnych spadły aż czterokrotnie w stosunku do początkowych testów opartych o GPT-4! A samo rozwiązanie na tyle przypadło do gustu naszym klientom, że chętnie widzieliby je także u siebie, choćby w modelu SaaS, by na co dzień wspierać wszystkie swoje rekrutacje. Gdzieś zatrzepotały AI-owe skrzydła motyla i kto wie, w stronę jakich innych ciekawych, nowatorskich rozwiązań zaprowadzi nas jeszcze to doświadczenie!

Czego się dodatkowo nauczyliśmy?

Sztuczna inteligencja sprawdza się do optymalizacji wewnętrznych procesów firmy, ale w tym celu musimy najpierw bardzo dobrze je zidentyfikować. Jeżeli liczymy wyłącznie na pomoc zewnętrznych konsultantów, którzy w magiczny sposób domyślą się, czego nam trzeba, to najprawdopodobniej nie uda się wdrożyć sensownego rozwiązania. Na tym etapie kluczowe jest zaangażowanie osób, które wiedzą, jak firma funkcjonuje od środka, gdzie są miejsca potencjalnie wymagające ulepszenia. Trzeba precyzyjnie nazwać potrzebę biznesową i przemyśleć wskaźniki, które pozwolą zmierzyć efekt wdrożenia automatyzacji, tak jak np. czas i liczba przetwarzanych dokumentów w naszym przypadku. Możecie zauważyć, że te zasady dotyczą wprowadzania każdej transformacji narzędziowej i owszem, bo jak już podkreślaliśmy – sztuczna inteligencja to potężne narzędzie, ale ostatecznie będące jedynie środkiem do osiągnięcia celu, a nie celem samym w sobie.