Twój koszyk jest obecnie pusty!

Celem takich regulacji jest zapewnienie, że decyzje podejmowane przez algorytmy są zgodne z zasadami etyki, prawa oraz zawsze stawiają w centrum człowieka.

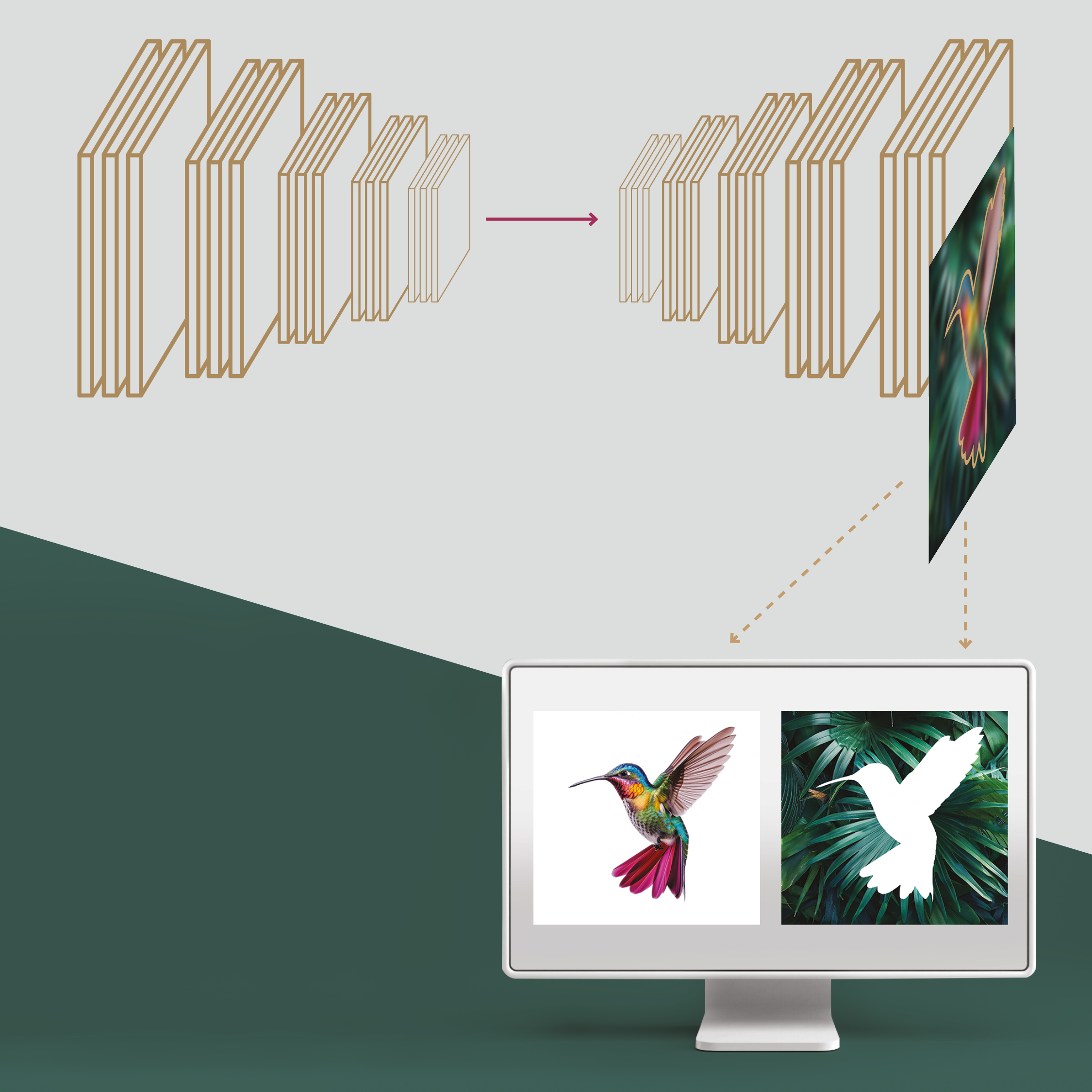

Na poziomie inżynierskim XAI jest niezbędna do zrozumienia, ulepszania i kontrolowania modeli AI, co pozwala na bardziej precyzyjną optymalizację algorytmów oraz zapewnienie ich bezpieczeństwa. Z drugiej strony dla użytkowników końcowych wyjaśnialność modeli AI buduje zaufanie i poprawia ich doświadczenie. Szczególnie istotne jest to w sytuacjach, gdy AI wspiera jedynie proces decyzyjny, ale ostateczna decyzja należy do człowieka. W takich przypadkach, aby człowiek mógł zdecydować świadomie, musi rozumieć, jakie wyniki dostarczył model i na jakiej podstawie. Przykładem takiego systemu są narzędzia do moderacji treści, które pomagają w identyfikacji i zarządzaniu potencjalnie szkodliwymi materiałami, takimi jak rasistowskie komentarze, mowa nienawiści czy treści związane z wykorzystywaniem seksualnym dzieci (CSAM). Wówczas, choć AI może zidentyfikować podejrzane treści, ostateczna decyzja o ich usunięciu lub dalszym działaniu należy do moderatora, który ocenia kontekst i bierze na siebie konsekwencje wybranej akcji.