Twój koszyk jest obecnie pusty!

Zaledwie kilka miesięcy po premierze modelu Nano Banana, Google zaprezentowało jego następcę – Nano Banana Pro (Gemini 3 Pro Image). O ile poprzednia wersja skupiała się na prostych edycjach i zabawie formą, wariant Pro stawia na precyzję niezbędną w pracy kreatywnej i studyjnej. Nowy model wykorzystuje zdolności wnioskowania Gemini 3 oraz dostęp do wiedzy o świecie w czasie rzeczywistym.

Wizualizacja danych i czytelny tekst

Jednym z największych wyzwań dla generatorów obrazu była dotychczas typografia. Nano Banana Pro radzi sobie z renderowaniem tekstu znacznie lepiej od poprzedników. Użytkownicy mogą generować grafiki z czytelnymi napisami – od krótkich haseł reklamowych po dłuższe akapity. Model obsługuje wiele języków, co pozwala na przykład na przetłumaczenie etykiet na produktach z zachowaniem oryginalnego stylu graficznego (np. z angielskiego na koreański).

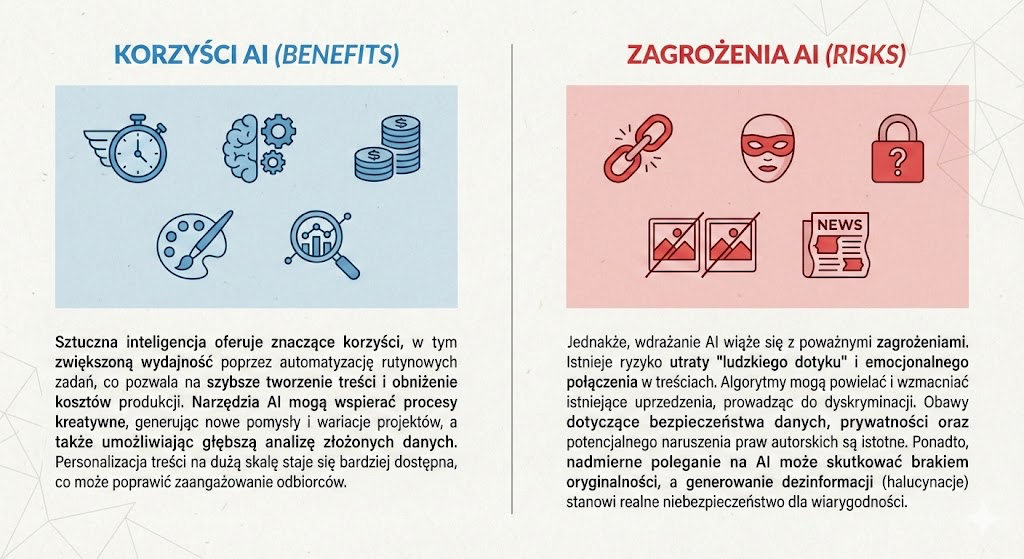

Istotną nowością jest integracja z wyszukiwarką Google. Model potrafi wizualizować informacje pobierane na żywo. Pozwala to na tworzenie aktualnych infografik pogodowych, wykresów sportowych czy instrukcji krok po kroku (np. przepisu na herbatę z kardamonem) na podstawie rzeczywistych danych, a nie tylko halucynacji modelu.

Kontrola nad stylem i spójnością

Dla osób zajmujących się projektowaniem kluczowa jest powtarzalność. Nano Banana Pro umożliwia łączenie do 14 obrazów wejściowych przy zachowaniu spójności postaci i stylu. Oznacza to, że można wygenerować serię ujęć do storyboardu lub sesji modowej, w której bohaterowie i ich ubiór wyglądają tak samo na każdym kadrze, zmieniają się jedynie pozy i perspektywa.

Google oddaje w ręce twórców także bardziej zaawansowane narzędzia kontroli „studyjnej”. Możliwa jest edycja konkretnych fragmentów obrazu, zmiana kąta kamery, głębi ostrości (np. wyostrzenie kwiatów na pierwszym planie) oraz modyfikacja oświetlenia. Użytkownicy mogą zmienić porę dnia na zdjęciu z dziennej na nocną lub wprowadzić efekt chiaroscuro (mocny światłocień), zachowując przy tym oryginalne rysy twarzy postaci.

Dostępność i wdrożenia

Model jest wdrażany w różnych usługach Google, w zależności od grupy docelowej:

- Użytkownicy indywidualni: Mogą korzystać z modelu w aplikacji Gemini (opcja „Thinking”). Wersja darmowa posiada limity, po których wyczerpaniu system przełącza się na podstawowy model Nano Banana. Subskrybenci pakietów Google AI Plus, Pro i Ultra otrzymują wyższe limity.

- Firmy i profesjonaliści: Model trafia do Google Ads, Workspace (Slajdy, Vids) oraz dla programistów poprzez Gemini API i Google AI Studio.

- Kreatywni: Subskrybenci Ultra otrzymają dostęp do narzędzi wideo (Flow) z większą precyzją kontroli scen.

Weryfikacja treści i SynthID

Wraz z nowym modelem Google kładzie duży nacisk na transparentność. Wszystkie grafiki generowane przez narzędzia firmy mają zawierać niewidoczny znak wodny SynthID. Od teraz w aplikacji Gemini dostępna ma być również funkcja weryfikacji – po przesłaniu pliku można zapytać bota: „Czy ten obraz został wygenerowany przez Google AI?”, aby otrzymać stosowną informację.

Dodatkowo wprowadzono rozróżnienie wizualne:

- Obrazy generowane przez użytkowników darmowych i subskrybentów Pro będą oznaczone widocznym znakiem wodnym (iskierką).

- Materiały tworzone przez subskrybentów Ultra oraz programistów w AI Studio będą pozbawione widocznego oznaczenia, aby zapewnić czysty obraz do użytku profesjonalnego.

Google wdraża również metadane zgodne ze standardem C2PA, co pozwoli na sprawdzanie pochodzenia obrazu również poza ekosystemem Google. Firma zapowiada, że wkrótce weryfikacja SynthID obejmie także materiały audio i wideo.

Jak to wygląda w praktyce? Sprawdźmy to

Obietnice producenta to jedno, ale w praktyce…cóż, bywa różnie. Postanowiłam to sprawdzić.

W przypadku generowania tekstów Gemini radzi sobie bardzo dobrze. Napisy na grafikach są czytelne, a model poprawnie interpretuje polecenia dotyczące typografii.

Równie dobrze wypadł test integracji z danymi w czasie rzeczywistym. Poprosiłam model o wykonanie konkretnego zadania: „Stwórz aktualną infografikę pogodową dla Warszawy: temperatura, wilgotność, zachmurzenie oraz ikony pogody o wysokiej czytelności. Wykorzystaj dane w czasie rzeczywistym”. Rezultat był satysfakcjonujący – otrzymałam dość estetyczną grafikę z poprawnymi danymi meteo. (Chociaż wybiegł trochę w przyszłość – test robiłam o 18:14, a na infografice widzimy 18:30)

Mieszane uczucia budzi natomiast funkcja rozpoznawania obrazów AI. Mimo zapowiedzi o łatwej weryfikacji, gdy chciałam to sprawdzić, system nie rozpoznał dwóch grafik wygenerowanych chwilę wcześniej przez ten sam model. Wygląda na to, że na w pełni działający mechanizm SynthID w aplikacji będziemy musieli jeszcze chwilę poczekać.