Twój koszyk jest obecnie pusty!

Zamiast tego może porównać ją do rozciągniętej w przestrzeni niewidzialnej siatki, która ugina się pod wpływem masywnych obiektów – jak piłka leżąca na napiętej tkaninie – tak też tłumaczy się grawitację dwulatkom (to nie żart, zrobiono to w świetnej serii książek Chrisa Ferrie). Przekładanie skomplikowanych koncepcji na obrazowe analogie, odwoływanie się do naszego wspólnego doświadczenia to bardzo ludzka i bardzo pomocna skłonność naszych umysłów, która pomaga nam odnaleźć się w świecie lub przybliżyć ten świat innym. Nasze wyjaśnienia mają określoną strukturę: wybieramy kluczowe informacje, uwzględniamy kontekst i dostosowujemy przekaz do odbiorcy. Czasem odwołujemy się przy tym do naszego wspólnego doświadczenia.

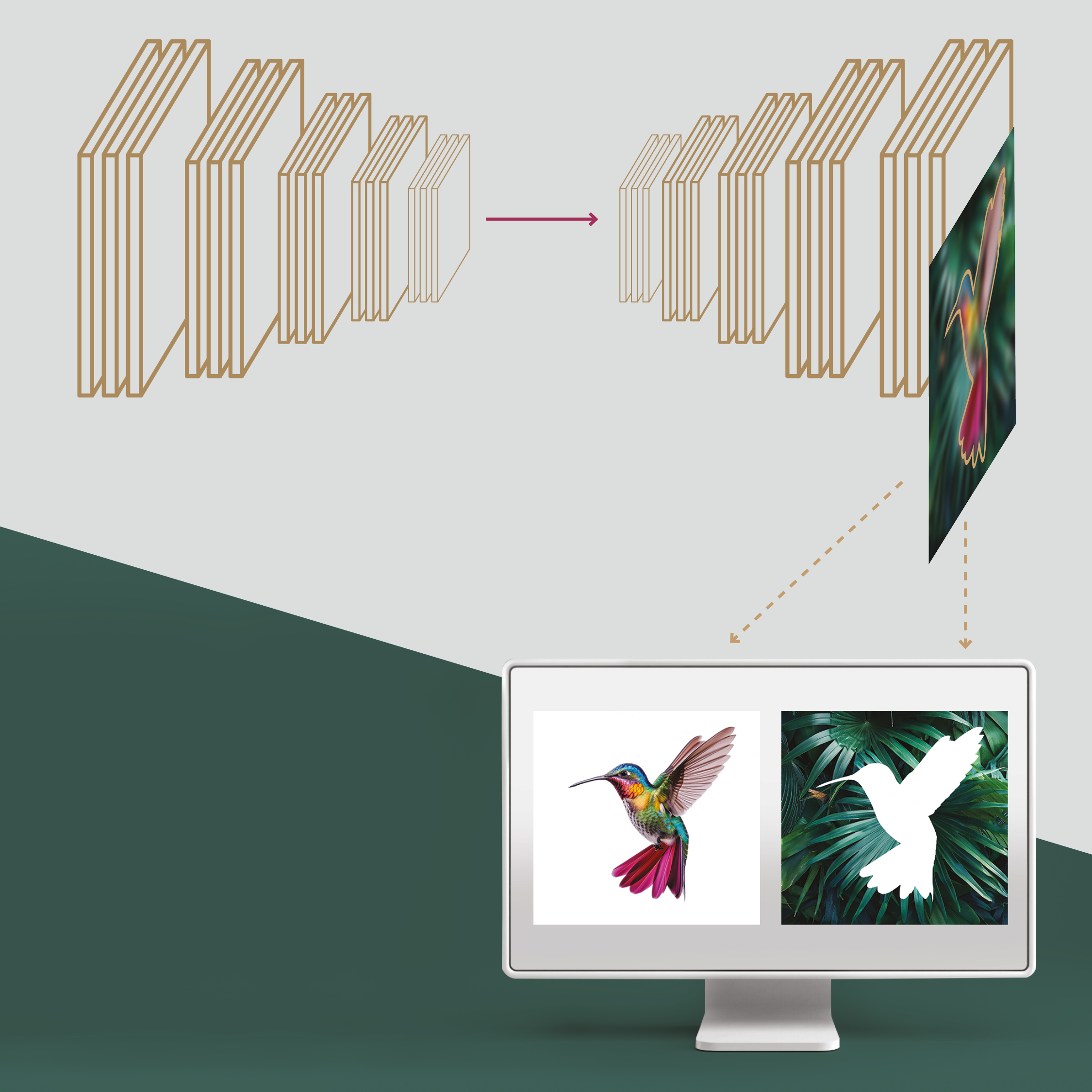

Tak samo jest z wyjaśnianiem sztucznej inteligencji – w teorii, explainable AI (XAI), czyli właśnie „wyjaśnialna sztuczna inteligencja”, powinna być zrozumiała dla każdego. Praktyka pokazuje jednak, że nie do końca tak jest. To, co dla jednego specjalisty jest przejrzystym wyjaśnieniem, dla innego może stanowić niezrozumiały labirynt technicznych szczegółów. Sytuacja ta generuje wiele nowych wątpliwości. Jakie formy wyjaśnień sprawdzają się najlepiej w poszczególnych dziedzinach? Czy lepiej pokazać konkretny wpływ czynników, czy może bardziej pomocne jest porównanie z podobnymi przypadkami? A może kluczem są symulacje typu „co by było, gdyby”? Czy są jeszcze inne sposoby zobrazowania decyzji systemu?