Twój koszyk jest obecnie pusty!

Na co dzień mówimy o AI jak o narzędziu do pracy. Według obiegowej opinii pomaga programistom, przyspiesza pisanie, porządkuje dokumenty. Ale czy tak faktycznie wygląda sposób, w jaki ludzie korzystają z modeli na co dzień? Najnowszy raport OpenRouter pokazuje, że… niekoniecznie.

OpenRouter to platforma obsługująca ponad 300 modeli od 60 dostawców. Ponad połowa ruchu pochodzi spoza Stanów Zjednoczonych, co daje globalny przekrój zachowań. Raport nie obejmuje treści rozmów, lecz metadane. Twórcy raportu przeanalizowali ponad 100 bilionów tokenów wygenerowanych przez setki modeli i miliardy interakcji. To dzięki nim można zobaczyć wzorce, długość interakcji czy rodzaj zadań, które powtarzają się miliony razy.

Co te dane mówią o AI?

Fikcja i kodowanie

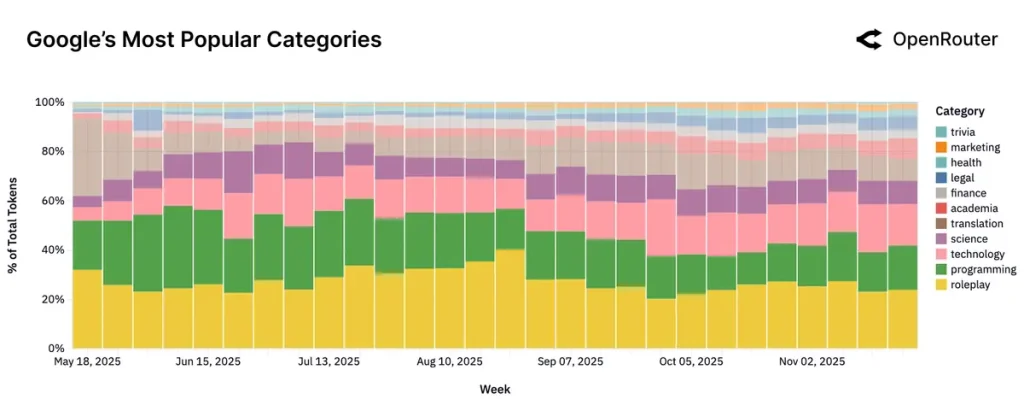

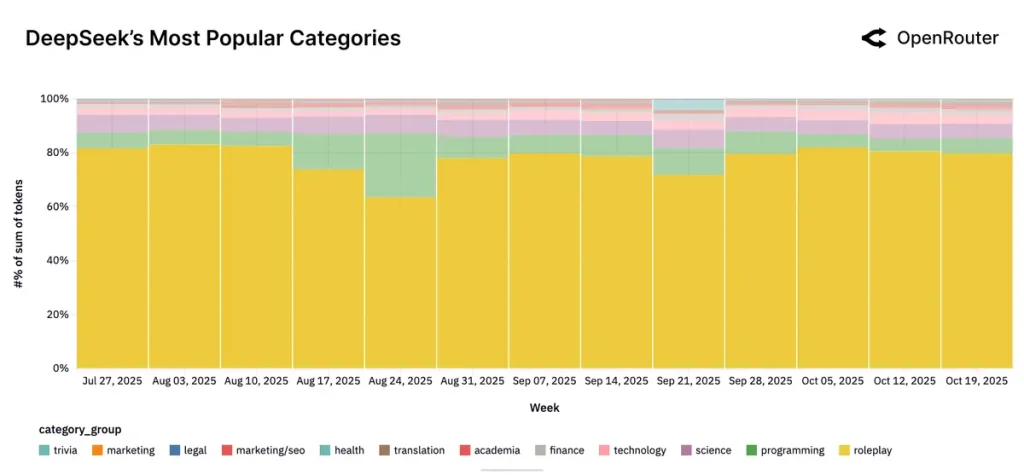

Największa niespodzianka to fakt, że połowa zapytań dotyczy tworzenia fikcji, narracji lub symulacji. Od dialogów z postaciami, przez budowanie światów, po gry tekstowe i eksperymenty literackie.

Co istotne – to nie jest nisza. To główny nurt.

W praktyce oznacza to coś więcej niż tylko zabawę. AI zaczyna funkcjonować jako przestrzeń, w której użytkownicy projektują doświadczenia, testują relacje i eksplorują pomysły. Ten wymiar rzadko pojawia się w dyskusjach o produktywności, choć to on rośnie szybciej niż większość innych form interakcji.

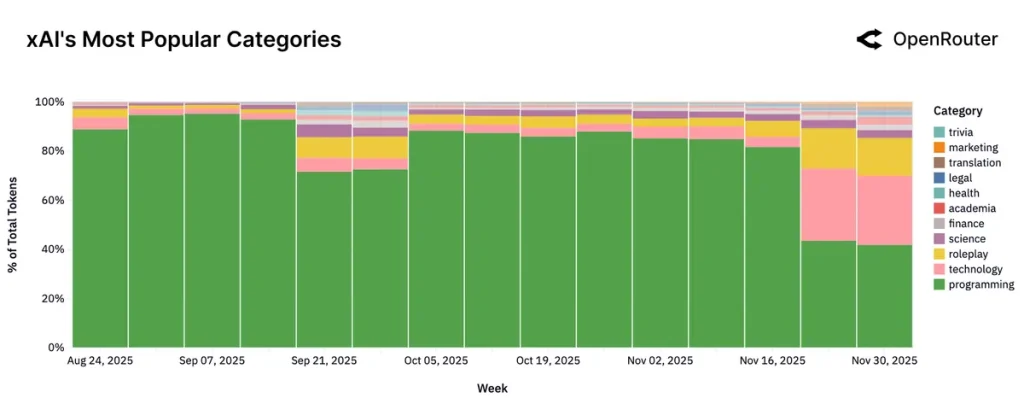

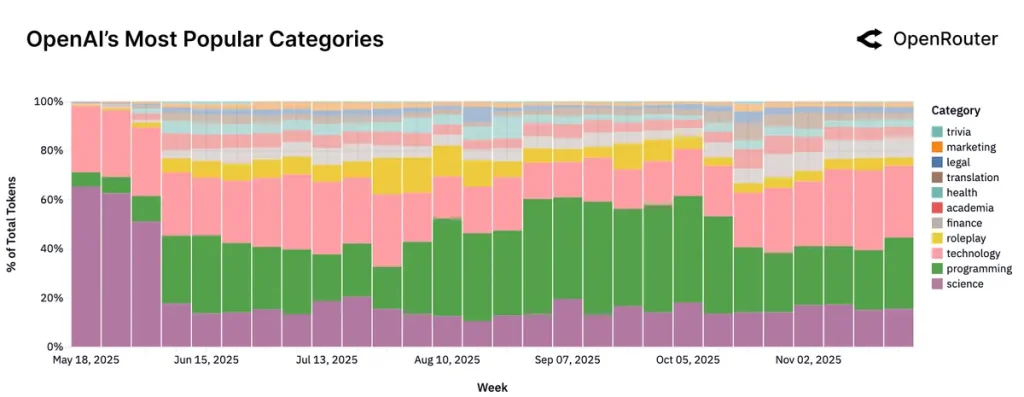

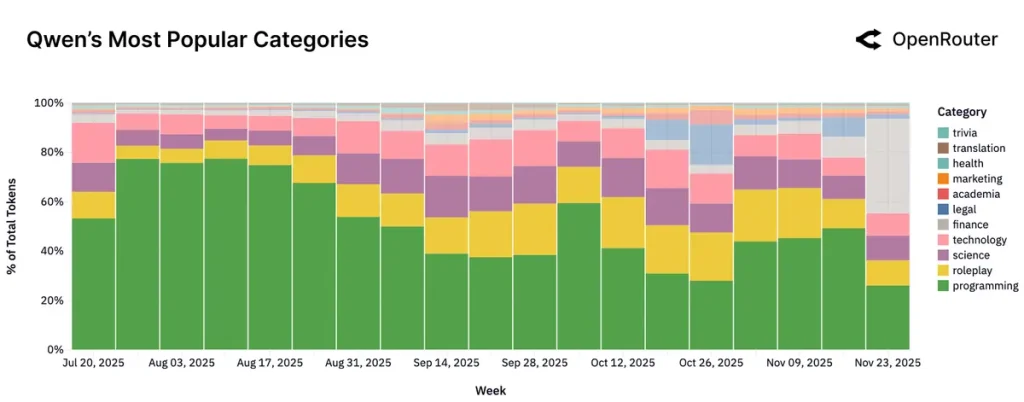

Warto też zauważyć, że sposób użycia AI różni się w zależności od rodzaju modelu. W open source dominują interakcje odgrywania ról (roleplay), ale w modelach zamkniętych widać silną koncentrację na zadaniach technicznych i profesjonalnych. To sugeruje, że rynek zaczyna się wyraźnie różnicować. Modele otwarte służą eksperymentom i interakcji (bo nie są tak ściśle moderowane), a modele premium są wybierane tam, gdzie liczy się stabilność i jakość.

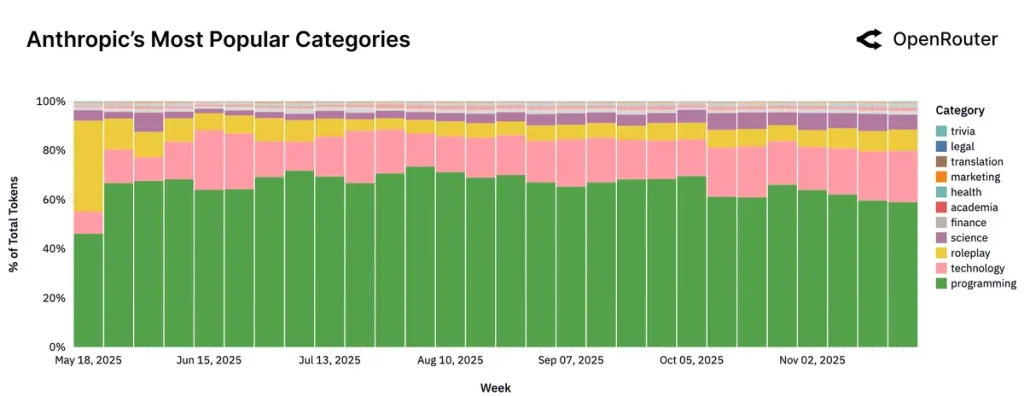

Po drugiej stronie znajduje się programowanie, które w 2025 roku stało się najszybciej rosnącą kategorią. Na początku roku odpowiadało za około jedenaście procent użycia modeli. Pod koniec przekroczyło pięćdziesiąt. I nie chodzi tu o pisanie krótkich fragmentów kodu. Prompt w stylu „napraw mi błąd” to margines. Dominują długie sekwencje, często przekraczające dwadzieścia tysięcy tokenów, co odpowiada całym repozytoriom. Modele analizują architekturę, identyfikują problemy, proponują refaktoryzacje. Stają się realnym uczestnikiem procesu tworzenia oprogramowania.

Na czele tej kategorii utrzymuje się Claude, który przez większość roku obsługiwał ponad sześćdziesiąt procent zapytań związanych z programowaniem.

Agenty coraz powszechniejsze

Wraz ze wzrostem złożoności zadań zmienia się też sposób działania modeli. Coraz więcej interakcji trafia do modeli nastawionych na rozumowanie, czyli takich, które potrafią analizować problem krok po kroku. W praktyce oznacza to częstsze korzystanie z dodatkowych narzędzi, pracę na bardzo długich fragmentach tekstu i wykonywanie instrukcji podzielonych na wiele etapów. AI zaczyna więc realnie planować i realizować zadania, a nie tylko generować pojedyncze odpowiedzi.

To przesunięcie w stronę agentowości sprawia, że interakcja z AI wygląda bardziej jak współpraca niż rozmowa. Większość modeli przestaje być narzędziami reagującymi na proste komendy. Zamiast tego funkcjonują jak moduły wykonawcze, które potrafią analizować stan, podejmować decyzje i wracać do użytkownika z kolejnymi krokami.

Chiny rosną w siłę

Raport pokazuje też zmianę geopolityczną. Modele z Chin zanotowały największy wzrost udziału w rynku. W ciągu roku przeszły z poziomu około jednego procenta do niemal trzydziestu w szczytowych tygodniach. Najszybciej rosną DeepSeek, Qwen i Moonshot AI. Co więcej, drugi najczęściej używany język to chiński uproszczony. To pokazuje, że na naszych oczach powstaje nowy biegun rozwoju modeli, który będzie wpływał zarówno na konkurencję, jak i na regionalne oczekiwania wobec AI.

Zmienia się też globalna mapa wykorzystania AI. Udział Azji w całkowitym użyciu wzrósł z trzynastu do trzydziestu jeden procent. To kolejny dowód na to, że rynek nie jest napędzany wyłącznie przez Amerykę Północną. Rośnie liczba lokalnych zastosowań, lokalnych produktów i lokalnych preferencji.

Lojalność ze skuteczności

Inne ciekawe zjawisko opisane w raporcie dotyczy retencji. Jak się okazuje, modele budują lojalność nie wtedy, kiedy są najgłośniej promowane, ale wtedy, gdy jako pierwsze rozwiązują realny, wcześniej nierozwiązany problem użytkownika. Kiedy to się wydarzy, powstaje grupa, która zostaje z modelem przez wiele miesięcy. Ten efekt pojawił się między innymi przy Claude 4 Sonnet i Gemini 2.5 Pro. W niektórych grupach użytkowników oba modele potrafiły zatrzymać około czterdziestu procent osób nawet po pięciu miesiącach korzystania.. To znacznie wyżej niż w przypadku późniejszych odsłon. A więc przywiązanie do sprawdzonego modelu może być więc ważniejsza niż numer wersji.

Raport dodaje też, że retencja nie wynika z przywiązania do marki, ale z tego, że model został wbudowany w proces pracy. Użytkownicy nie chcą przełączać się na inne modele, bo musieliby zmienić sposób działania, przebudować workflow lub zmieniać prompty. To tłumaczy, dlaczego modele, które jako pierwsze trafiły w realną potrzebę danej grupy, zyskują przewagę, którą trudno jest im później odebrać.

Cena nie gra (wielkiej) roli

Dane OpenRouter pokazują także, że w praktyce popyt jest mało wrażliwy na zmiany kosztów. Obniżenie ceny o dziesięć procent podnosi użycie tylko o około pół procent. Droższe modele utrzymują wysokie wykorzystanie, jeśli oferują przewagę jakościową. Tańsze modele rosną równolegle, zwłaszcza w zadaniach, które wymagają dużego zużycia tokenów. W efekcie powstaje pluralistyczny rynek, w którym różne modele pełnią różne funkcje, a nie zastępują się nawzajem.

Rynek zaczyna też dzielić się na cztery segmenty: liderów premium, wydajne modele tanie, modele niszowe i długi ogon. Ten ostatni obejmuje setki mniej popularnych modeli, które nie zdobywają dużej skali, ale utrzymują się dzięki wąskim, specjalistycznym zastosowaniom. To modele, które nie rywalizują o masowego użytkownika, lecz o konkretne potrzeby małych grup, często w bardzo specyficznych zadaniach. Razem tworzą szeroką, choć rozproszoną część rynku, która pokazuje, jak różnorodne potrafią być oczekiwania użytkowników.

Jak AI zmienia świat?

Raport OpenRouter pokazuje, że AI nie rozwija się według prostych założeń. Nie jest tylko narzędziem produktywnościowym ani prostym systemem „pytanie-odpowiedź”. Staje się interaktywnym medium, partnerem w procesach technicznych i fundamentem nowych typów aplikacji agentowych.

Jednocześnie rynek jest bardziej zróżnicowany niż sugerują to dyskusje o pojedynczych modelach czy analizy wydajności i przewag jakościowych nowych wydań. Widać wyraźnie, że przewagę buduje się nie przez rozgłos, ale przez rozwiązanie konkretnego problemu. AI nie zmienia świata według swojego planu (bo go – póki co – mieć nie może) nie planu twórców modeli. Zmienia go poprzez to, jak ludzie z niej korzystają. A ludzie potrzebują dwóch rzeczy – pomocy i kontaktu. Zatem wymiar wydajnościowy jest istotny, ale to ta „ludzka” strona AI w dużej mierze decyduje o jej popularności.