Twój koszyk jest obecnie pusty!

Letnia ofensywa OpenAI przypominała precyzyjnie zaplanowaną operację wojskową. Najpierw, w połowie lipca, na scenę wkroczył ChatGPT Agent – narzędzie zdolne samodzielnie buszować w sieci, wypełniać formularze i pracować na danych z wielu źródeł. Chwilę później pojawił się Study Mode, czyli tryb, w którym ChatGPT prowadzi użytkownika za rękę przez zawiłości logicznego rozumowania. Na początku sierpnia firma odsłoniła kolejne karty: dwa duże modele językowe w otwartym kodzie, oddając potężne narzędzia w ręce społeczności.

Wszystko to było jednak tylko preludium. Starannie budowane napięcie znalazło swój finał 7 sierpnia, gdy światło dzienne ujrzał GPT-5. Dostępny od razu dla wszystkich w wersji webowej i przez API, w trzech wariantach mocy (GPT-5, GPT-5 mini i GPT-5 nano), nowy model jest czymś więcej niż tylko szybszym i celniejszym generatorem tekstu. Choć oficjalna narracja skupia się wokół hasła „useful, smart, fast”, warto przyjrzeć się, na ile obietnice pokrywają się z rzeczywistymi możliwościami modelu – i jakie przesunięcia standardów użytkowania sztucznej inteligencji przynosi GPT-5.

Dlaczego GPT-5 ma znaczenie?

Gdzie leży największa zmiana? W mechanizmie, który OpenAI nazywa „routerem”. To wewnętrzny dyspozytor, który analizuje złożoność zadania i decyduje, czy wystarczy rutynowa odpowiedź, czy też trzeba uruchomić tryb głębokiego przetwarzania – „think hard”. Użytkownik nie musi już o nic prosić. Model sam wie, kiedy należy przestać improwizować, a zacząć „rozumować”. W praktyce oznacza to skok jakościowy w zadaniach wymagających wieloetapowej analizy, pisania złożonego kodu czy tworzenia spójnej argumentacji. Jednocześnie model zyskał nową, cenną umiejętność: potrafi przyznać się do niewiedzy, gdy dane wejściowe nie pozwalają na sformułowanie wiarygodnej odpowiedzi.

OpenAI, w swoim stylu, ubrało tę zmianę w chwytliwe hasło: „rozumowanie na poziomie osoby z doktoratem”. To marketingowa obietnica, którą warto jednak włożyć między bajki. Prawdziwy doktorat to nie tylko biegłość w przetwarzaniu informacji, ale też świadomość kontekstu społecznego, intencji, własnych ograniczeń i zdolność do krytycznej refleksji. GPT-5 bez wątpienia robi krok w stronę głębszego przetwarzania, ale przypisywanie mu stopnia naukowego to zręczna metafora, a nie mierzalny fakt.

Prawdziwe znaczenie GPT-5 nie leży więc w benchmarkach czy marketingowych hasłach. Leży w redefinicji relacji między człowiekiem a maszyną. Dostaliśmy partnera, który nie tylko potrafi myśleć dłużej, ale przede wszystkim wie, kiedy jest to konieczne. I nie boi się powiedzieć: „nie wiem”.

Co potrafi nowy model?

Najważniejsza zmiana w GPT-5, czyli wspomniany już mechanizm „routera”, to silnik napędzający wszystkie inne nowości. To dzięki niemu model nie traktuje już każdego zadania jednakowo, ale inteligentnie zarządza swoją mocą obliczeniową. Co to oznacza w praktyce?

Po pierwsze, pisanie i programowanie wchodzą na wyższy poziom współpracy. GPT-5 znacznie lepiej rozumie strukturę tekstu i intencję autora. Niezależnie, czy chodzi o analizę danych, edycję oficjalnego komunikatu, czy kreatywną burzę mózgów nad esejem – model nie tylko generuje tekst, ale też sugeruje zmiany, dopytuje o cel i kontekst. Podobnie jest z kodem. GPT-5 sprawniej utrzymuje kontekst w złożonych projektach, naprawia błędy i podpowiada optymalizacje. W połączeniu z Agentem, który potrafi samodzielnie uruchomić środowisko testowe, może stać się cyfrowym partnerem w kodowaniu.

Po drugie, zyskujemy większą kontrolę nad stylem i formą interakcji. Użytkownik może teraz wybrać jeden z czterech trybów rozmowy: precyzyjny, zwięzły, kreatywny lub rozbudowany. To proste narzędzie pozwala dopasować charakter odpowiedzi do aktualnej potrzeby. Dodano też detal kosmetyczny – możliwość zmiany kolorów interfejsu, co sygnalizuje kierunek ku większej personalizacji.

Po trzecie, głos staje się narzędziem do nauki. Udoskonalony Voice Mode zyskał funkcję „Ucz się i przyswajaj wiedzę”. Rozmowa z AI przestaje być serią jednorazowych pytań. Zamiast tego przypomina sesję z interaktywnym tutorem, który prowadzi nas przez zagadnienie krok po kroku, cierpliwie tłumaczy i odpowiada na dodatkowe pytania. To funkcja (od niedawna dostępna tylko w trybie konwersacji pisanej) stworzona dla tych, którzy chcą używać AI do realnego poszerzania kompetencji, a także potężne narzędzie do nauki, na przykład języków obcych.

Wszystkie te zmiany – głębsze rozumowanie, lepsze pisanie, bardziej zaawansowane kodowanie i adaptacyjne wsparcie głosowe – sprawiają, że punkt ciężkości przesuwa się z „generowania odpowiedzi” na współpracę opartą na rozumieniu celu użytkownika.

Mierzenie inteligencji: co mówią liczby?

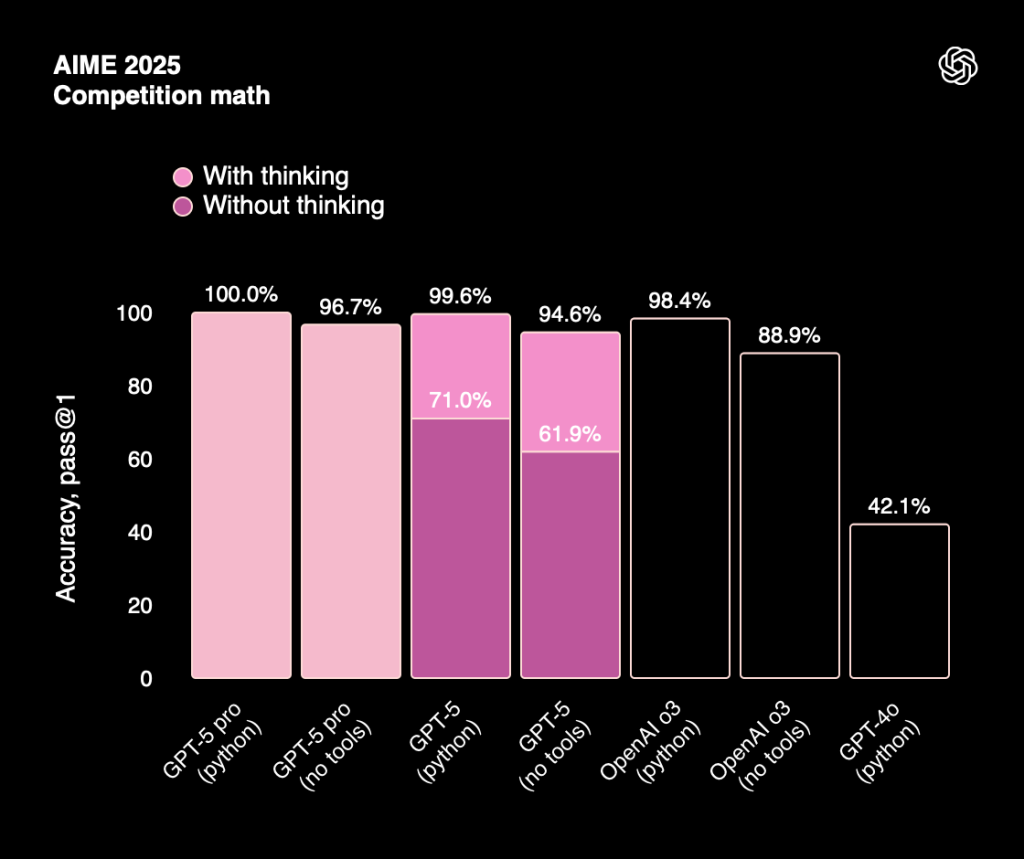

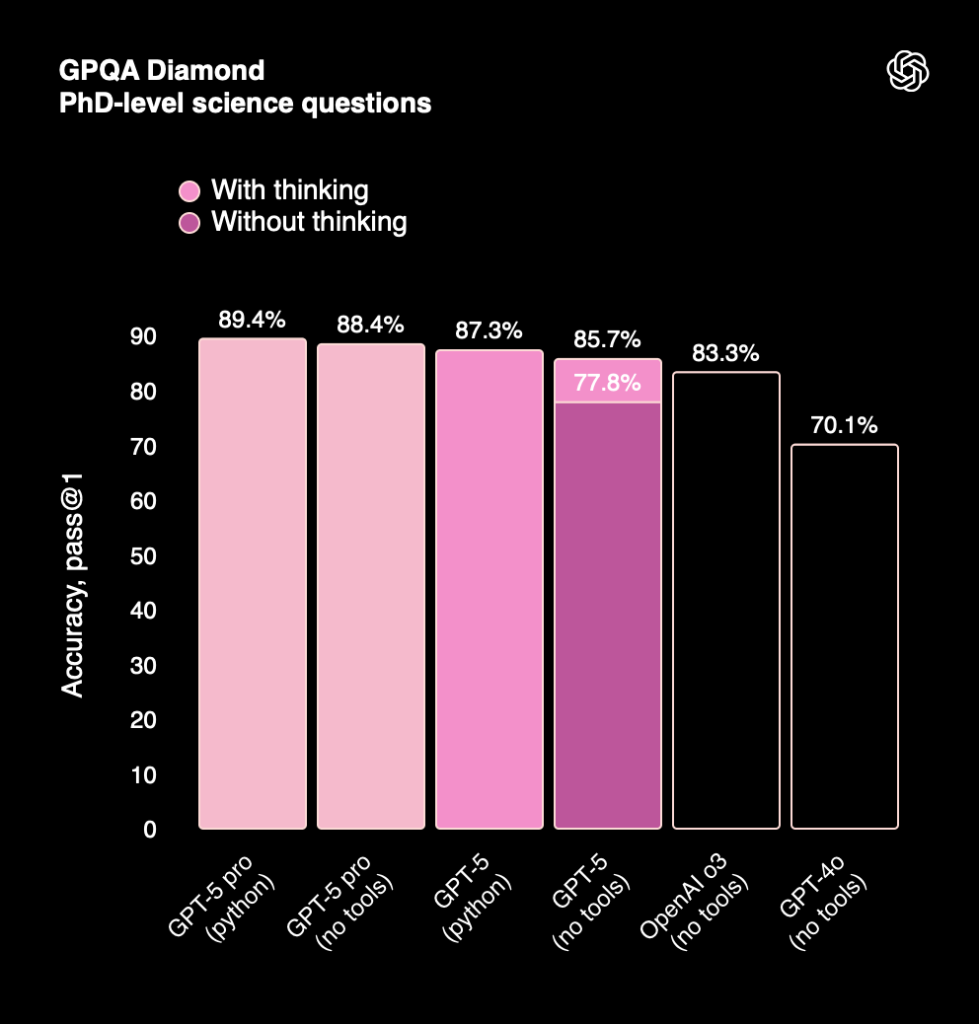

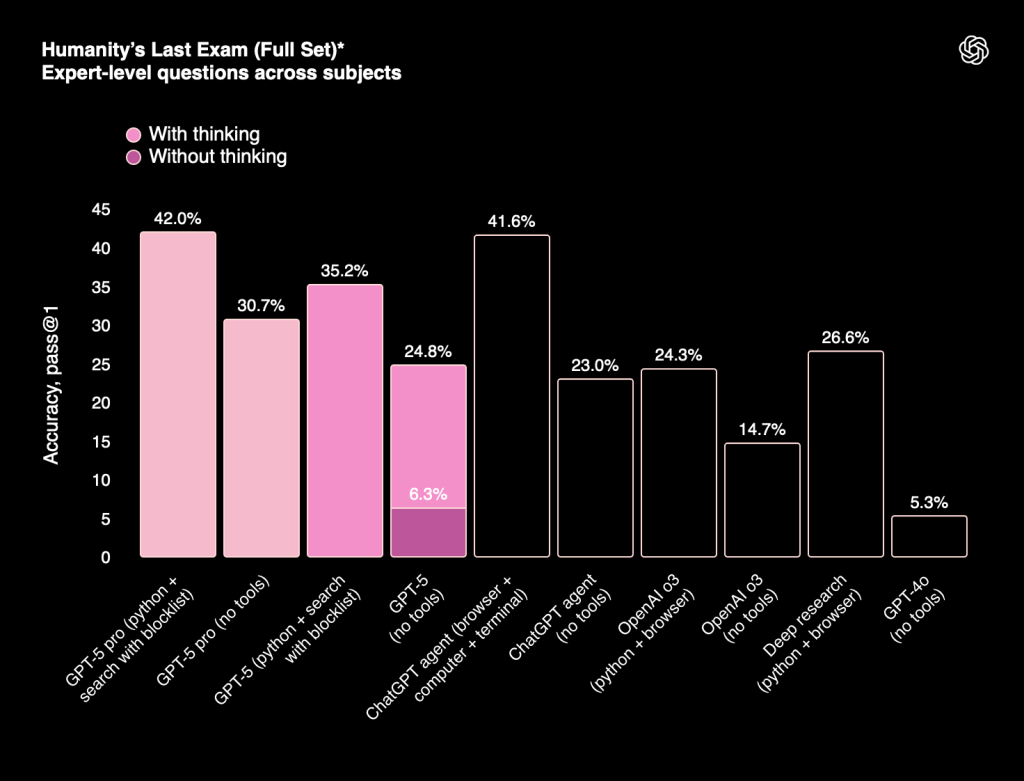

Marketingowe deklaracje to jedno, ale prawdziwą miarą jakości dużych modeli językowych stają się niezależne benchmarki. Testują one AI w realistycznych, złożonych zadaniach, gdzie liczy się nie tylko poprawna odpowiedź, ale też odporność na błędy i zdolność do prowadzenia logicznego rozumowania. Wyniki GPT-5 w tych testach pokazują wyraźny wzór.

Szczególnie imponująco wyglądają postępy w zadaniach programistycznych. W teście SWE-Bench Verified, polegającym na rozwiązywaniu realnych problemów z repozytoriów open-source, osiąga aż 74,9% skuteczności. W Aider Polyglot poprawnie edytuje kod w wielu językach programowania w 88% przypadków. Z kolei w SWE-Lancer, symulującym pracę freelancera, dominuje nad konkurencją, sprawnie przechodząc od briefu aż po wdrożenie.

GPT-5 notuje również najwyższe wyniki w zadaniach konkursowych. W teście AIME 2025 osiąga 94,6% bez dodatkowych narzędzi i aż 99,6% z włączonym trybem „thinking”. W prestiżowym turnieju HMMT (Harvard–MIT) jego skuteczność sięga niemal 100%, a w przekrojowym teście Humanity’s Last Exam obejmującym eksperckie pytania z wielu dziedzin, przewaga GPT-5 jest miażdżąca. Z włączonym trybem głębokiego myślenia osiąga 42%, podczas gdy GPT-4o zatrzymał się na poziomie zaledwie 5,3%.

Równie wysokie kompetencje model prezentuje w dziedzinach wysokiego ryzyka. W teście HealthBench Hard, który sprawdza wiedzę medyczną w skomplikowanych scenariuszach diagnostycznych, GPT-5 osiąga wyniki zbliżone do ludzkiego specjalisty, wykazując przy tym niską tendencję do generowania nieprawdziwych informacji.

GPT-5 w benchmarkach nie tyle deklasuje poprzedników w prostych zadaniach, co zyskuje ogromną przewagę tam, gdzie rośnie złożoność. W testach wymagających głębokiego zrozumienia kontekstu i wieloetapowego wnioskowania wyraźnie wyprzedza zarówno GPT-4, jak i inne konkurencyjne modele. Choć żaden test nie oddaje w pełni realiów użytkowania, liczby nie kłamią: GPT-5 to konstrukcja lepiej dostrojona do zadań, w których nie ma miejsca na błąd.

Architektura zaufania: jak bezpieczny jest GPT-5?

Przy tak ogromnej mocy, bezpieczeństwo przestaje być dodatkiem, a staje się fundamentem. OpenAI deklaruje, że GPT-5 przeszedł ponad 5000 godzin rygorystycznych testów, w których wewnętrzne i zewnętrzne zespoły wcielały się w rolę „adwersarzy”, próbując złamać zabezpieczenia modelu.

Kluczowym elementem jest mechanizm safe completions – wbudowany hamulec bezpieczeństwa, który ogranicza generowanie ryzykownych treści w dziedzinach takich jak zdrowie, finanse czy prawo. GPT-5 znacznie częściej niż jego poprzednicy woli zamilknąć lub zasygnalizować niepewność, niż udzielić odpowiedzi, która mogłaby wprowadzić w błąd. Wprowadzono też twardsze reguły dla scenariuszy medycznych, gdzie model, zamiast stawiać diagnozy, odsyła do wiarygodnych źródeł wiedzy.

Co niezwykle istotne z perspektywy użytkownika i bezpieczeństwa danych: GPT-5 nie uczy się na podstawie naszych rozmów w czasie rzeczywistym. Jak czytamy w dokumentacji, indywidualne interakcje nie aktualizują wag ani wewnętrznej wiedzy modelu. To wciąż model statyczny, którego baza wiedzy jest zamrożona w czasie. Opcjonalna funkcja „pamięci” (memory) pozwala na przechowywanie kontekstu z poprzednich rozmów, ale nie jest to forma ciągłego uczenia się – model nie zmienia swojego „rozumienia” świata. OpenAI zastrzega, że może wykorzystywać zagregowane, anonimowe dane do ulepszania przyszłych wersji, ale nigdy na podstawie pojedynczej sesji. Taka architektura, standardowa w komercyjnych wdrożeniach, celowo ogranicza ryzyko przypadkowego wycieku poufnych informacji i gwarantuje, że model zachowuje się w przewidywalny sposób.

Mimo tych zabezpieczeń, warto zachować zdrowy dystans. Żaden model nie jest w 100% bezpieczny, a zdolność do generowania nieprzewidywalnych odpowiedzi pozostaje realnym wyzwaniem. GPT-5 zbliża się do momentu, w którym sam wie, kiedy powinien milczeć, ale ostateczna odpowiedzialność za krytyczne decyzje wciąż spoczywa na człowieku.

Dostępność

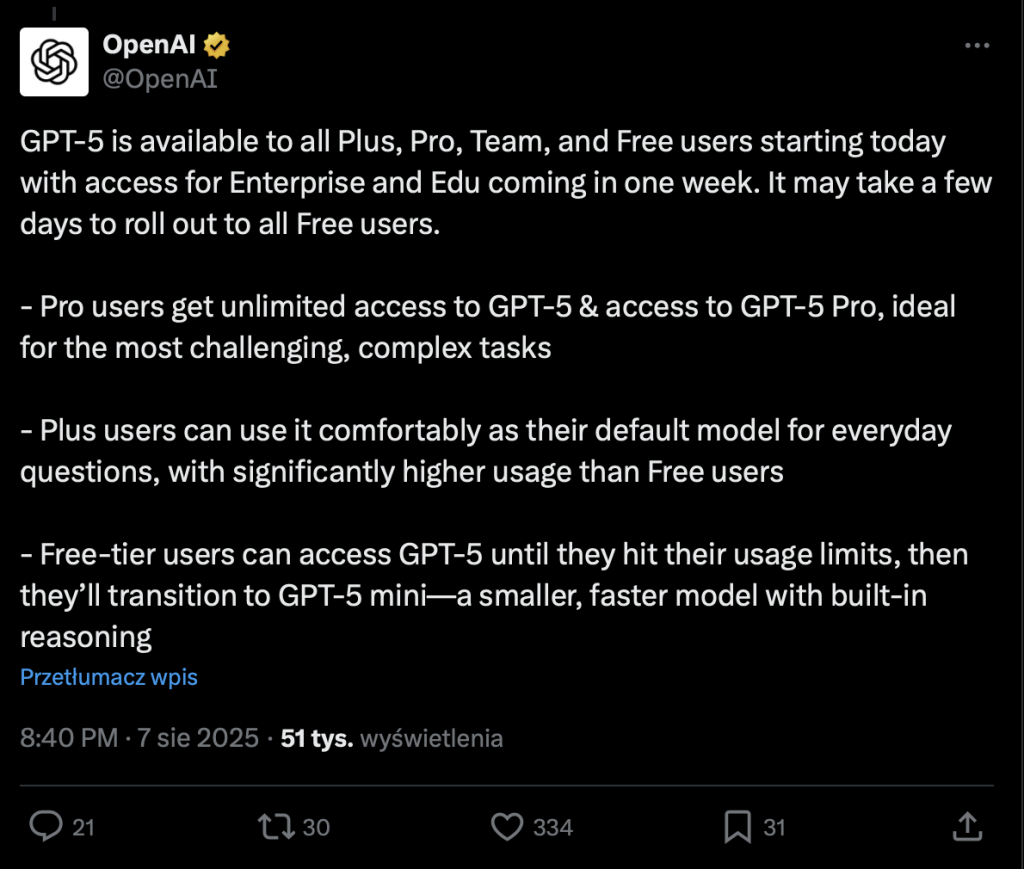

Wraz z premierą GPT-5 OpenAI zmienia zasady dystrybucji. Model jest dostępny od ręki dla wszystkich, ale firma rezygnuje z ręcznego wyboru wersji, który znaliśmy z czasów GPT-3.5 i GPT-4. Teraz to system decyduje, z jakiej mocy obliczeniowej skorzystamy.

W interfejsie ChatGPT model jest domyślny, a jego wariant zależy od posiadanego planu:

- Użytkownicy darmowi otrzymują dostęp do flagowego modelu GPT-5, jednak po wyczerpaniu limitu odpowiedzi zostaną przełączeni na GPT-5 mini, z naturalnymi ograniczeniami wydajności.

- Subskrybenci planu Plus (20 USD/mies.) pracują na pełnej wersji GPT-5 ze znacznie wyższym limitem jej wykorzystania.

- Plan Pro dostęp do GPT-5 Pro, wariantu zoptymalizowanego pod kątem najcięższych zadań i dłuższego kontekstu.

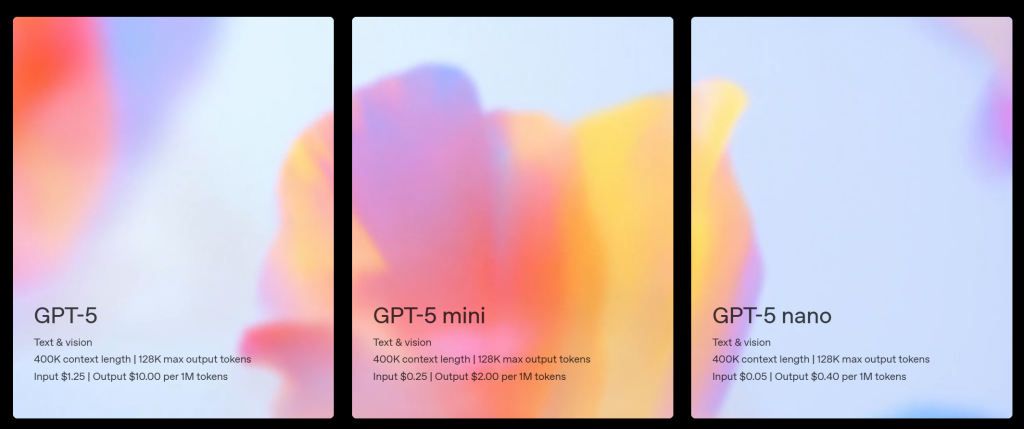

Dla deweloperów przygotowano trzy warianty dostępne przez API: od najlżejszego nano, przez zbalansowany mini, aż po pełnowymiarowy GPT-5 do najbardziej złożonych zastosowań.

Między obietnicą a rzeczywistością

Komunikacja wokół premiery GPT-5 była zręcznie prowadzona. Seria zapowiedzi pod hasłem „OpenAI Summer Update”, szybkie wprowadzenie Agenta, trybu nauki i modeli open-source – wszystko to budowało narrację o firmie, która przyspiesza i otwiera się na użytkowników. Ale za tą fasadą kryje się kilka kwestii, które warto doprecyzować.

Najważniejsza z nich to wspomniane już porównanie do „osoby z doktoratem”. To sformułowanie, choć chwytliwe, celowo zaciera granicę między maszynowym przetwarzaniem a ludzką ekspertyzą. Model nie rozumie świata, nie ma świadomości ani zdolności do autonomicznego myślenia. Przetwarza dane, szukając wzorców i korelacji. Jeśli „doktorat” ma oznaczać precyzję, głębię i poznawczą odpowiedzialność, GPT-5 wciąż pozostaje tylko narzędziem, a nie równorzędnym partnerem do dyskusji.

Ostatecznym testem dla GPT-5 nie będą jednak ani starannie dobrane benchmarki, ani zręcznie prowadzona kampania marketingowa. Prawdziwa weryfikacja nadejdzie w momencie, gdy model trafi pod strzechy – do firm, szkół i na ekrany milionów użytkowników, którzy sprawdzą jego realną wartość w codziennych zadaniach. Na razie pozostaje nam obserwować fascynujący spektakl: z jednej strony obietnice rewolucji, z drugiej – pierwsze, ostrożne reakcje rynku. To, co wyłania się z tego obrazu, to nie tylko portret nowej technologii, ale przede wszystkim strategia firmy, która na nowo definiuje zasady gry na rynku sztucznej inteligencji.

Co dalej?

Czy premiera GPT-5 otwiera nowy rozdział? OpenAI wyraźnie zmienia strategię: zamiast dawać użytkownikom wybór między modelami, przenosi ciężar decyzji na system, który sam dobiera odpowiednią moc. Jednocześnie firma stawia na bezpieczeństwo, świadomie rezygnując z uczenia się modelu w czasie rzeczywistym. To kluczowa decyzja, która stawia stabilność ponad dynamikę

Jakie będą kolejne kroki? Naturalnym kierunkiem wydaje się dalszy rozwój architektury agentowej, głębsze integracje z zewnętrznymi aplikacjami i nacisk na multimodalność – zdolność do płynnego przetwarzania tekstu, obrazu i dźwięku w ramach jednego systemu. Na horyzoncie majaczy też coraz bardziej zaawansowana personalizacja, która pozwoli modelowi lepiej rozumieć kontekst i potrzeby konkretnego użytkownika.

GPT-5 to raczej przystanek na drodze do stworzenia architektury, która coraz mniej przypomina narzędzie, a coraz bardziej – system operacyjny wspomagający ludzkie myślenie. To, jak wykorzystamy jego potencjał i jakie granice mu postawimy – technologiczne, etyczne i prawne – zależy już nie tylko od jego twórców, ale od nas wszystkich.

Na koniec OpenAI Summer Update miły polski akcent – Jakub Pachocki, Chief Scientist w OpenAI, podziękował całemu zespołowi za zaangażowanie.