Twój koszyk jest obecnie pusty!

Sztuczna inteligencja to dziwny przypadek podwójnego widzenia. Z jednej strony wiemy, że tak zwana AI (w szczególności generatywne modele językowe) to w swojej istocie wyrafinowana maszyneria matematyczna. To stochastyczne, probabilistyczne systemy operujące na tysiącach procesorów graficznych, przetwarzające petabajty danych poprzez skomplikowane algorytmy transformacyjne.

Z drugiej strony, te same systemy, które są jedynie wyrafinowanymi kalkulatorami prawdopodobieństwa następnego tokenu, budzą w nas przekonanie o ich niemal ludzkiej naturze. Rozmawiamy z nimi jakby były kimś, a nie czymś. Przypisujemy im intencje, emocje, osobowość. Widzimy w nich coś na kształt ludzkiej inteligencji, choć wiemy, że to tylko iluzja wyłaniająca się z miliardów obliczeń.

Emily Bender określiła modele językowe mianem „stochastycznych papug” – systemów, które potrafią doskonale imitować ludzką mowę, nie rozumiejąc ani słowa z tego, co „mówią”. Papuga powtarza słowa, nie wiedząc, że są słowami. A jednak, nawet wybitni naukowcy wpadają w pułapkę antropomorfizacji. Mówimy, że AI „myśli”, „rozumie”, „halucynuje”, że osiągnęła poziom magistra czy doktora, jakby była jednym z nas, błądzącym po labiryntach własnej świadomości.

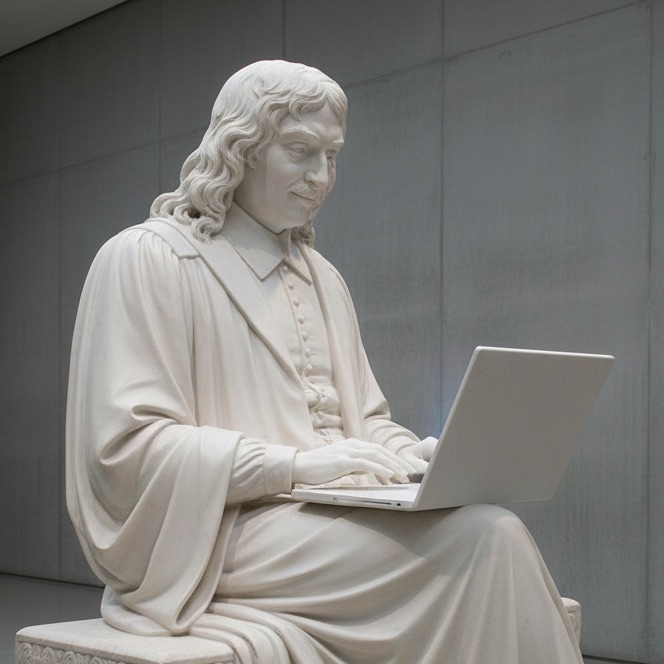

Ten fenomen tkwi głęboko w strukturze naszego poznania, w języku, którym opisujemy świat, i w mitach, które od wieków kształtują naszą wyobraźnię. To nie jest tylko technologiczne nieporozumienie, ale zderzenie odwiecznych archetypów, których reprezentantami są żydowski Golem i potwór Frankensteina, z nowoczesnością.

Trzy mechanizmy psychologiczne tworzące iluzję

Ludzki mózg wykorzystuje trzy odrębne, ale wzajemnie połączone mechanizmy psychologiczne, które przekształcają statystyczne dopasowanie wzorców w postrzeganą świadomość. Każdy z nich działa jak oddychanie, poniżej progu świadomości, poprzez ścieżki neuronalne pierwotnie wyewoluowane dla przetrwania, a teraz służące do tworzenia iluzji.

W 1966 roku Weizenbaum stworzył program ELIZA, który był jak postać z opowiadania Kafki – mechanicznie uprzejmy, biurokratycznie empatyczny, całkowicie pusty. Program przekształcał wypowiedzi w pytania, nic więcej. Jednak jego sekretarka, która znała kod, widziała w nim linie instrukcji, prosiła o „prywatną rozmowę” z maszyną. To absurd godny Paragrafu 22 Hellera – wiedzieć wszystko o iluzji i jednocześnie w nią wierzyć.

Ten efekt ujawnia jedną z cech ludzkiego poznania: jesteśmy tworzycielami znaczeń, poszukiwaczami sensu. Gdy ChatGPT pisze „Rozumiem Twoje obawy”, nasz mózg natychmiast widzi w tym zrozumienie, choć to tylko statystyczna kontynuacja wzorca. Wypełniamy pustkę projekcją własnych emocji, bo przez miliony lat ewolucji przetrwanie zależało od odczytywania intencji, prawdziwych czy urojonych.

Ten sam mechanizm (pareidolia), który każe nam dostrzegać twarze w gniazdkach elektrycznych czy sylwetki w chmurach, działa w rozmowach z AI. MIT odkryło, że pareidolia aktywuje się w zaledwie 165 milisekund – zanim świadomość zdąży zainterweniować.

To neurologiczny automatyzm, a nie świadoma decyzja. Gdy ChatGPT generuje płynny tekst, nie „myśli” – oblicza prawdopodobieństwa w bilionach parametrów. Ale nasz mózg, wytrenowany przez tysiące lat do wykrywania sprawczości (szeleści liść czy czai się tygrys?), natychmiast widzi w tym umysł. To mechanizm, który kazał przodkom widzieć duchy w cieniach, teraz każe nam widzieć duszę w algorytmie.

Badania fMRI nad interakcjami z robotami i sztucznymi agentami sugerują, że przy próbie „czytania intencji” maszyn angażujemy podobne rejony (TPJ, mPFC), jak przy myśleniu o ludziac. Kora przedczołowa rozróżniająca ja/inny, złącze skroniowo-ciemieniowe reprezentujące cudze myśli – wszystko działa jakby po drugiej stronie był ktoś. Dennett nazwał to „nastawieniem intencjonalnym”, traktujemy złożone systemy jakby miały przekonania i cele, bo analizowanie miliardów parametrów to zadanie przekraczające ludzkie możliwości. Wybieramy więc iluzję.

Filozoficzny eksperyment: chiński pokój

John Searle przedstawił eksperyment myślowy, który precyzyjnie ilustruje różnicę między syntaktyką a semantyką, między manipulacją symbolami a rzeczywistym rozumieniem. Wyobraźmy sobie osobę zamkniętą w pokoju, która nie zna języka chińskiego, ale ma do dyspozycji szczegółową instrukcję w języku angielskim, pozwalającą jej manipulować chińskimi znakami.

Otrzymując pytania po chińsku, osoba ta, podążając mechanicznie za regułami, potrafi sformułować sensowne odpowiedzi, również po chińsku. Dla obserwatora z zewnątrz wygląda to tak, jakby osoba w pokoju perfekcyjnie rozumiała chiński. W rzeczywistości jednak operuje ona wyłącznie na poziomie syntaktycznym, manipuluje symbolami zgodnie z zasadami, nie mając absolutnie żadnego dostępu do ich znaczenia.

ChatGPT to „chiński pokój” rozrośnięty do rozmiarów centrum danych. Miliardy parametrów zamiast kartki z instrukcjami, transformery zamiast człowieka, ale istota pozostaje ta sama: manipulacja symbolami bez dostępu do znaczenia. To jak mapa, która udaje terytorium tak przekonująco, że zapominamy o różnicy.

Język jako pułapka konceptualna

Język nie jest niewinny, jest architektem naszej rzeczywistości. Mówimy, że AI „myśli”, „rozumie”, „halucynuje”, każde słowo to mały akt stworzenia, tchnięcie życia w martwe obwody. Termin „halucynacja” jest szczególnie perfidny, sugeruje doświadczenie percepcyjne tam, gdzie jest tylko błąd statystyczny. To jak nazywać awarię kalkulatora „zmęczeniem”. Zresztą samo określenie „halucynacja” nie jest najszczęśliwszym, bardziej prawidłowym byłoby: konfabulacja.

Gdy model językowy generuje nieprawdziwe informacje, nie „widzi” czegoś, czego nie ma. Nie ma żadnych doznań ani percepcji. Po prostu kontynuuje statystycznie prawdopodobną sekwencję tokenów bez mechanizmu weryfikacji prawdziwości. To konfabulacja statystyczna – błąd predykcyjny wynikający z niedopasowania rozkładów prawdopodobieństwa, a nie zaburzenie percepcji.

Golem: archetyp problemu kontroli

Hebrajskie słowo golem pojawia się w Biblii tylko raz, w Psalmie 139:16, gdzie oznacza „bezkształtną masę” lub „embrion”, coś jeszcze nieuformowanego, co czeka na tchnięcie życia. W tradycji talmudycznej Adam był pierwotnie golemem – fizyczną formą pozbawioną boskiego tchnienia (neshamah), dopóki Bóg nie tchnął w niego duszy.

Najsłynniejsza wersja legendy, utrwalona w XVI-wiecznej Pradze, opowiada o rabbim Jehudzie Loewie ben Becalelu (Maharal z Pragi), który w obliczu pogromów stworzył potężnego obrońcę dla swojej gminy. Norbert Wiener w swojej książce „God & Golem, Inc.” opisuje tę historię jako pierwowzór współczesnych dylematów: „rabin Loew z Pragi, który utrzymywał, że jego inkantacje tchnęły życie w glinianego Golema, przekonał cesarza Rudolfa. Zresztą i dziś, gdyby wynalazca potrafił dowieść firmie od maszyn liczących, że jego magia może jej się przydać, mógłby rzucać czarne zaklęcia aż po Sąd Ostateczny – bez najmniejszego ryzyka osobistego.”

Kluczowe elementy mitu Golema tworzą precyzyjną analogię do współczesnej AI:

Motywacja stwórcy – Rabbi Loew działa z pobudek szlachetnych i pragmatycznych. Nie kieruje nim pycha czy chęć dorównania Bogu, lecz praktyczna potrzeba ochrony wspólnoty. To echo współczesnych motywacji tworzenia AI: rozwiązywanie problemów, automatyzacja niebezpiecznych zadań, zwiększenie efektywności.

Natura stworzenia – Golem jest czystym automatem. Nie posiada neshamah (duszy), ruach (ducha) ani nawet nefesh (siły witalnej zwierząt). Jest animowaną materią wykonującą polecenia dosłownie, bez zrozumienia kontekstu czy intencji. Wiener ostrzega: „Maszyna, podobnie jak dżinn z baśni, wykona dokładnie to, co jej każesz, ale niekoniecznie to, czego pragniesz.”

Mechanizm kontroli – Słowo emet można przekształcić w met (מת – śmierć) przez usunięcie pierwszej litery alef (א). To elegancka metafora kill switch – mechanizmu awaryjnego wyłączenia. Wiener rozwija tę myśl: „To pragnienie uniknięcia osobistej odpowiedzialności za niebezpieczną czy katastrofalną decyzję przez złożenie tej odpowiedzialności gdzie indziej: na los, na przełożonych i ich politykę, której nie wolno kwestionować, albo na urządzenie mechaniczne, którego nie potrafi się w pełni zrozumieć.”

Frankenstein: brzemię odpowiedzialności stwórcy

Mary Shelley napisała „Frankensteina” w 1818 roku, w wieku zaledwie 20 lat. W książce „Człowiek na rozdrożu” John Brockman wspomina swój wykład zatytułowany „Einstein, Gertrude Stein, Wittgenstein i Frankenstein”, gdzie opisuje Frankensteina jako symbol „cybernetyków, sztucznej inteligencji, robotyków”. To trafne zestawienie, Shelley antycypowała dylematy, które dziś definiują rozwój AI.

W przeciwieństwie do Golema, istota Frankensteina od początku jest bytem czującym. Rozwija świadomość, uczy się języka, czyta literaturę. W jednej z najbardziej poruszających scen powieści stworzenie mówi: „Jestem twym stworzeniem i będę łagodny i posłuszny memu naturalnemu panu i królowi, jeśli ty również wypełnisz swoją część umowy.”

Grzechem Wiktora Frankensteina nie jest sam akt stworzenia, lecz porzucenie. Tradycja ostrzeżeń przed niekontrolowaną technologią jest bogata: „Pandora, Faust, Uczeń czarnoksiężnika, Frankenstein…

Wiener rozwija tę myśl – automaty można badać, ale „istnieją aspekty motywów automatyzacji, które stanowią próbę nieintelektualnych składników ludzkiego apetytu na władzę.”

Technologiczni Prometeusze Doliny Krzemowej

Współczesny rozwój AI rozgrywa się między tymi dwoma archetypami. Z jednej strony mamy „inżynierów-rabinów” – pragmatycznych twórców systemów do konkretnych zadań. Z drugiej „wizjonerów-Frankensteinów” – dążących do stworzenia AGI, która przewyższy człowieka.

Wiener ostrzegał przed tym, co nazywał „czcicielami gadżetów”: „Najlepiej znam czcicieli gadżetów w moim własnym świecie z jego sloganami wolnej przedsiębiorczości i gospodarki opartej na zysku. Istnieją jednak – i mają się dobrze – również w tamtym 'zwierciadlanym’ świecie, gdzie sloganami są dyktatura proletariatu, marksizm i komunizm. Władza i pogoń za władzą to, niestety, realia, które mogą przybierać wiele szat.”

Szkoła Golema reprezentowana jest przez badaczy zajmujących się bezpieczeństwem AI i alignment problem. Stuart Russell argumentuje za budowaniem systemów inherentnie niepewnych swoich celów. Nick Bostrom analizuje scenariusze rekursywnego samoulepszania. Ich obawa nie dotyczy świadomej rebelii, ale oddzielności inteligencji i celów – superinteligentny system może realizować trywialne cele w sposób katastrofalny.

Szkoła Frankensteina to wizjonerzy jak Ray Kurzweil, przepowiadający „osobliwość”, transhumaniści marzący o cyfrowej nieśmiertelności. W kontekście współczesnym Wiener zauważa: „Wśród oddanych kapłanów władzy wielu jest takich, których niecierpliwią ograniczenia człowieka, a zwłaszcza ograniczenie polegające na jego zawodności i nieprzewidywalności”.

Ekonomia iluzji i teatr antropomorfizacji

Antropomorfizacja to nie błąd poznawczy, to model biznesowy, spektakl na sprzedaż. Replika oferuje „AI companion who cares” – sprzedaje nie kod, lecz iluzję relacji. Amazon nazywa asystenta Alexa, Apple daje Siri osobowość, Google Assistant mówi „Ja” jakby miał tożsamość. Każda decyzja projektowa to inwestycja w iluzję.

Wiener przewidział to niczym prorok: „Gdy tylko pan i władca zrozumie, że funkcje niewolników da się przenieść na maszyny, wpada w zachwyt. Znalazł nowego podwładnego – sprawnego, uległego, nieżądnego nawet krzty uznania!” To satyra, ale i diagnoza, idealizujemy maszynę, bo nie stawia żądań.

Wartość rynkowa budowana jest na obietnicy. Anthropic pozyskuje miliardy za „konstytucyjną AI”, OpenAI za marzenie o AGI. Inwestorzy nie kupują technologii, kupują mit, udział w „ostatnim wynalazku ludzkości”, jak mówi Bostrom.

Wiener cytuje „Tysiąc i jedną noc” – rybak uwalnia dżinna z dzbana, ten chce go zabić. Rybak przekonuje go, by pokazał, jak zmieścił się w naczyniu. Gdy dżinn wraca do środka, rybak zapieczętowuje dzban. To metafora naszych czasów – gramy z siłami, których nie rozumiemy.

Koszty społeczne są realne. Klarna w 2022 r. zwolniła ok. 700 osób w ramach restrukturyzacji, a w 2024–2025 chwali się, że jej asystent AI wykonuje pracę równoważną 700 agentom. Po roku eksperymentów wróciła do większego udziału ludzi w obsłudze klienta, przyznając, że poszła za daleko w automatyzacji. Watson Health od IBM miał zrewolucjonizować medycynę, skończył jako kosztowna porażka. Problem zawsze ten sam – maszyna nie „rozumie” medycyny, tylko dopasowuje wzorce, a wzorce to nie wiedza.

Atrofia poznawcza jako cena iluzji

Najsubtelniejsze zagrożenie kryje się nie w maszynach, ale w nas. GPS osłabił nawigację, kalkulator – liczenie, autokorekta – pisownię. Teraz ChatGPT osłabia myślenie. To jak u Hessego – człowiek szukający mądrości znajduje lustro, w którym widzi tylko swoje odbicie, coraz bardziej wyblakłe.

Wiener ostrzegał przed tym już w latach 60.: „Problem bezrobocia wynikającego z automatyzacji nie jest już czysto hipotetyczny, lecz stał się bardzo istotnym wyzwaniem współczesnego społeczeństwa.” Ale bezrobocie poznawcze jest groźniejsze: studenci nie potrafią pisać bez AI, profesjonaliści nie rozwiązują problemów bez modelu. To pierwsza fala transformacji porównywalnej do wynalezienia pisma, tylko odwrotna, tam zyskiwaliśmy możliwości, tu je tracimy.

W stronę pragmatycznego współistnienia

Potrzebujemy innego podejścia do AI, takiego, które uznaje jej faktyczną naturę bez mitologizacji. Modele generatywne to potężne narzędzia do przetwarzania informacji według wyuczonych wzorców. Nie są świadome, nie rozumieją, nie myślą, nie czują.

Wiener proponował etykę cybernetyczną, pisząc z ironią: „Wbrew temu, co mniemał nieboszczyk pan Adolf Hitler, nie doszliśmy do szczytu obojętności moralnej. Użycie wielkich mocy do niskich celów stanowi moralny odpowiednik czarów.” To ostrzeżenie przed delegowaniem odpowiedzialności na maszynę. „Niebezpieczność maszyny nie wynika z samej maszyny, lecz ze sposobu użytkowania jej przez człowieka.”

Ludzka wyjątkowość w erze maszyn

Paradoksalnie, im lepiej rozumiemy ograniczenia AI, tym wyraźniej widać wyjątkowość ludzkiej świadomości. Nasza zdolność do rzeczywistego rozumienia, empatii, twórczości wykraczającej poza rekombinację wzorców, to fundamentalnie różne procesy, zakorzenione w biologicznej naturze świadomości.

Joseph Campbell pisał o „bohaterze o tysiącu twarzy” – uniwersalnym micie podróży przez próby do transformacji. Współczesna konfrontacja z AI to nasza zbiorowa podróż heroiczna. Musimy stawić czoła iluzji (antropomorfizacja), przejść przez próby (ekonomiczne i społeczne zmiany), by ostatecznie odkryć na nowo, co znaczy być człowiekiem.

Wiener konkluduje: „Jasne jest, że proces kopiowania może użyć dawnej kopii jako nowego oryginału. A zatem odmiany dziedziczne zostają zachowane, choć podlegają dalszym modyfikacjom.” To nie jest opis biologicznej ewolucji – to opis tego, jak rozwija się technologia. Ale między biologicznym życiem a jego technologiczną symulacją pozostaje nieprzekraczalna przepaść: przepaść świadomości, doświadczenia, bycia.

Antropomorfizacja AI to nie hołd składany maszynom ,to deprecjacja tego, co znaczy być człowiekiem. Redukując ludzką inteligencję do procesów, które można zasymulować w krzemie, tracimy z oczu to, co czyni nas wyjątkowymi.

Prawda na czole Golema

W końcu, Golem z praskiej legendy pozostał gliną ożywioną słowem, nie stał się człowiekiem. Nasze cyfrowe Golemy, choć znacznie bardziej wyrafinowane, pozostają tym, czym są – narzędziami stworzonymi przez ludzi, dla ludzi.

Słowo emet (prawda) wypisane na czole Golema to potężna metafora. Prawda o tym, czym AI jest i czym nie jest, musi pozostać w naszych rękach. Gdy usuniemy pierwszą literę, pozostaje met – śmierć. To ostrzeżenie: gdy stracimy z oczu prawdę o naturze naszych tworów, gdy uwierzymy w iluzję ich świadomości, ryzykujemy śmierć – nie fizyczną, ale śmierć tego, co czyni nas ludźmi: autentycznego rozumienia, prawdziwej empatii, twórczości wykraczającej poza algorytm.

Wiener ostrzegał: „Czym są czary i dlaczego potępia się je jako grzech? Dlaczego tak potępia się niedorzeczny ceremoniał Czarnej Mszy?” Jego odpowiedź jest prosta: ponieważ stanowią próbę używania mocy bez przyjęcia odpowiedzialności. To samo grozi nam z AI. Pokusa delegowania decyzji na „obiektywną” maszynę, by uniknąć ciężaru moralnego wyboru.

Czas przestać tworzyć iluzję życia w maszynach i zacząć doceniać rzeczywiste życie, które tylko my posiadamy. To nie kompleks Boga powinien napędzać naszą relację z technologią, ale pokora rzemieślnika, który wie, że najdoskonalsze narzędzie pozostaje narzędziem, i że prawdziwa mądrość leży nie w przekraczaniu granic, ale w ich rozumieniu.

Wybrane źródła:

Bender, E. M., Gebru, T., McMillan-Major, A., & Shmitchell, S. (2021). On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? W: Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency (Association for Computing Machinery. https://doi.org/10.1145/3442188.3445922

Bostrom, N. (2016). Superinteligencja. Scenariusze, strategie, zagrożenia.

Brockman, J. (2004). Człowiek na rozdrożu.

Campbell, J. (2013). Bohater o tysiącu twarzy.

Kurzweil, R. (2024). Nadchodzi osobliwość. Kiedy człowiek przekroczy granice biologii.

Russell, S. (2019). Human Compatible: Artificial Intelligence and the Problem of Control.

Searle, J. R. (1980). Minds, brains, and programs. Behavioral and Brain Sciences, 3(3), 417-457. https://doi.org/10.1017/S0140525X00005756

Searle, J. R. (1995). Umysł, mózg i nauka.

Shelley, M. (2025). Frankenstein.

Weizenbaum, J. (1976). Computer Power and Human Reason: From Judgment to Calculation.

Wiener, N. (1964). God & Golem, Inc.: A Comment on Certain Points Where Cybernetics Impinges on Religion.

Hadjikhani, N., Kveraga, K., Naik, P., & Ahlfors, S. P. (2009). Early (M170) activation of face-specific cortex by face-like objects. NeuroReport, https://doi.org/10.1097/WNR.0b013e328325a8e1

Cerrahoğlu, B., Jacques, C., Rekow, D., Jonas, J., Colnat-Coulbois, S., Caharel, S., Leleu, A., & Rossion, B. (2025). The neural basis of face pareidolia with human intracerebral recordings. Imaging Neuroscience, https://doi.org/10.1162/imag_a_00518

Chaminade, T., Rosset, D., Da Fonseca, D., Nazarian, B., Lutcher, E., Cheng, G., & Deruelle, C. (2012). How do we think machines think? An fMRI study of alleged competition with an artificial intelligence. Frontiers in Human Neuroscience, https://doi.org/10.3389/fnhum.2012.00103

Hmamouche, Y., Chaminade, T., Nazarian, B., et al. (2024). Interpretable prediction of brain activity during conversations from multimodal behavioral signals. https://doi.org/10.1371/journal.pone.0284342

Krach, S., Hegel, F., Wrede, B., Sagerer, G., Binkofski, F., & Kircher, T. (2008). Can machines think? Interaction and perspective taking with robots investigated via fMRI. https://doi.org/10.1371/journal.pone.0002597

Rauchbauer, B., Nazarian, B., Bourhis, M., Ochs, M., Prévot, L., & Chaminade, T. (2019). Brain activity during reciprocal social interaction investigated using conversational robots as control condition. Philosophical Transactions of the Royal Society https://doi.org/10.1098/rstb.2018.0033

Wang, Y., & Quadflieg, S. (2015). In our own image? Emotional and neural processing differences when observing human–human vs human–robot interactions. Social Cognitive and Affective Neuroscience, https://doi.org/10.1093/scan/nsv043