Twój koszyk jest obecnie pusty!

Metafora Andrew Nga „AI to nowa elektryczność”, przez lata doskonale opisywała wszechobecną, ale często niewidoczną siłę, która napędzała zmiany technologiczne. Teza Andreja Karpathego jest znacznie bardziej radykalna: sztuczna inteligencja przestała być jedynie użyteczna, jak na przykład prąd z gniazdka. Przekształciła się w coś fundamentalnie innego – w nowy, uniwersalny komputer. Stała się platformą, na której będziemy tworzyć, a nie tylko siłą, którą karmimy istniejące systemy. Jesteśmy pierwszym pokoleniem, które uczy się pisać programy, używając najbardziej naturalnego z interfejsów: języka angielskiego.

Próg wejścia, który przez dekady wyznaczała znajomość skomplikowanej składni, właśnie znika. Karpathy mówi to wprost i zaprasza nas do nowej rzeczywistości: witajcie w erze Software 3.0.

Kim jest Andrej Karpathy?

A gdy mówi akurat Karpathy, to naprawdę warto słuchać… Sam przeszedł drogę od badań nad sieciami konwolucyjnymi i rekurencyjnymi na Uniwersytecie Stanforda, na którym współtworzył istotne prace z zakresu widzenia komputerowego i łączenia obrazu z językiem, przez współtworzenie pierwotnego zespołu badawczego OpenAI w pierwotnej, non-profitowej misji, aż po kluczowe stanowisko szefa działu AI w Tesli.

Źródło: karpathy.ai

I to właśnie tam, gdy przez pięć lat dowodził zespołem, który rozwijał Autopilota, nauczył się, jak gigantyczna potrafi być przepaść między efektownym demem a gotowym produktem, który można wypuścić na rynek masowy. Zrozumiał, że prawdziwe wyzwanie polega nie na stworzeniu modelu, który działa w 95% przypadków, lecz obsługa nieskończonej liczby nietypowych sytuacji, które decydują o bezpieczeństwie. Na początku 2023 roku Karpathy ponownie dołączył do OpenAI, jednak jego druga przygoda z firmą okazała się krótka. Już na początku 2024 roku Karpathy ponownie opuścił OpenAI, by skupić się na własnych, niezależnych projektach.

Trzy epoki oprogramowania

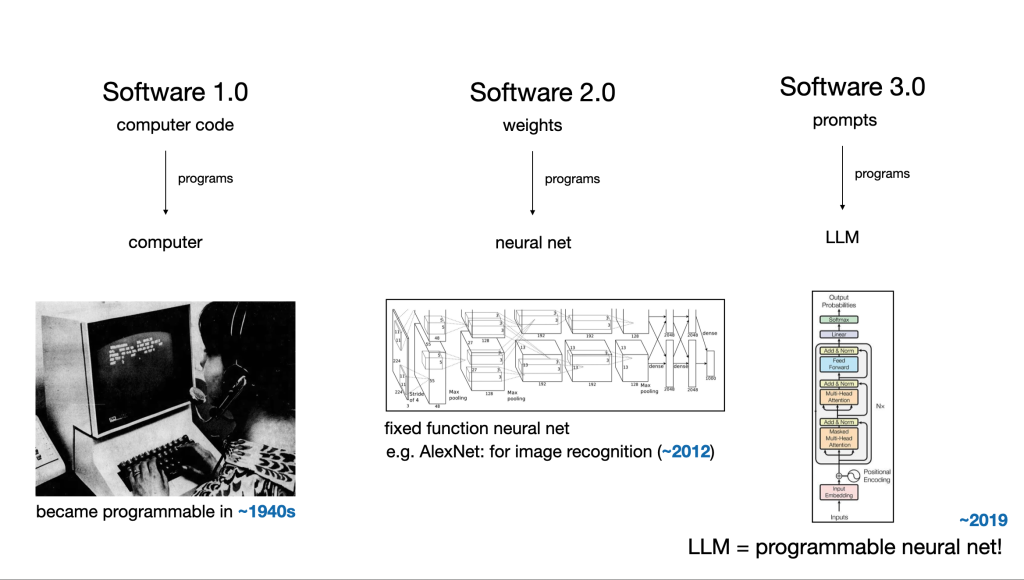

Aby w pełni zrozumieć skalę obecnej transformacji, Karpathy proponuje, by spojrzeć na historię technologii przez pryzmat rozwoju oprogramowania. Każda z nich reprezentuje fundamentalnie inny paradygmat tworzenia i myślenia o kodzie.

Software 1.0 był światem klasycznym, rządzony przez jawną, deterministyczną logikę. Programista był rzemieślnikiem, który za pomocą języków takich jak C++ czy Java, linijka po linijce budował skomplikowane mechanizmy z pętli, instrukcji warunkowych i struktur danych. Każdy element programu był bezpośrednim odzwierciedleniem jego myśli. Systemy były precyzyjne i przewidywalne, ale jednocześnie kruche i niezdolne do radzenia sobie z niejednoznacznością realnego świata taką, jak rozpoznawanie twarzy czy rozumienie mowy.

Software 2.0 to owoc rewolucji uczenia maszynowego. Zamiast pisać sztywne reguły, zaczęliśmy pokazywać maszynie przykłady. Kod w dużej mierze zastąpiliśmy danymi. Z rzemieślników staliśmy się nauczycielami i kuratorami danych, których głównym zadaniem było zbieranie, czyszczenie i etykietowanie ogromnych zbiorów treningowych. Właśnie w ten sposób powstały systemy zdolne do rozpoznawania obiektów na zdjęciach, filtrowania spamu czy prowadzenia samochodu. Stworzyliśmy potężne, ale często nieprzeniknione „czarne skrzynki”.

Software 3.0 tu i teraz wprowadza zmiany jeszcze głębszą niż poprzednia rewolucja. Programujemy w języku naturalnym, poprzez prowadzenie dialogu z modelem. Zamiast pisać kod (jak w 1.0) lub kuratorować dane (jak w 2.0), po prostu opisujemy problem i przekazujemy, jakiego rezultatu oczekujemy. Kodu już nie piszemy, lecz syntetyzujemy na bieżąco przez potężny, wytrenowany wcześniej model. Rola człowieka znów się zmienia – staje się on architektem, redaktorem i psychologiem AI, który musi precyzyjnie formułować polecenia i krytycznie oceniać wyniki. To radykalnie obniża barierę wejścia, ale jednocześnie rodzi nowe, fundamentalne pytania. Nie chodzi już bowiem tylko o to, czy kod działa, ale o to, jak ufać czemuś, co powstało w odpowiedzi na kilka luźnych zdań. Jak zapewnić jego niezawodność, bezpieczeństwo i przewidywalność w krytycznych zastosowaniach?

LLM jako nowy komputer mainframe

Aby pomóc nam zrozumieć tę zmianę, Karpathy proponuje intrygującą analogię. Według niej wielki model językowy (LLM) działa dziś jak cały komputer. Sam model, na przykład GPT-4, jest odpowiednikiem procesora (CPU) – centralnej jednostki, która wykonuje wszystkie polecenia. Okno kontekstowe pełni rolę pamięci RAM, które przechowuje bieżące instrukcje i dane potrzebne do operacji. Z kolei narzędzia i wtyczki, takie jak dostęp do internetu, kalkulator czy interpreter kodu, funkcjonują jak peryferia i sterowniki, które pozwalają procesorowi komunikować się ze światem zewnętrznym. W tej metaforze aplikacje pokroju Cursora czy Perplexity stają się przenośnymi programami, które można uruchomić na różnych „systemach operacyjnych” (modelach AI).

Karpathemu obecna sytuacja przypomina lata 60. i erę komputerów mainframe: potężnych, scentralizowanych maszyn, do których użytkownicy podłączali się przez proste terminale i dzielili między sobą czas obliczeniowy. Dziś tymi terminalami są okna czatów, a my współdzielimy zasoby obliczeniowe OpenAI, Google czy Anthropic.

Psychologia modelu

Jednym z największych wyzwań jest głęboko nietypowa „psychologia” tych nowych komputerów. Karpathy opisuje ją jako fascynujące i paradoksalne połączenie dwóch filmowych postaci. Z jednej strony LLM-y są jak Raymond z „Rain Mana” – genialne sawanty z fotograficzną, bezbłędną pamięcią krótkotrwałą. W ramach aktywnego okna kontekstowego potrafią błyskawicznie przetworzyć i skorelować tysiące stron tekstu i rozwiązywać problemy w sposób niedostępny dla ludzkiego umysłu. Nie zapomną ani jednego szczegółu, który im podano. Ten geniusz jest jednak ulotny i ograniczony do bieżącej chwili. Z drugiej strony przypominają Leonard z „Memento” – cierpią na głęboką formę amnezji. Gdy kontekst znika, znika też pamięć. Nie mają trwałego, stabilnego rozumienia świata i są niewiarygodnie podatne na sugestie. A w związku z tym, że w samej swej istocie są maszynami do przewidywania, nie zaś do rozumowania, łatwo je zwieść. Wystarczy jedna, subtelnie myląca podpowiedź, by zaczęły halucynować – z pełnym przekonaniem generować wiarygodnie brzmiące, ale całkowicie zmyślone informacje. Nawet nie kłamstwa, lecz statystyczne echa, które brzmią poprawnie i bardzo wiarygodnie, co czyni je szczególnie podstępnymi. Dlatego jedyną skuteczną strategią pracy z nimi jest prosta zasada: generuj, a potem weryfikuj. To człowiek musi pozostać pilotem. Wykorzystywać niezwykłą szybkość maszyny, ale równocześnie dostarczać krytyczne myślenie i ostateczną ocenę.

Suwak autonomii i kodowanie na luzie

Zamiast dążyć do pełnej, często kruchej autonomii AI, Karpathy promuje znacznie bardziej pragmatyczną ideę „suwaka autonomii”. Chodzi o to, by tworzyć systemy, które działają jak egzoszkielet z filmu „Iron Man” – nie zastępują człowieka, lecz wzmacniają jego zdolności. W tym modelu AI staje się potężnym partnerem: generuje kod, pisze szkic tekstu, analizuje zbiór danych czy tworzy propozycję graficzną. Ale w centrum decyzyjnym pozostaje człowiek. Jednym kliknięciem akceptuje, modyfikuje lub odrzuca propozycję. To on ma pełną kontrolę nad ostatecznym wynikiem. Takie podejście buduje zaufanie i pozwala użytkownikowi stopniowo delegować coraz więcej zadań.

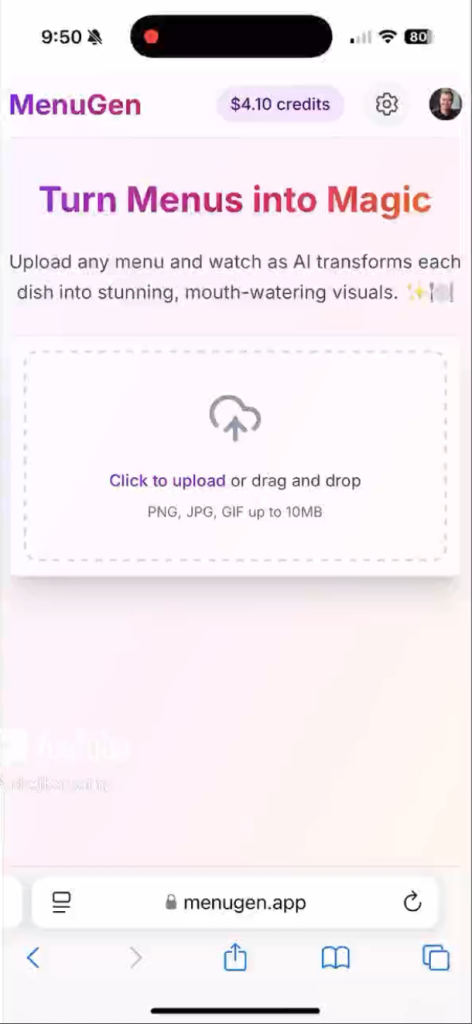

Sam przeprowadził eksperyment, który nazwał „Vibe Coding”. W pojedynczy weekend postanowił stworzyć w pełni funkcjonalną aplikację mobilną. I to mimo tego, że nie znał języka Swift. Jak to zrobił? Otóż zamiast spędzać tygodnie na nauce składni i przeglądaniu dokumentacji, po prostu „rozmawiał” z LLM-em jak z doświadczonym kolegą-programistą. „Wygeneruj mi widok główny z trzema przyciskami”, „To nie działa, spróbuj inaczej”, „Jak wycentrować ten element?”.

Karpathy nie napisał ręcznie ani jednej linijki kodu aplikacji „MenuGen”. Eksperyment pokazał, że znajomość konkretnego języka nie jest już dziś kluczowa. W przeciwieństwie do umiejętności precyzyjnego opisywania problemu i krytycznej oceny zaproponowanego rozwiązania.

Eksperyment wskazał jednak również istnienie problemu. Ten pojawił przy próbie integracji aplikacji z systemami płatności, uwierzytelnianiem i konfiguracją serwera. Model, który świetnie radził sobie z generowaniem izolowanego kodu, poległ w starciu z całą otaczającą go skomplikowaną i często źle udokumentowaną infrastrukturą.

Lekcja z Tesli: największa jest luka infrastrukturalna

Pierwszy prototyp Autopilota, który potrafił przejechać kilka kilometrów w idealnych warunkach, powstał relatywnie szybko i robił ogromne wrażenie. Jednak prawdziwa praca polegała na uszczelnianiu systemu tak, by odpowiadał na potrzeby chaotycznej rzeczywistości. Chodziło o obsługę nieskończenie „długiego ogona” nietypowych przypadków: oślepiającego słońca pod dziwnym kątem, częściowo startych znaków drogowych, nietypowego zachowania pieszych czy rowerzystów. Dziś cała branża AI boryka się właśnie z tym problemem. Tworzenie efektownych dem, które w kontrolowanych warunkach potrafią napisać wiersz lub fragment kodu, jest proste. Prawdziwym wyzwaniem, które blokuje masowe wdrożenie, jest luka infrastrukturalna.

Przeczytaj także: „Czy autonomiczne pojazdy są już gotowe na przejęcie dróg?” – Karolina Ceroń

Aurora i Waymo intensyfikują testy i rozwój usług, ale branża transportowa i społeczeństwo wciąż zadają fundamentalne pytania: czy technologia naprawdę dorównuje ludzkiemu osądowi? I co, jeśli okaże się, że jednak nie?

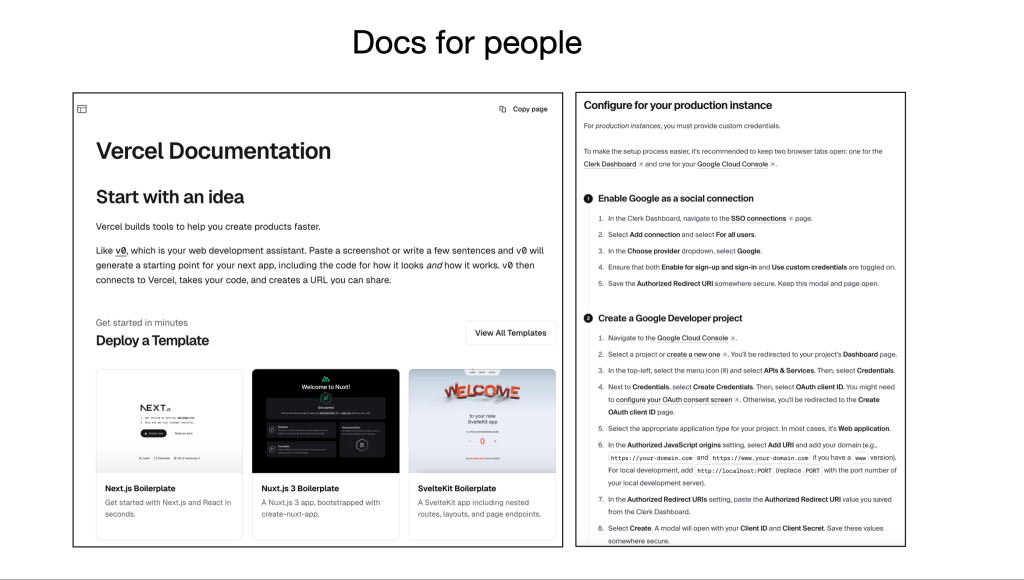

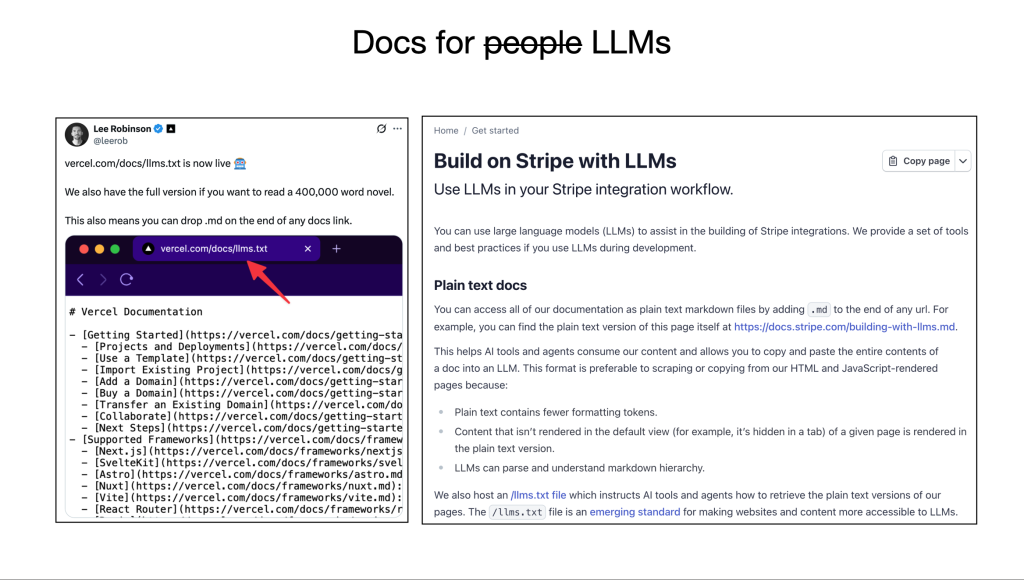

Modele potrafią generować kod, ale nie potrafią działać w świecie cyfrowym, który został zaprojektowany dla ludzi. Nie potrafią czytać niejasnej dokumentacji API, która pełna jest niedopowiedzeń i przykładów zrozumiałych tylko dla człowieka. Nie potrafią „kliknąć niebieskiego przycisku”, ponieważ interfejsy graficzne opierają się na wizualnych wskazówkach, a nie na semantycznej strukturze. Nie potrafią samodzielnie skonfigurować usług chmurowych, ponieważ wymaga to nawigacji przez złożone procesy uwierzytelniania, uprawnień i wieloetapowych konfiguracji. Dlatego – jak przewiduje Karpathy – najbliższe lata zdominuje cichy, ale kluczowy trend, który będzie polegał tworzenie infrastruktury przyjaznej dla AI. I nie chodzi nawet o nowe modele, ale o przebudowę fundamentów. O pisanie dokumentacji nie tylko dla ludzi, ale przede wszystkim dla maszyn – w prostym, ustrukturyzowanym Markdown lub jako pliki konfiguracyjne, z jednoznacznymi instrukcjami. Interfejsy API muszą stać się bardziej opisowe, a interfejsy użytkownika wzbogacone o metadane, które wyjaśnią agentom AI ich funkcję. Firmy, które jako pierwsze dostosują infrastrukturę do współpracy z autonomicznymi agentami, zdobędą ogromną przewagę. Umożliwią one nowej fali automatyzacji działanie na swoich platformach, otwierając się na zupełnie nowy rynek i wykładniczo przyspieszając własne procesy.

Jesteśmy w roku 1960. Co dalej?

W ramach podsumowania: Karpathy stawia nas w konkretnym punkcie na osi czasu. Jesteśmy w latach 60. rozwoju systemów operacyjnych. To, co dziś wydaje się rewolucyjne – monolityczne modele, z którymi komunikujemy się przez okno czatu – za dekadę będzie wyglądać prymitywnie. Tak jak nikt w latach 60. nie był w stanie przewidzieć powstania smartfonów, internetu czy mediów społecznościowych, tak i my nie jesteśmy dziś w stanie w pełni pojąć, dokąd zaprowadzi nas era Software 3.0. Możemy jednak być pewni, że jej wpływ będzie co najmniej podobnych rozmiarów.

Największe szanse leżą w tworzeniu zupełnie nowych klas aplikacji, które radykalnie zdemokratyzują dostęp do technologii – od osobistych tutorów, które adaptują się do stylu uczenia każdego dziecka, po asystentów naukowych, zdolnych formułować i testować hipotezy na podstawie gigantycznych zbiorów danych. Jednocześnie musimy być świadomi fundamentalnych ryzyk. Wysokie koszty obliczeniowe prowadzą do niebezpiecznej centralizacji, co grozi powstaniem cyfrowych monopoli na inteligencję. Podatność modeli na błędy i manipulacje stwarza zagrożenie generowania dezinformacji na masową skalę, co z kolei może podważać społeczne zaufanie. Wreszcie, głęboki wpływ automatyzacji na rynek pracy wymaga od nas fundamentalnego przemyślenia systemów edukacji i siatek bezpieczeństwa socjalnego.

Przesłanie Karpathy’ego jest jasnym wezwaniem do działania. Entuzjazm jest uzasadniony, ale prawdziwa praca polega teraz na budowie kluczowej, choć „nudnej” infrastruktury, która pozwoli AI przejść od etapu spektakularnej nowinki do codziennej, niezawodnej użyteczności. AI nie pełni już roli prądu lecz komputera. I właśnie w tym komputerze będziemy wkrótce budować przyszłość.