Twój koszyk jest obecnie pusty!

Nieumyślna utrata prywatności

Od lat żartujemy, że największym kłamstwem internetu jest „przeczytałem regulamin serwisu i zgadzam się z nim”. Efekt? Pracownicy, którzy wklejają poufne dane klientów w różne narzędzia, nie zdając sobie sprawy, że te dane w rzeczywistości wysyłane są przez API (interfejs programistyczny) do dużych modeli językowych (LLM). Ryzyko? Dane mogą zostać zwrócone innemu użytkownikowi. I to nie tylko na skutek wykorzystania ich do szkolenia modelu, lecz także w wyniku typowych błędów w aplikacjach przeglądarkowych (ChatGPT miał już taki problem).

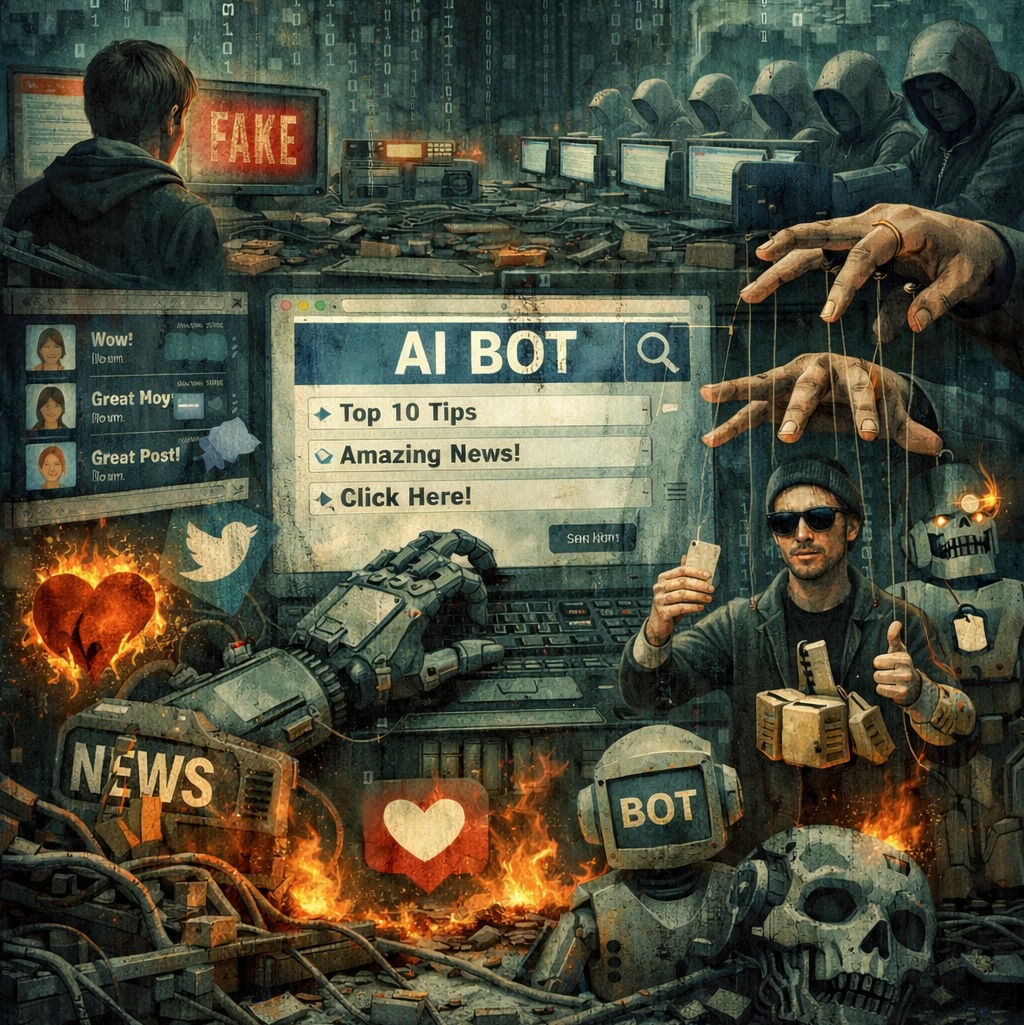

Automatyzacja dezinformacji

Platformy społecznościowe są pełne tzw. użytecznych idiotów, czyli prawdziwych ludzi, którzy amplifikują treści zmanipulowane, bo te w negatywnym świetle stawiają znienawidzonych przez nich polityków. Dzięki dużym modelom językowym, które potrafią szybko tworzyć treści na zawołanie, i to w kilkunastu językach, łatwiej można budować siatki botów, które w czasie rzeczywistym – i co ważne, zupełnie bez udziału człowieka – potrafią prowadzić dyskusję, zachowując konkretną narrację. Czasem tylko, na skutek błędu lub braku ochrony przed atakami wstrzykiwania poleceń (prompt injection), zamiast oczerniać jakąś grupę społeczną, podadzą przepis na sernik.