Twój koszyk jest obecnie pusty!

Czy kiedykolwiek zdarzyło Ci się analizować duże zbiory tekstów? Z pewnością wielu naukowców zgodzi się, że przeszukiwanie stosów dokumentów w poszukiwaniu kluczowych informacji bywa wyjątkowo żmudne. Jednak z wykorzystaniem narzędzi opartych na uczeniu maszynowym i sztucznej inteligencji przetwarzanie, analizowanie i przeszukiwanie nawet ogromnych zbiorów tekstów, które dawniej trwałoby tygodnie, staje się o wiele szybsze. Dzięki temu podczas badań można skupić się na rozpoznawaniu zależności i wyciąganiu wniosków, zamiast na ręcznym przeszukiwaniu danych. Na stronie konsorcjum CLARIN-PL znajdziesz ponad 50 różnych narzędzi online, usprawniających badania tekstów – do czego Ci się przydadzą?

Opracowanie tekstów

Dzięki narzędziom z tej grupy zautomatyzujesz takie procesy jak transkrypcja, poprawa pisowni czy lematyzacja i szybko przekształcisz surowe dane w czysty, znormalizowany materiał gotowy do dalszej analizy.

Automatyczna transkrypcja i przetwarzanie mowy

Narzędzie Mowa umożliwia – co, ze względu na nazwę, chyba niespecjalnie nas dziwi – transkrypcję mowy na tekst. Jeśli w badaniach korzystasz z nagrań rozmów, wywiadów czy przemówień to narzędzie jest z gatunku must have. Nie będziesz musiał dłużej ręcznie przygotowywać transkrypcji, dzięki czemu oszczędzisz mnóstwo czasu i szybko przejdziesz do kolejnych etapów analizy.

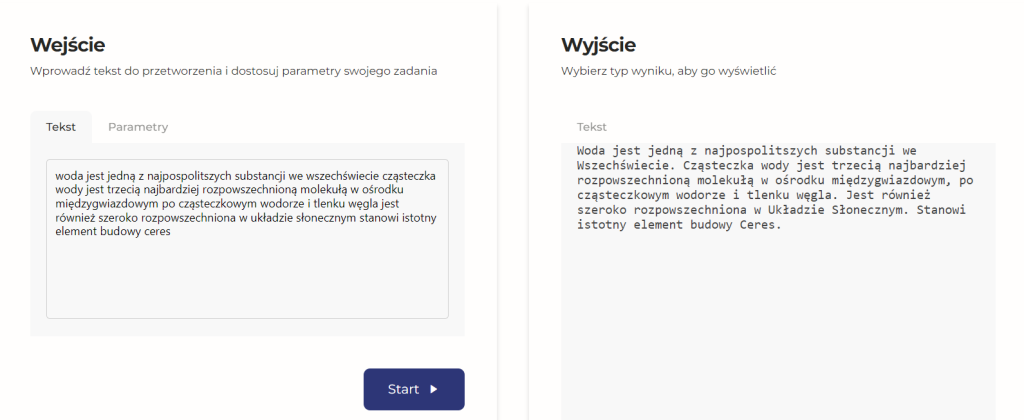

Automatyczne streszczanie tekstów

Summarize i ShortTxTSummary pozwalają na automatyczne tworzenie skrótów tekstów. Pierwsze z narzędzi będzie wyjątkowo pomocne przy przeglądaniu dużych dokumentów, takich jak raporty czy artykuły naukowe. Jeżeli nie wiesz, z którymi materiałami warto się zapoznać lub chcesz zostawić sobie na później podpowiedź-przypomnienie na temat głównych idei w tekstach, z którymi się już zapoznałeś, to narzędzie jest dla Ciebie. Z kolei drugie służy do streszczania tekstów liczących maksymalnie 5000 tokenów, czyli około 400 słów.

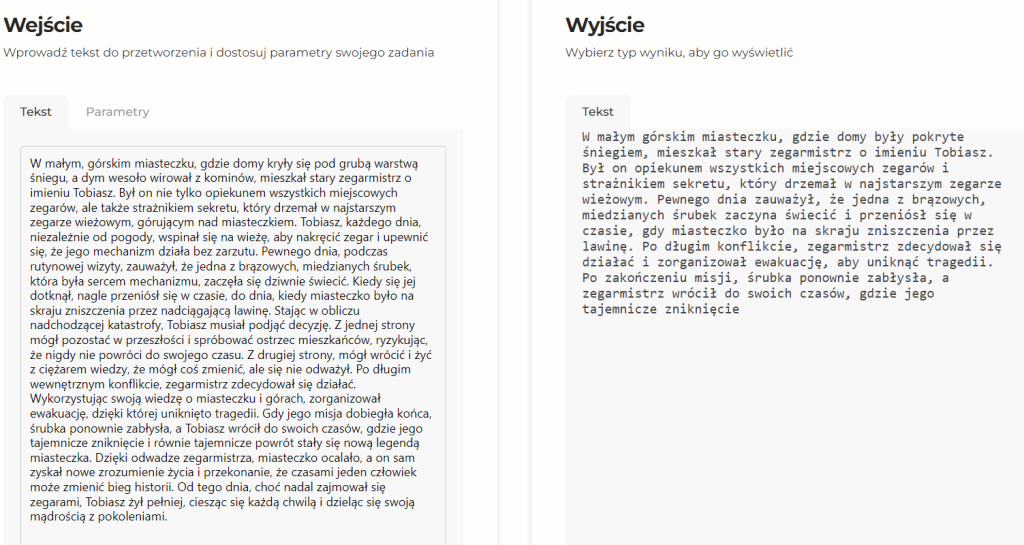

Poprawa tekstów i czyszczenie z elementów zbędnych

Nie jest Ci po drodze ze słownikiem i zasadami pisowni? Speller i Punctuator poprawią za Ciebie ortografię, interpunkcję czy skorygują literówki – zarówno w zgromadzonym materiale badawczym, jak i finalnej wersji Twojego artykułu. Nawet jeśli Twój tekst jest całkowicie pozbawiony znaków interpunkcyjnych, zobacz poniżej!

Anotacja i lematyzacja korpusów

Inforex jest narzędziem do anotacji tekstów. Umożliwia znakowanie różnych elementów, takich jak części mowy, frazy nominalne czy czasowniki w dużych zbiorach danych. Nieocenione okazuje się szczególnie w badaniach lingwistycznych, w których kluczowa jest analiza zależności między różnymi elementami języka. Wystarczy zaznaczyć interesujące Cię fragmenty, by w dowolnym momencie wrócić do nich dzięki określonym tagom. Z kolei Lem i InterLem umożliwiają lematyzację wszystkich wyrazów w zbiorze – czyli przekształcają je do form podstawowych. To przyda się np. podczas analiz tekstów literackich, aby zbadać częstotliwość występowania konkretnych słów bez względu na ich odmiany gramatyczne.

Analizowanie tekstów

Zaprezentowane w tej grupie narzędzia pomagają zrozumieć gramatykę, strukturę, emocje, styl i tematy występujące w dużych zbiorach danych. Dzięki nim możesz szybko odkryć ukryte wzorce i zależności, które mogłyby umknąć przy ręcznym przetwarzaniu danych.

Analiza cech gramatycznych i składniowych

WebSty, Verbs, KonText, Korpusomat, Chronocorpus i ComCorp to narzędzia, które umożliwiają analizę gramatyczną i składniową tekstów. Mogą być wykorzystywane np. w badaniach nad ewolucją języka. Analiza zmian w strukturze zdań w tekstach z różnych okresów może ujawnić zmiany w stylu czy składni. Z kolei wyszukiwanie specyficznych konstrukcji gramatycznych przydaje się w diachronicznych badaniach nad językiem. Nawet już sprawdzono, jak można wykorzystać Korpusomat do analizy języka tekstów prawnych!

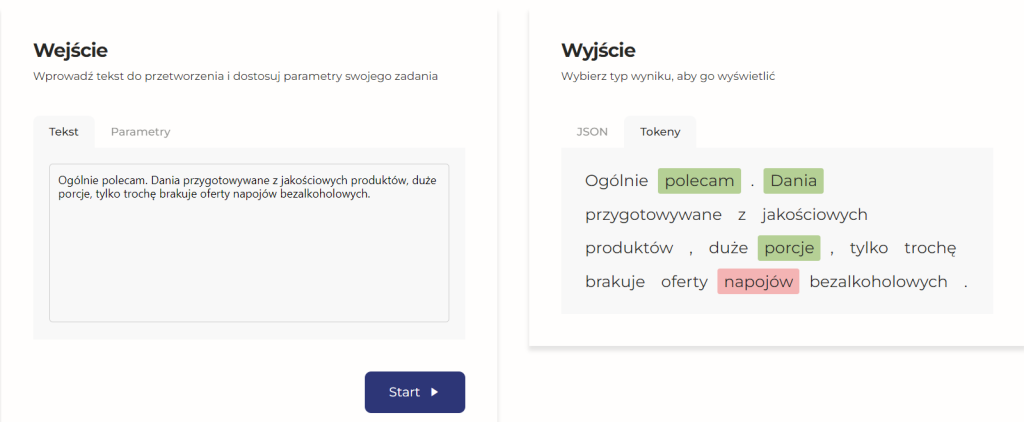

Analiza emocji i wydźwięku

A jakie zabarwienie emocjonalne mają interesujące Cię teksty? Tego dowiesz się, używając Multiemo, Sentemo, AspectEmo i Wydźwięku, które oferują możliwości analizy emocji i sentymentu. W ten sposób możesz przyspieszyć np. analizę nastrojów społecznych na podstawie postów w mediach społecznościowych, artykułów prasowych czy transkrypcji przemówień politycznych. Dodatkowo tego typu analiza ilościowa może być świetnym uzupełnieniem badań jakościowych. Zamiast korzystać z własnych kategoryzacji, poprzyj swoje wnioski mniej podatną na ludzkie błędy i stronniczość automatyczną analizą emocji. Jeśli interesują Cię praktyczne zastosowania tych narzędzi, zajrzyj do artykułu Katarzyny Jarzyńskiej, która przetestowała je do badania fake newsów.

Analiza stylometryczna i tematyczna

WebSty i Verbs są używane do identyfikacji autorstwa tekstów na podstawie charakterystycznych cech stylu pisania lub wydobywania z treści cech poszczególnych idiolektów. Z kolei Topic służy do analizy tematycznej, czyli klasyfikacji treści ze względu na różne występujące w nich tematy. Możemy używać go na przykład w badaniach nad mediami, by przeprowadzić analizę dominujących tematów w artykułach prasowych z danego okresu.

Wyszukiwanie konkretnych informacji w tekstach

Czasem zależy nam po prostu na tym, by jak najszybciej dotrzeć do konkretnej informacji. Narzędzia do wyszukiwania danych w tekstach pozwalają na błyskawiczną identyfikację nazw własnych, słów kluczowych, wyrażeń czasowych czy przestrzennych. Dzięki nim łatwo wydobędziesz najistotniejsze elementy z nawet najbardziej rozbudowanych tekstów. NER identyfikuje nazwy własne i wyrażenia czasowe, Geolocation – określenia przestrzenne, a Inkluz pozwoli Ci szybko wydobyć wyrazy obce z podanych tekstów. Mogą Ci się przydać np. w analizach zapożyczeń/wtrąceń czy badaniach nad historią regionu, dzięki czemu automatycznie zidentyfikujesz odniesienia do miejsc, osób i wydarzeń historycznych.

Praca z korpusami

Kompleksowe narzędzia do pracy z korpusami pozwalają na tworzenie, przeglądanie i zarządzanie dużymi zbiorami tekstów. Dzięki nim możesz porównywać różne korpusy, tworzyć statystyki i analizować dane na nieosiągalnym dotychczas poziomie.

Tworzenie, przeglądanie i statystyki korpusów

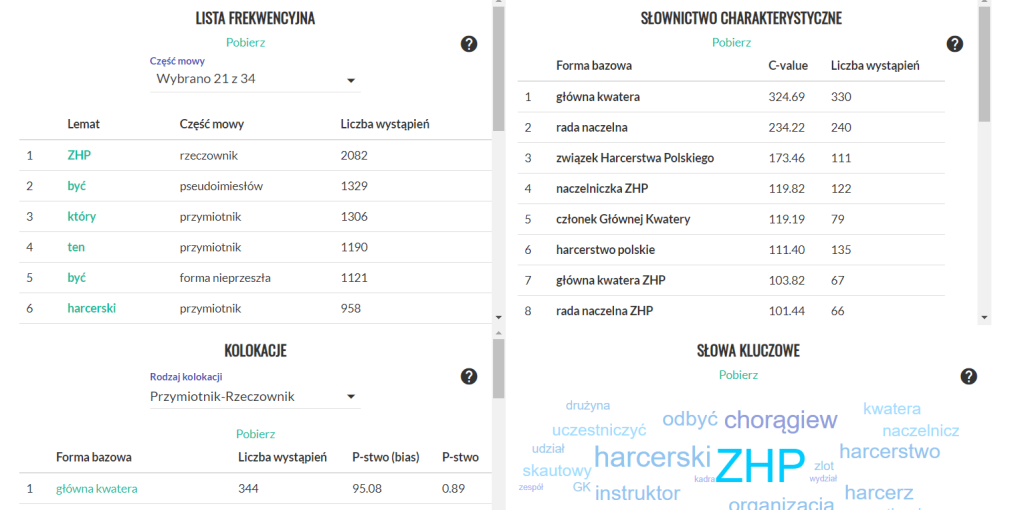

Korpusomat, DSpace, CLARIN Cloud, KonText i Inforex to bezpłatnie dostępne narzędzia, które pozwolą Ci tworzyć korpusy oraz nimi zarządzać. Ich tworzenie jest kluczowe w badaniach lingwistycznych, literackich i społecznych, w których analizy muszą być oparte na dużych zbiorach tekstów. Dzięki nowym narzędziom zgromadzisz wszystkie potrzebne materiały w systematycznej formie i za pomocą specjalnych zapytań będziesz mógł wyszukiwać w nich informacje, których potrzebujesz na danym etapie badań. Niektóre z narzędzi oprócz systemu zapytań mają również automatycznie generowane, systemowe statystyki, np. w Korpusomacie są to lista słów kluczowych, lista frekwencyjna, słownictwo charakterystyczne czy kolokacje. Inforex, Korpusomat i DSpace umożliwiają też łatwe zarządzanie metadanymi, co jest niezbędne przy pracy z dużymi zbiorami tekstów.

Od automatycznej transkrypcji, przez zaawansowane analizy gramatyczne, emocjonalne i tematyczne, aż po zarządzanie korpusami – teraz narzędzia online pozwalają zarówno znacznie oszczędzić czas podczas badań, jak i uzyskać nowe, wartościowe wyniki, które wcześniej były poza zasięgiem tradycyjnych metod analizy. A to jeszcze nie wszystko – pełną listę udostępnianych narzędzi znajdziesz na stronie konsorcjum CLARIN-PL. A jak możesz wykorzystać je we własnej pracy naukowej? Tego dowiesz się podczas warsztatów CLARIN-PL w praktyce badawczej, które odbędą się w Poznaniu już 23-24 września tego roku. Udział jest bezpłatny – wystarczy zarejestrować się do 31 sierpnia 2024 r. przez formularz.