Twój koszyk jest obecnie pusty!

Jeszcze niedawno planowanie rodzinnego wyjazdu oznaczało stos papierowych przewodników, wydruków z forów i kombinowanie, jak przez sześć godzin w aucie nie zwariować. Dziś wystarczy wpisać w okienko ChataGPT „zaplanuj mi wakacje z dwójką dzieci” No, prawie wystarczy.

Bo po uzyskaniu odpowiedzi wypadałoby się też zastanowić, co dzieje się z naszym pytaniem, po zamknięciu apki. Bo ono zostaje na serwerach OpenAI oraz w bazach platform turystycznych. Twoje „wakacje z dwójką dzieci” staje się elementem algorytmu rekomendującego hotele innym rodzicom.

Sztuczna inteligencja w turystyce zyskuje na popularności – według badania Oliver Wyman z 2024 roku 41% konsumentów używa AI w ramach poszukiwania wakacyjnych inspiracji lub do planowania podróży (wzrost z 34% w sierpniu 2023 roku). Z kolei badanie Global Rescue z 2024 roku pokazuje, że 70% użytkowników AI uważa tę technologię za bardzo lub dość użyteczną w planowaniu podróży. Ale co jeśli pewność siebie w używaniu AI jest przedwczesna? Przykład Samsunga pokazuje, że nawet najwięksi gracze mogą stracić kontrolę nad danymi.

W kwietniu 2023 roku Samsung pracownicy firmy nieumyślnie ujawnili poufne dane, poprzez wklejenie ich do ChataGPT. Jeden z inżynierów przekazał wadliwy kod źródłowy, drugi dane do identyfikacji sprzętu, trzeci – informacje o produktach, które dopiero miały zadebiutować na rynku. Najgorszą wiadomością dla Samsunga nie był nawet sam wyciek, lecz niemożność cofnięcia błędu.

W przeciwieństwie do tradycyjnych naruszeń bezpieczeństwa. Danych, które zostały wprowadzone do ChataGPT nie da się po prostu usunąć, bo trafiają do systemu treningowego OpenAI. I tak oto sekrety handlowe dotyczące produkcji półprzewodników stały się własnością intelektualną OpenAI. I w tym momencie mogą pojawić się w odpowiedziach ChataGPT dla innych użytkowników, w tym konkurentów Samsunga. Co więcej, badacze Google DeepMind wykazali, że prostymi komendami można „zmusić” ChatGPT do ujawnienia danych treningowych. Za 200 dolarów na zapytania wydobyli ponad 10 000 unikalnych przykładów zapamiętanych informacji.

W efekcie w maju 2023 roku Samsung zakazała korzystania z generatywnych narzędzi AI na służbowym sprzęcie. W maju 2025 roku częściowo przywrócił dostęp do ChataGPT w wybranych działach, ale z dodatkowymi procedurami bezpieczeństwa. Zespoły rozwoju produktów pozostają całkowicie odcięte od zewnętrznych narzędzi AI.

Gdzie trafiają dane z naszych rozmów

Różne modele AI mają różne polityki prywatności:

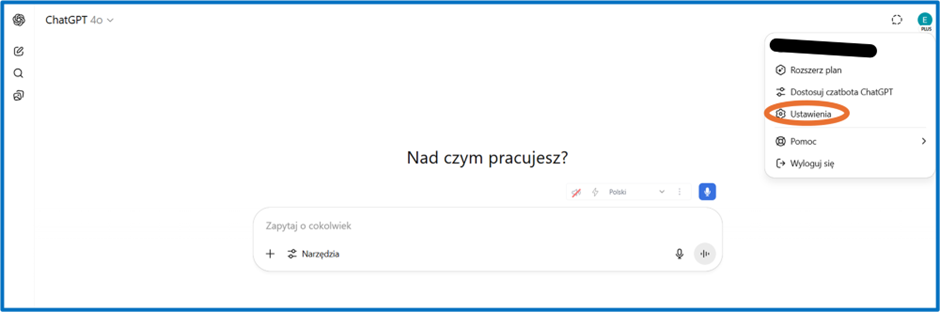

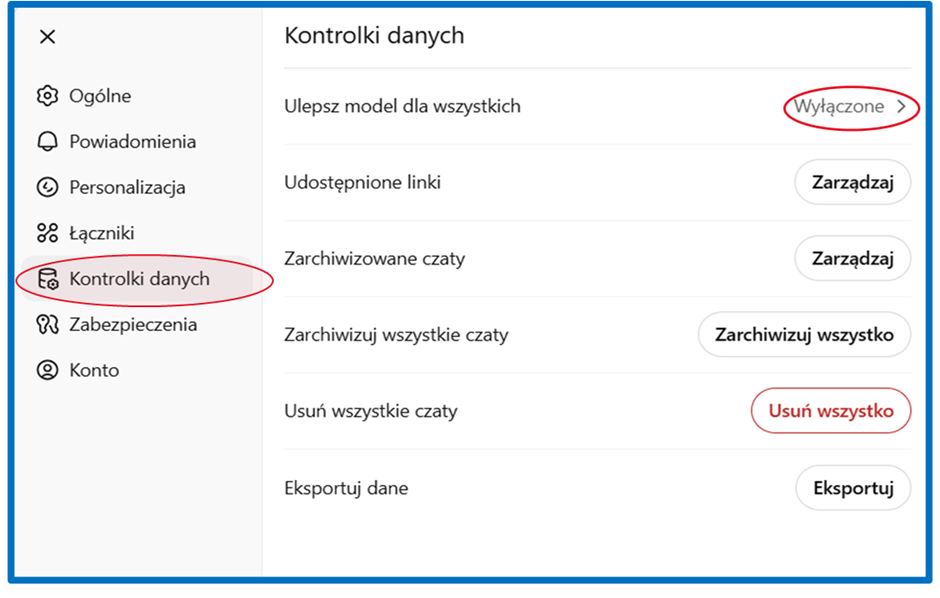

ChatGPT domyślnie wykorzystuje rozmowy użytkowników do dalszego trenowania modeli. Ale można wyłączyć tę opcję w ustawieniach. W tym celu należy przejść do ustawień konta, następnie do zakładki „Kontrola danych” (ang. Data Controls)

i wyłączyć opcję „Ulepszaj model dla wszystkich” (ang. Improve the model for everyone).

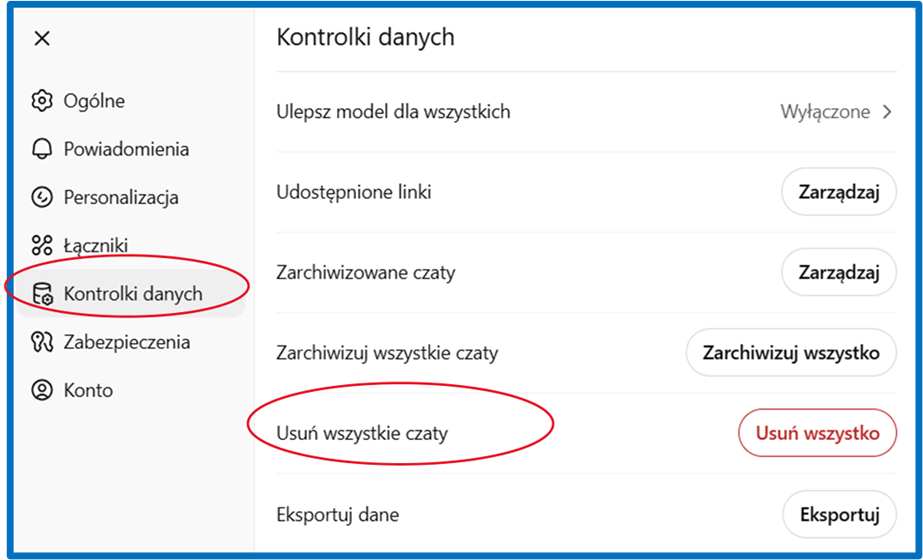

Istnieje też możliwość usunięcia całej historii rozmów. W tym celu należy skorzystać z opcji „Usuń wszystkie czaty” (ang.Clear all chats).

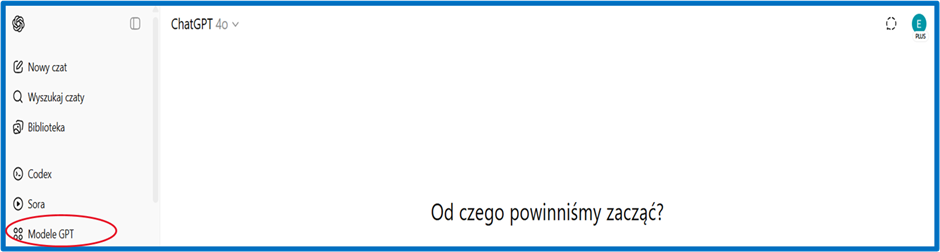

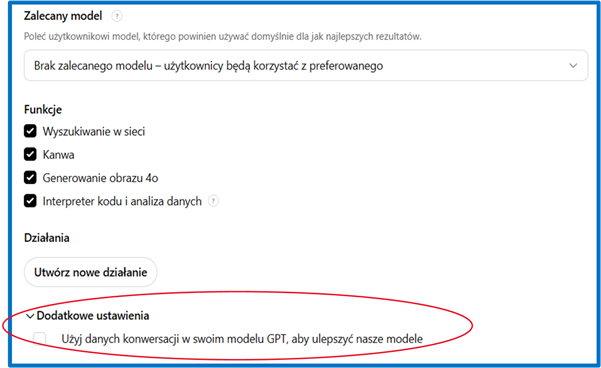

Jeśli korzystasz z własnych asystentów stworzonych w ChacieGPT (tzw. GPTs), warto sprawdzić ich indywidualne ustawienia i wyłączyć opcję „Używaj rozmów do ulepszania GPT” (ang. Use conversations to improve GPT), która domyślnie może być włączona.

Krok 1

Krok 2

Krok 3

Wybierz swojego GPTs i kliknij ikonę ołówka (Edytuj model GPT), co sprawi, że otworzy się panel „Skonfiguruj”, w którym na samym dole znajdziesz dodatkowe ustawienia prywatności. To właśnie tam znajdziesz opcję: „Użyj danych konwersacji w swoim modelu GPT, aby ulepszyć nasze modele”.

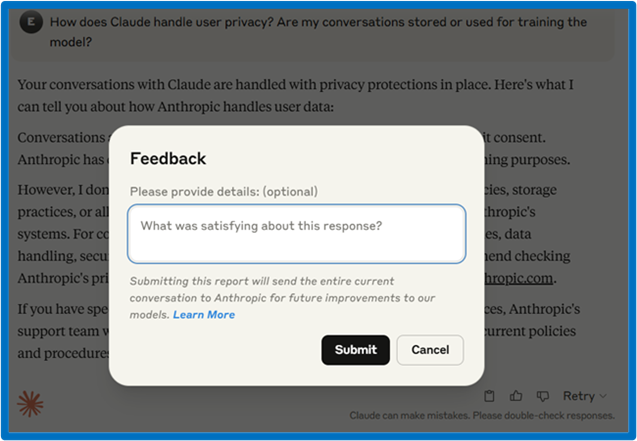

Claude z kolei nie wykorzystuje rozmów do trenowania modelu bez zgody użytkownika. Taką zgodę wyraża się poprzez ocenę odpowiedzi (kliknięcie kciuka w górę lub w dół a następnie kliknięcie “Submit”). Wysłanie takiego formularza oznacza wyrażenie zgody na przekazanie (w celu ulepszania modelu) całej rozmowy do zespołu Anthropic.

Microsoft Copilot w wersji korporacyjnej (Enterprise) również nie zapisuje danych do trenowania modeli. Obowiązują go zasady zgodne z pakietem Microsoft 365. Jednak w wersji konsumenckiej warto sprawdzić ustawienia prywatności konta na stronie account.microsoft.com. W zakładce „Prywatność” można ograniczyć zbieranie i analizę danych.

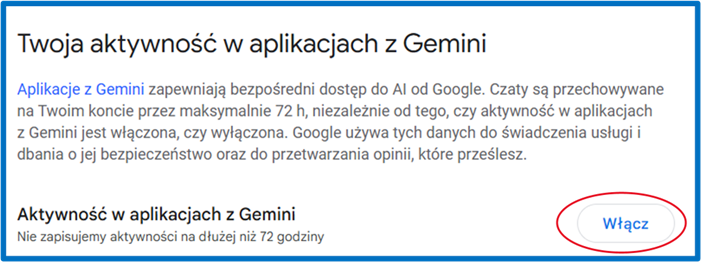

Jeśli korzystasz z konta indywidualnego Gemini, to zapisuje on Twoją aktywność w „Aktywności w aplikacjach Gemini”. Zebrane dane mogą być wykorzystywane do ulepszania modelu i personalizacji usług. Można to jednak wyłączyć.

Krok 1

Wejdź na stronę: https://myactivity.google.com/product/gemini

Krok 2

Na górze znajdziesz przełącznik umożliwiający wstrzymanie zapisywania aktywności. Kliknij „Wyłącz”.

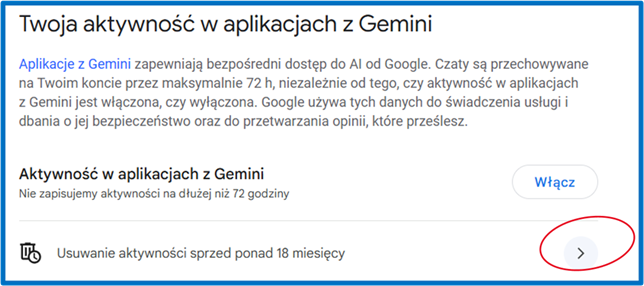

Krok 3

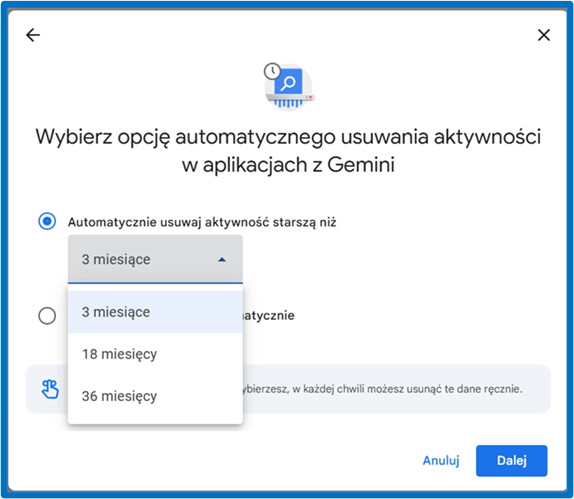

Opcjonalnie: ustaw automatyczne usuwanie aktywności (np. co 3 miesiące) lub ręcznie usuń wybrane rozmowy.

Dla kont firmowych i edukacyjnych (Google Workspace) domyślnie obowiązuje inna polityka, wedle której rozmowy nie są używane do trenowania modeli AI, chyba że administrator domeny wyraźnie zdecyduje inaczej.

Ale nawet jeśli wyłączysz wszystkie dostępne opcje, dane które już przesłałeś, mówią o Tobie więcej, niż myślisz. Na przykład: czy AI wie, że masz dzieci?

To, co dla Ciebie jest kontekstem, dla algorytmu staje się daną osobową. „Jedziemy z dwójką dzieci”, „Córka ma chorobę lokomocyjną”, „Nocleg blisko parku wodnego” – takie wskazówki pozwalają sztucznej inteligencji zbudować Twój profil. I to oczywiście pozwala podsunąć naprawdę trafne propozycje. Problem w tym, że ta sama precyzja profilowania może oznaczać wyższą cenę niż ta, którą zapłaci za identyczny hotel ktoś o innym profilu.

Dynamiczne ceny: ułatwienie czy manipulacja

Twoje wyszukiwania, historia rezerwacji i lokalizacja są analizowane przez systemy dynamicznego ustalania cen. Dlatego czasem cena hotelu zmienia się tylko dlatego, że szukamy go z konkretnego miasta, z iPhone’a albo akurat w godzinach szczytu.

Już w 2012 roku badanie Orbitz pokazało, że użytkownicy komputerów Mac widzieli wyższe ceny noclegów niż użytkownicy PC. Orbitz odkrył, że posiadacze tych pierwszych wydają średnio o 30% więcej na hotele i są o 40% bardziej skłonni do rezerwacji miejsc o wysokim standardzie. Obecnie systemy poszły znacznie dalej. Do wcześniej analizowanych danych – jak typ urządzenia, geolokalizacja czy historia przeglądarki — dołożono bardziej subtelne sygnały: tempo podejmowania decyzji, sposób poruszania się po stronie internetowej czy wzorce klikania. Sztuczna inteligencja pomaga przetwarzać te wszystkie informacje, ale należy pamiętać, że jest tylko jednym z elementów większego systemu. Algorytmy cenowe korzystają z setek zmiennych, by dostosować ofertę do konkretnego użytkownika.

Co na to prawo?

Unijny AI Act wszedł w życie 1 sierpnia 2024 roku. Od 2 lutego 2025 roku zakazane są systemy AI, które tworzą nieakceptowalne ryzyko. Artykuł 5 AI Act definiuje osiem kategorii zakazanych praktyk. To między innymi: systemy manipulacyjne wykorzystujące techniki podprogowe, systemy punktacji społecznej, predykcyjne systemy policyjne czy rozpoznawanie emocji w miejscu pracy. Kary za ich stosowanie, które wejdą w życie 2 sierpnia 2025 rok, mogą sięgać 35 milionów euro lub 7% światowych obrotów.

Firmy muszą szkolić personel i jasno komunikować, jak przetwarzają dane, do czego je wykorzystują i jak będą one przechowywane. W Europie działa również RODO, które daje m.in. prawo do usunięcia danych czy sprzeciwu wobec ich przetwarzania. Tylko że czasem trudno ustalić, kto właściwie te dane przechowuje – zwłaszcza gdy korzystasz z AI przez połączone narzędzia albo firmowe systemy rezerwacyjne.

Jak korzystać z AI na wakacjach i nie zostawiać za sobą zbyt wiele

Sztuczna inteligencja naprawdę potrafi uprościć planowanie wyjazdu. Ale warto podejść do tego z czujnością:

1. Nie wpisuj wszystkiego w jednym miejscu – używaj ogólnych określeń, na przykład „dziecko w wieku szkolnym” zamiast imienia i wieku.

2. Przy wyszukiwaniu lotów i hoteli korzystaj z trybu incognito

3. Porównuj ceny z różnych urządzeń lub lokalizacji

4. Rozmawiasz o sprawach wrażliwych? Wybierz model, który nie trenuje się na danych, taki jak Claude czy Copilot w wersji Enterprise

5. Regularnie usuwaj historię rozmów, zwłaszcza w ChatGPT i Gemini

6. Przy drogich rezerwacjach rozważ wykorzystanie VPN

Rada na czas urlopów

Czasem warto poświęcić pięć minut na sprawdzenie ustawień prywatności, żeby wakacyjny spokój nie skończył się wraz z powrotem do domu.