Twój koszyk jest obecnie pusty!

Żyjemy w czasach zmian, które można porównać do rewolucji przemysłowej z przełomu XVIII i XIX wieku. Ówczesna transformacja oznaczała przejście z gospodarki opartej na rolnictwie i rzemiośle do produkcji przemysłowej, bazującej na maszynach i fabrykach.

Podobnie jak wtedy, także teraz zmiany technologiczne pociągają za sobą istotne wyzwania społeczne i gospodarcze. Można powiedzieć, że stoimy przed takimi samymi i zupełnie i nowymi wyzwaniami. Z jednej strony istnieje potrzeba zapewnienia wysoko wykwalifikowanej i stale rozwijającej się kadry – co w obecnych realiach bywa coraz trudniejsze. Z drugiej strony – konieczność rozwoju AI przy jednoczesnym utrzymaniu kontroli nad kosztami i zasobami obliczeniowymi.

Pamiętacie moment, kiedy organizacje masowo przenosiły swoje systemy do chmur publicznych, takich jak AWS, Google Cloud Platform czy Microsoft Azure? Priorytetem była wtedy szybkość migracji, skalowalność i innowacyjność. I dopiero, gdy zaczęły drastycznie rosnąć rachunki, pojawiła się potrzeba nowego podejścia do zarządzania wydatkami – tak narodziło się podejście FinOps.

FinOps (Cloud Financial Operations) to metodologia, która łączy zespoły finansowe, inżynieryjne i zarządcze we wspólnym celu: by monitorować, kontrolować i optymalizować koszty w środowiskach chmurowych. Nie chodzi jedynie o oszczędności – to przede wszystkim świadome i odpowiedzialne zarządzanie budżetem, przy zachowaniu pełnej przejrzystości, ciągłym doskonaleniu i współdzieleniu odpowiedzialności.

Warto pamiętać, że FinOps to nie jednorazowy projekt, lecz kultura działania oparta na danych, automatyzacji i współpracy. Jest kluczowa dla dużych organizacji, w których chmura stanowi fundament IT.

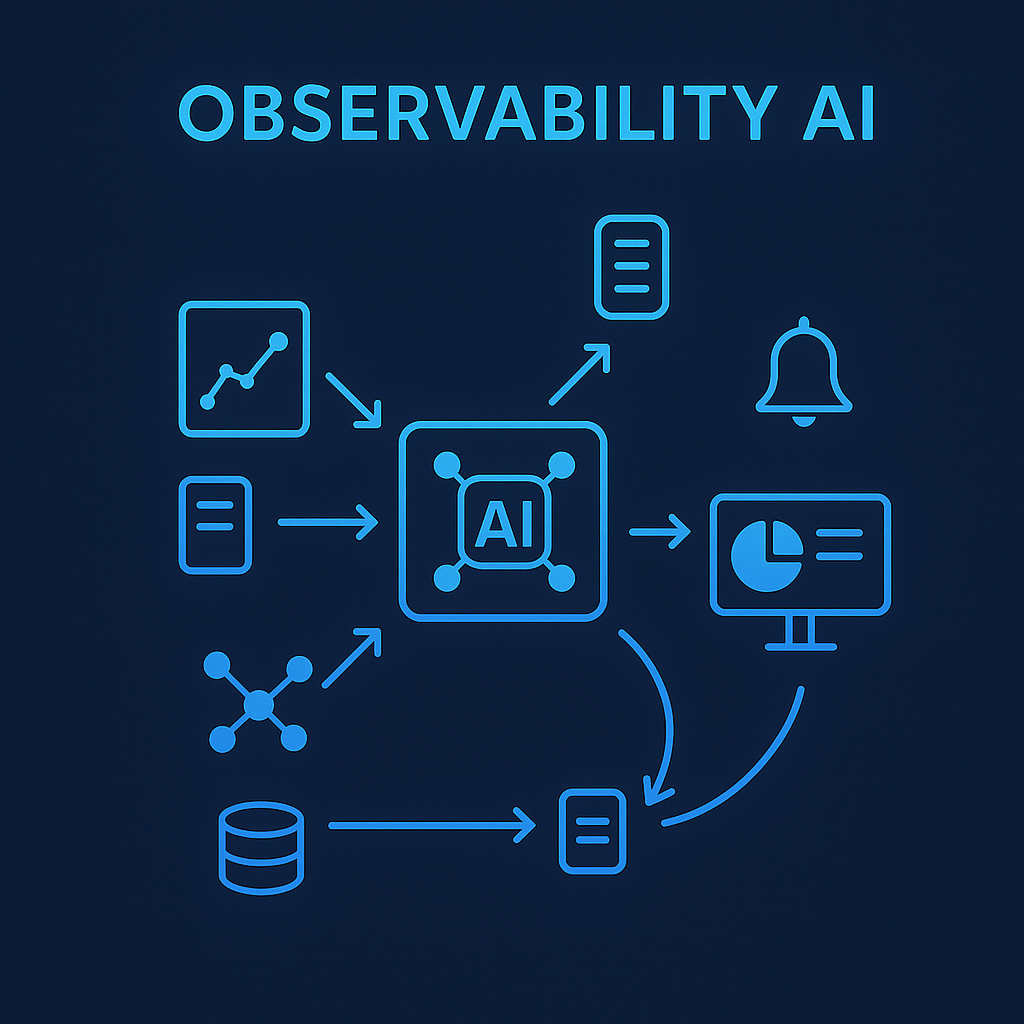

AI i potrzeba obserwowalności

W przypadku AI mówimy o przetwarzaniu ogromnych wolumenów danych, trenowaniu modeli oraz zarządzaniu zasobami obliczeniowymi i pamięcią masową. Właśnie tu pojawia się potrzeba zaawansowanych narzędzi Observability for AI oraz podejścia FinOps, które wspiera monitorowanie zużycia zasobów, kosztów operacyjnych oraz optymalizację ich wykorzystania. Przed tego typu wyzwaniami stoją już nie tylko domeną globalni giganci technologiczni, ale również.

Potwierdzeniem tego jest ogłoszenie o uruchomieniu dużego polskiego modelu językowego – PLLuM-a. Ministerstwo Cyfryzacji lutego 2025 roku zapowiedziało, że ma on wspierać transformację cyfrową administracji i zwiększać dostępność nowoczesnych inteligentnych usług publicznych. Wicepremier i minister cyfryzacji Krzysztof Gawkowski podkreślił, że Polska nie może zostać jedynie konsumentem zagranicznych technologii AI, lecz musi inwestować we własne rozwiązania, które znajdą zastosowanie nie tylko w administracji, ale również w biznesie.

Jeżeli weźmiemy też pod uwagę bardzo dynamiczną sytuację za oceanem, to ruch ministerstwa wydaje się być naprawdę dobrze przemyślany. Unia Europejska już dziś wyraża obawy o to, co stanie się, jeśli Stany Zjednoczone ograniczą nam dostęp do ich usług?

Sztuczna inteligencja jest kluczowym elementem nowoczesnych usług cyfrowych. Jednak do tego, by efektywnie działała na dużą skalę, nie wystarczy tylko moc obliczeniowa infrastruktury. Potrzebne są też narzędzia do monitorowania, optymalizacji i zarządzania jej zachowaniem.

Observability – więcej niż monitoring samych modeli

Często w pracy spotykam się z tym, że organizacje próbują opierać się na narzędziach open source, takich jak ElasticSearch, Grafana czy Prometheus, by budować własne narzędzia monitorujące. I choć potrafią być one dobre, to ich skuteczne wdrożenie wymaga odpowiednio wykwalifikowanej kadry – nie tylko architektów infrastruktury, ale również specjalistów rozumiejących kontekst działania modeli AI, procesów biznesowych, aplikacji itp. To z kolei sprawia, że w praktyce okazuje się, iż rozwój i utrzymanie własnego rozwiązania monitoringowego bywa kosztowniejszy od zakupu gotowego, wyspecjalizowanego produktu.

Istotnym problemem jest również skala. Modele AI, które obsługują tysiące czy nawet miliony zapytań dziennie, muszą działać niezawodnie, a także zgodnie z oczekiwaniami biznesu. Każda anomalia, spadek dokładności czy opóźnienie mogą skutkować nie tylko stratami finansowymi, ale także utratą zaufania użytkowników.

Dzięki observability modeli AI organizacje mogą na bieżąco weryfikować działanie modeli, ich zgodność z oczekiwaniami, zużycie zasobów oraz jakość generowanych wyników. Umożliwia to szybką reakcję na wszelkie anomalie, spadki jakości czy problemy wydajnościowe.

Kluczowe aspekty Observability to:

- Jakość danych wejściowych – nawet najlepszy model nie zadziała bez solidnych danych.

- Dryf modelu (ang. model drift) – zjawisko, które polega na spadku skuteczności modelu wskutek zmiany charakterystyki danych, na których model został wytrenowany.

- Halucynacje modeli – sytuacje, w których model generuje pozornie sensowne, lecz nieprawdziwe odpowiedzi. Szczególnie istotne w przypadku modeli generatywnych, które operują językiem naturalnym.

- Wydajność modelu – określa, czy działanie modelu jest zgodne z ustalonymi wymaganiami SLA, oraz czy odpowiedzi generowane są odpowiednio szybko i dokładnie.

- Zużycie zasobów – monitorowanie pamięci, mocy obliczeniowej, energii – istotne z punktu widzenia kosztów i zrównoważonego rozwoju.

- Koszty operacyjne – analiza, które modele generują najwyższe koszty, a także rozpoznanie obszarów, na których można je zoptymalizować.

- Ślad węglowy (ang. carbon footprint) – istotny aspekt w kontekście strategii ESG oraz odpowiedzialności środowiskowej organizacji.

Obserwacja nie tylko modeli, ale całego ekosystemu

Model AI to jedynie część bardziej rozbudowanego ekosystemu, który obejmuje źródła danych, systemy cache, bazy wektorowe oraz pipeline’y danych. W przypadku zastosowania frameworków opartych o technologię RAG (Retrieval-Augmented Generation), kluczowe staje się kompleksowe monitorowanie baz wektorowych (np. Milvus, Weaviate, Chroma), cache’ów semantycznych oraz ciągła optymalizacja projektowania promptów. Dzięki tym działaniom możliwe jest efektywne zarządzanie zasobami i znaczące ograniczenie ryzyka halucynacji generowanych przez modele.

Frameworki orkiestracyjne, takie jak LangChain, zarządzają przepływami danych w architekturze systemów RAG. Integracja narzędzi Observability opartych na standardach, takich jak OpenTelemetry, umożliwia uzyskanie pełnej widoczności przepływów danych, alokacji zasobów oraz szczegółową analizę przebiegów procesów. Takie podejście umożliwia wczesne wykrywanie problemów wydajnościowych, monitorowanie kosztów operacyjnych, próbkowanie promptów i odpowiedzi, a także precyzyjne mapowanie zależności pomiędzy komponentami systemu. Istotnym aspektem jest unikanie próbkowania danych w obszarze Observability oraz zapewnienie pełnego kontekstu danych (transakcyjność end-to-end).

Wdrożenie technologii generatywnej AI wymaga znaczących inwestycji finansowych oraz technologicznych. Observability umożliwia precyzyjne powiązanie ponoszonych kosztów z realnymi efektami biznesowymi, optymalizację doświadczenia użytkownika oraz wspieranie strategii zrównoważonego rozwoju, m.in. poprzez szczegółowy monitoring śladu węglowego całego systemu AI.

Organizacje muszą aktywnie monitorować i analizować wdrażanie AI. I muszą zdawać sobie sprawę z tego, że to proces a nie jednorazowy projekt. Efektywna implementacja AI wymaga długofalowej zmiany kultury organizacyjnej oraz kompleksowej analizy wszystkich etapów projektowania i dostarczania usług cyfrowych. Observability pozwala powiązać koszty wdrożenia AI z rzeczywistymi celami biznesowymi oraz celami zrównoważonego rozwoju. Dzięki takiemu podejściu firmy mogą tworzyć oparte na AI usługi, które będą efektywne, niezawodne oraz skalowalne.

Dobrym przykładem są organizacje, które dzięki szczegółowej analizie wykorzystania tokenów, optymalizacji projektowania promptów oraz monitorowaniu cache’ów semantycznych skutecznie wykrywają i eliminują problemy, takie jak dryf modeli czy błędy w embedowaniu danych. To podejście pozwoliło Microsoftowi szybko zidentyfikować i rozwiązać poważny problem w usłudze Azure OpenAI, a przy okazji zwiększyć stabilność i wydajność działania modeli.

Przyszłość Observability w kontekście generatywnej AI

Technologie generatywne zmieniają sposób funkcjonowania firm, poprzez wpływanie na ich efektywność i konkurencyjność. Historia pokazuje, że te firmy, które nie potrafią szybko adaptować nowych technologii, ryzykują utratą pozycji rynkowej. Dziś – mimo świadomości zagrożeń, które wiążą się z wdrażaniem GenAI – wiele organizacji nadal nie dysponuje skuteczną strategią ograniczania ryzyka. A to może spowalniać ich rozwój.

Na koniec zadam Ci pytanie:

Czy jesteś pewien, że Twoja AI działa tak, jak myślisz?

Chcesz dowiedzieć się więcej o tym, jak wykorzystać AI do skutecznego monitorowania wydajności i bezpieczeństwa Twoich aplikacji? Odpowiedzi znajdziesz w kolejnym artykule.