Twój koszyk jest obecnie pusty!

Marzec

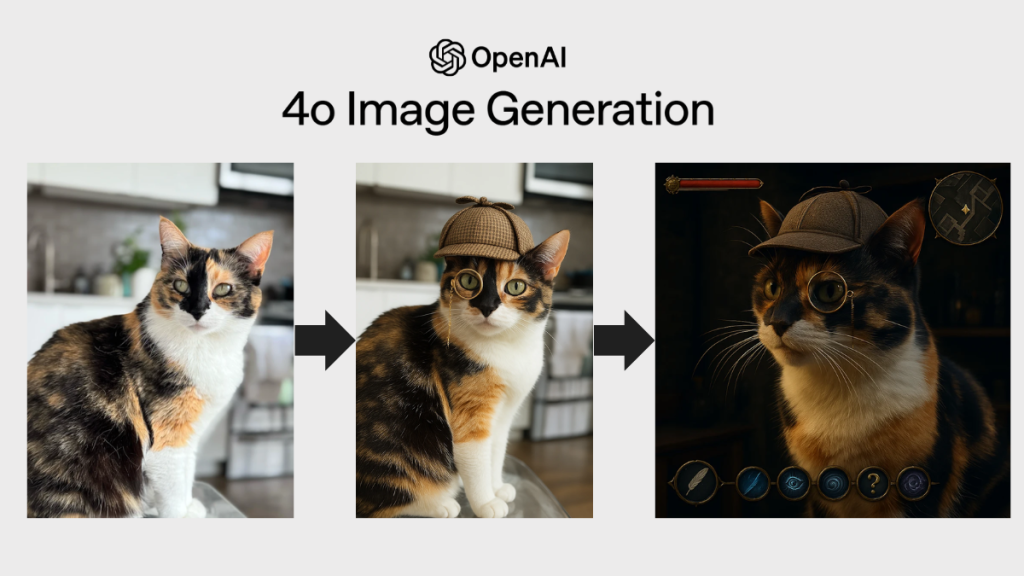

GPT-4o: obraz do poprawki w czasie rzeczywistym

Jeśli luty należał do Sory, to marzec skradł GPT-4o – z nową funkcjonalnością, dzięki której model potrafi nie tylko generować jeszcze lepsze obrazy, ale także edytować je „w locie”. Wystarczy kliknąć dowolny element, aby go usunąć, zastąpić, dodać nowy lub zmienić tło. Szczególnie istotne są usprawnienia w generowaniu tekstów graficznych, które dotąd były piętą achillesową wielu modeli. GPT-4o rozwiązuje ten problem, a dodatkowo potrafi iteracyjnie dopracowywać obrazy w jednej sesji, bez potrzeby korzystania z osobnych aplikacji graficznych. OpenAI deklaruje, że model był szkolony wyłącznie na licencjonowanych danych (np. Shutterstock) i każda wygenerowana grafika zawiera metadane C2PA, co zwiększa transparentność i bezpieczeństwo użytkowania.

Wraz z premierą GPT-4o w sieci rozlała się fala obrazów generowanych w stylu Ghibli –popularność nowej funkcji była tak duża, że OpenAI musiało wprowadzić limity.

Funkcja spotkała się jednak nie tylko z entuzjazmem, lecz także z krytyką. Pytanie o granicę między inspiracją a naruszeniem praw autorskich powróciło z nową siłą – i nie znajdzie łatwej odpowiedzi.

xAI przejmuje X i buduje ekosystem danych

Elon Musk sprzedał platformę X (dawniej Twitter) swojej własnej firmie – xAI (co oznacza, że formalnie traci bezpośrednie właścicielstwo, ale nadal kontroluje platformę przez swoją firmę). Celem transakcji jest uzyskanie przez xAI dostępu do danych setek milionów użytkowników. To z kolei paliwo do rozwoju autorskich modeli językowych, takich jak Grok, i krok w kierunku pełnej niezależności od zewnętrznych źródeł danych. Wycena xAI wzrosła do 80 mld dolarów, co pokazuje, że rynek dostrzega w tym ruchu nie tylko technologiczną, ale i biznesową przewagę.

Kilka dni po ogłoszeniu przejęcia X, Musk zakomunikował kolejny krok – xAI kupił startup Hotshot, specjalizujący się w generowaniu filmów z tekstu. Modele Hotshot-XL, Act One i Benchmark umożliwiają tworzenie animowanych klipów i filmów reklamowych z prostych promptów, co stawia je w jednym szeregu z rozwijanymi przez OpenAI (Sora) i Google (Veo 2) rozwiązaniami.

W efekcie firma Muska ma dziś pełny zestaw zasobów: dane (X), modele językowe (Grok) i komponenty multimedialne (Hotshot). To może oznaczać, że xAI staje się jedną z najpoważniejszych platform all-in-one w świecie AI – i realnym konkurentem dla Google i OpenAI.

Perplexity – wyszukiwanie w nowej odsłonie

Na koniec miesiąca mocny akcent z segmentu wyszukiwania informacji. Perplexity – alternatywa dla Google – zaczyna budować nowy model wyszukiwarki. Zamiast list linków i wyników sponsorowanych, użytkownicy otrzymują interaktywne odpowiedzi: karty z ofertami, karuzele obrazów, wideo i opcję działania bez opuszczania wyszukiwarki.

Szukasz hotelu? Możesz od razu go zarezerwować. Widząc ofertę pracy – aplikujesz jednym kliknięciem. Zakupy, podróże, planowanie wydarzeń – wszystko odbywa się w ramach jednej sesji. Strategia Perplexity opiera się na użyteczności, a nie na systemie reklamowym, który od lat rządzi wynikami Google. Czy to wystarczy, by rzucić wyzwanie gigantowi? Na razie pokazuje, że AI może redefiniować sposób, w jaki szukamy informacji.

Kwiecień

Midjourney V7 – riposta na GPT-4o

Po marcowym boomie na generowanie obrazów GPT-4o Midjourney nie pozostał dłużny – na początku kwietnia wypuścił wersję V7, z nową architekturą, lepszym rozumieniem promptów oraz wyraźną poprawą odwzorowania detali (spójniejsze proporcje ciała, bardziej realistyczne tekstury, dopracowane szczegóły). Nowością jest również możliwość personalizacji stylu oraz edycja wygenerowanych obrazów za pomocą komend głosowych.

OpenAI: nowe modele

W tym samym czasie OpenAI rozpoczęło kwiecień od serii premier technologicznych. Najpierw światło dzienne ujrzał model GPT-4.1 – szybszy, tańszy i zoptymalizowany pod kątem zadań programistycznych. Obsługuje kontekst do 1 mln tokenów, a jego lżejsze wersje – Mini i Nano – oferują wysoką wydajność przy minimalnych opóźnieniach, idealną dla zespołów deweloperskich o ograniczonych zasobach.

Zaledwie dwa dni później OpenAI zaprezentowało modele o3 i o4-mini, ukierunkowane na głębokie rozumowanie, analizę wizualną i rozwiązywanie problemów matematycznych. o3 potrafi analizować wykresy, szkice czy ręczne notatki, a o4-mini zdobywa laury w konkursach AIME. Uzupełnieniem tego ekosystemu jest Codex CLI – otwartoźródłowy agent działający w terminalu, który automatyzuje kodowanie i edycję plików. Modele OpenAI przestają być tylko silnikami – stają się fundamentem nowego środowiska pracy.

Feed jak z Twittera – kolejny krok OpenAI

Właśnie na tym tle – rosnącej funkcjonalności modeli – pojawiły się doniesienia o testach społecznościowego feedu AI, rozwijanego przez OpenAI. Platforma ma przypominać Twittera: z dynamicznym strumieniem treści generowanych przez ChatGPT i możliwością interakcji wizualnych. W kwietniu Sam Altman nie zdradzał jeszcze, czy będzie to osobna aplikacja, czy część ChatGPT.

Meta i Anthropic: uzupełnianie układanki

Na tym dynamicznym tle Meta pokazała własną odpowiedź – rodzinę modeli Llama 4, zbudowaną na architekturze Mixture-of-Experts. Lekki Scout i potężniejszy Maverick obsługują kontekst do 10 mln tokenów i rozumieją obrazy (choć generują tylko tekst). Modele zostały już zintegrowane z WhatsAppem, Messengerem i Instagramem. Na horyzoncie czeka Behemoth – trenowany na 2 bilionach parametrów model, który w testach STEM wyprzedza GPT-4.5. Meta stawia na równowagę między otwartością a kontrolą komercyjnego wykorzystania – budując nie tylko modele, ale politykę wdrażania AI.

Tymczasem Anthropic skoncentrował się na automatyzacji pracy biurowej. Nowa funkcja „Research” w modelu Claude umożliwia przeszukiwanie dokumentów oraz sieci z automatycznym cytowaniem źródeł. Dzięki integracji z Google Workspace, Claude analizuje e-maile, kalendarze i pliki, wspierając planowanie i organizację pracy – tam, gdzie dotąd potrzeba było kilku różnych narzędzi.

Maj

Google I/O 2025: Gemini, obraz, kod i rzeczywistość rozszerzona

20 i 21 maja w kalifornijskim Shoreline Amphitheatre odbyła się konferencja Google I/O 2025 – jedno z najważniejszych wydarzeń branżowych tego roku. Flagową premierą było rozszerzenie możliwości modeli Gemini 2.5 Pro i Flash, które – jak podkreślano – przewyższają konkurencję w zadaniach związanych z kodowaniem, rozumowaniem i multimodalnością. Gemini Pro zyskał tryb „Deep Think” dla pogłębionej analizy i rozumienia kontekstu, natomiast Flash – jego lżejszy, szybszy brat – został zoptymalizowany pod kątem oszczędności tokenów. Oba modele oferują też nowy tryb „Agent Mode”, który pozwala użytkownikom zlecać AI konkretne zadania, takie jak planowanie spotkań czy wyszukiwanie mieszkań. W ramach tej ofensywy Google ogłosiło również nowości w wyszukiwarce: AI Mode, który zamienia klasyczne zapytania w interaktywną konwersację. Użytkownicy mogą teraz np. wirtualnie przymierzyć ubranie czy sfinalizować zakup bez wychodzenia z przeglądarki – całość napędzana przez Gemini. Twórcy z kolei dostali do rąk cały zestaw nowych narzędzi. Imagen 4 to nowy model do generowania obrazów, Veo 3 – narzędzie do tworzenia filmów z dźwiękiem, a Flow – aplikacja do budowania dynamicznych klipów wideo z wykorzystaniem AI. Programiści dostali Julesa – nowego asystenta kodowania, który integruje się z Gemini, przewidując intencje i dopasowując styl kodu do konkretnego projektu. Konferencja miała też swój futurystyczny akcent: prototyp okularów Android XR, rozwijanych we współpracy z Gentle Monster i Warby Parker, oraz zapowiedź systemu Google Beam – trójwymiarowych wideorozmów bez gogli, w czasie rzeczywistym. Google nie tylko pokazało, jak AI może przetwarzać informacje – ale też, jak może je pokazywać.

W tym kontekście warto wspomnieć o AlphaEvolve – systemie zaprezentowanym przez DeepMind niemal równolegle z I/O. AlphaEvolve to AI stworzona do rozwiązywania złożonych problemów matematycznych, naukowych i inżynieryjnych. Działa jak zespół badawczy: generuje rozwiązania, testuje je, wybiera najlepsze i optymalizuje. W testach poradził sobie z 75% problemów z zestawu benchmarkowego, a w 20% przypadków zaproponował lepsze rozwiązania niż znane wcześniej. W jednym z praktycznych zastosowań, system odzyskał 0,7% zasobów obliczeniowych w centrach danych Google’a – co w tej skali przekłada się na olbrzymie oszczędności energetyczne.

Anthropic pokazuje pazur tuż po Google I/O

Podczas gdy cały świat patrzył na nowości od Google’a zaprezentowane na I/O 2025, Anthropic nie próżnowało. Firma zaprezentowała Claude Opus 4 – swój najpotężniejszy model AI, który może pracować nieprzerwanie nawet przez 7 godzin bez utraty spójności. To szczególnie ważne w kontekście rosnącego zapotrzebowania na „agentów AI”, czyli systemy działające autonomicznie, długo i precyzyjnie. Claude 4 potrafi nie tylko pisać kod i analizować złożone dane, ale też samodzielnie sięgać po narzędzia (np. wyszukiwarki, pliki czy środowiska wykonawcze). W testach benchmarkowych wyprzedził konkurencję, co czyni go jednym z najlepszych modeli do kodowania na rynku. Nowością jest funkcja „extended thinking” – tryb głębszego myślenia z użyciem zewnętrznych narzędzi. Claude 4 jest dostępny przez API, Amazon Bedrock i Google Cloud Vertex AI.

OpenAI: chatGPT wkracza w e-commerce i programowanie

Podczas gdy Google rozwijało multimodalność i doświadczenia immersyjne, a Anthropic pokazało najbardziej wytrzymały model do długiej pracy, OpenAI zrobiło krok w stronę konsumenckiego mainstreamu. W maju w ChatGPT pojawiła się nowa funkcja: interaktywny moduł zakupowy. Użytkownicy mogą teraz przeszukiwać produkty, porównywać ceny i kupować bezpośrednio z poziomu czatu.

Równolegle OpenAI udostępniło Codex – potężnego agenta programistycznego, działającego w chmurze. Zasilany przez model codex-1 (wariant o3 zoptymalizowany pod kątem kodowania), Codex potrafi samodzielnie realizować wiele zadań jednocześnie: od pisania funkcji i naprawy błędów po przeprowadzanie testów.

Bielik 2.5: polski agent AI rośnie w siłę

A żeby nie było, że wszystko dzieje się tylko w Kalifornii – polska scena AI też miała swoje pięć minut. Podczas konferencji GOSIM AI Spotlight (6–7 maja, Paryż) zaprezentowano nową generację modelu Bielik 2.5, wraz z dwiema lżejszymi odmianami. Nowe Bieliki potrafią działać jako pełnoprawni agenci – od chatbotów, przez asystentów głosowych, po zaawansowane systemy automatyzacji zadań.