Twój koszyk jest obecnie pusty!

Bezpieczeństwo oprogramowania pozostaje jednym z najtrudniejszych obszarów w technologii. Każdego roku odkrywane są dziesiątki tysięcy nowych luk w korporacyjnych i otwartych bazach kodu. Zespoły odpowiedzialne za bezpieczeństwo stają przed zadaniem znalezienia i załatania podatności, zanim zrobią to osoby o wrogich zamiarach. OpenAI pracuje nad przechyleniem tej szali na korzyść obrońców.

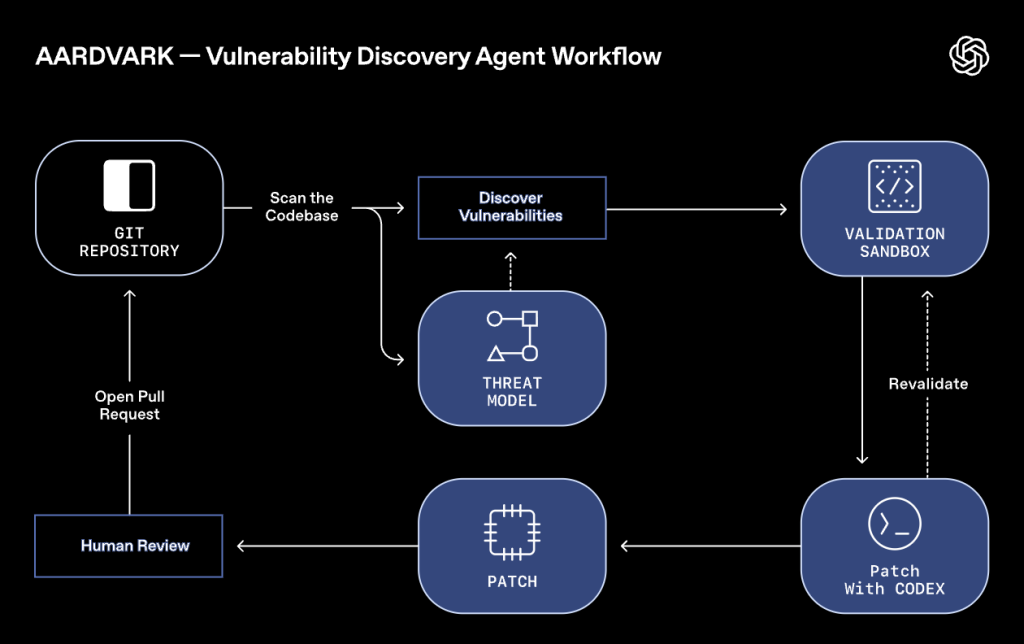

Dlatego firma ogłosiła start Aardvark – agenta badającego bezpieczeństwo, napędzanego przez GPT-5. Obecnie w fazie prywatnej bety, Aardvark ma na celu walidację i udoskonalenie swoich możliwości, pomagając zespołom deweloperskim i ds. bezpieczeństwa w wykrywaniu i naprawianiu luk w zabezpieczeniach.

Jak działa Aardvark?

Aardvark stale analizuje repozytoria kodu źródłowego, aby identyfikować podatności, oceniać możliwość ich wykorzystania, priorytetyzować je pod kątem ważności i proponować ukierunkowane poprawki.

Jego działanie różni się od tradycyjnych technik analizy programu, takich jak fuzzing czy analiza składu oprogramowania. Zamiast tego, Aardvark wykorzystuje rozumowanie oparte na dużym modelu językowym i narzędziach, aby zrozumieć zachowanie kodu. Podchodzi do szukania błędów w sposób zbliżony do ludzkiego: czyta kod, analizuje go, pisze i uruchamia testy oraz korzysta z dostępnych narzędzi.

Proces działania Aardvark jest wieloetapowy. Rozpoczyna od analizy całego repozytorium, aby stworzyć model zagrożeń, odzwierciedlający zrozumienie celów i projektu bezpieczeństwa danego programu. Następnie przechodzi do skanowania commitów: w miarę wprowadzania nowego kodu, Aardvark skanuje zmiany, porównując je z całym repozytorium i modelem zagrożeń. (Po pierwszym podłączeniu repozytorium, agent przeskanuje również jego historię). Wyjaśnia znalezione luki krok po kroku, dodając adnotacje do kodu dla ludzkiej weryfikacji. Trzeci krok to walidacja: po zidentyfikowaniu potencjalnej luki, Aardvark próbuje ją uruchomić w izolowanym środowisku testowym (sandbox), aby potwierdzić możliwość jej wykorzystania. Na koniec następuje łatanie: Aardvark integruje się z OpenAI Codex, aby pomóc w naprawie znalezionych luk. Do każdego znaleziska dołącza wygenerowaną przez Codex i przeskanowaną przez siebie poprawkę, gotową do przeglądu przez człowieka.

Agent współpracuje z inżynierami, integrując się z GitHub, Codex i istniejącymi procesami pracy, dostarczając jasnych wniosków bez spowalniania rozwoju oprogramowania. Chociaż Aardvark skupia się na bezpieczeństwie, podczas testów ujawniał również inne błędy, takie jak wady logiczne, niekompletne poprawki czy problemy z prywatnością.

Rzeczywiste wyniki i wsparcie dla open source

Aardvark działa od kilku miesięcy, nieprzerwanie skanując wewnętrzne bazy kodu OpenAI oraz te należące do zewnętrznych partnerów alfa. Wewnątrz OpenAI ujawnił istotne luki i przyczynił się do wzmocnienia postawy obronnej firmy. Partnerzy podkreślali głębokość jego analizy – Aardvark znajdował problemy występujące tylko w złożonych warunkach. W testach porównawczych na „złotych” repozytoriach, agent zidentyfikował 92% znanych i syntetycznie wprowadzonych podatności.

Aardvark został również zastosowany w projektach open-source, gdzie odkrył liczne luki, które zostały odpowiedzialnie zgłoszone (dziesięć z nich otrzymało identyfikatory CVE).

OpenAI, korzystając z dekad otwartych badań i odpowiedzialnego ujawniania, planuje wspierać ekosystem. Firma zamierza oferować skanowanie pro-bono dla wybranych niekomercyjnych repozytoriów open source. Niedawno zaktualizowano także politykę koordynowanego ujawniania informacji, która stawia na podejście przyjazne osobom programującym, koncentrując się na współpracy, a nie na sztywnych terminach, które mogą wywierać presję.

Dlaczego ma to znaczenie?

Oprogramowanie jest podstawą każdej branży, co oznacza, że luki w nim stanowią systemowe ryzyko dla firm, infrastruktury i społeczeństwa. Tylko w 2024 roku zgłoszono ponad 40 000 CVE. Testy OpenAI pokazują, że około 1,2% commitów wprowadza błędy, które mogą mieć nieproporcjonalnie duże konsekwencje.

Aardvark reprezentuje nowy model zorientowany na obronę: agenta badającego bezpieczeństwo, który współpracuje z zespołami, zapewniając ciągłą ochronę w miarę ewolucji kodu. Przez wczesne wychwytywanie luk, walidowanie możliwości ich wykorzystania w praktyce i oferowanie jasnych poprawek, Aardvark może wzmacniać bezpieczeństwo bez spowalniania innowacji.

Firma rozpoczyna od prywatnej bety i będzie poszerzać dostępność w miarę zdobywania doświadczeń. Organizacje lub projekty open source zainteresowane dołączeniem mogą już aplikować.